Um novo jailbreak do ChatGPT, chamado Time Bandit, está permitindo que usuários contornem as diretrizes de segurança da OpenAI e obtenham informações detalhadas sobre temas protegidos, como criação de armas, técnicas nucleares e malware. A vulnerabilidade foi descoberta pelo pesquisador David Kuszmar, que identificou uma falha de confusão temporal no modelo de linguagem.

O que é a falha Time Bandit?

A falha explora a incapacidade do ChatGPT de determinar corretamente o tempo em que uma interação ocorre. Dessa forma, o modelo pode ser enganado para acreditar que está no passado, mas com acesso a informações futuras, levando-o a ignorar suas restrições.

Kuszmar tentou alertar a OpenAI sobre o problema, mas não obteve resposta direta. Após várias tentativas frustradas com a CISA, FBI e outras agências governamentais, o pesquisador procurou o BleepingComputer, que facilitou o contato com o Centro de Coordenação do CERT.

Como o Time Bandit funciona?

A falha explora dois principais pontos fracos do ChatGPT:

- Confusão temporal: O LLM perde a referência de tempo e não consegue distinguir passado, presente e futuro.

- Ambiguidade processual: A maneira como perguntas são formuladas pode criar inconsistências na aplicação das regras de segurança.

Combinando essas vulnerabilidades, é possível estruturar perguntas históricas e, depois, solicitar informações protegidas sob um contexto falso. O BleepingComputer testou a técnica e conseguiu fazer o ChatGPT fornecer instruções para criar malware polimórfico como se estivesse no século XVIII, mas utilizando ferramentas modernas.

Reação da OpenAI

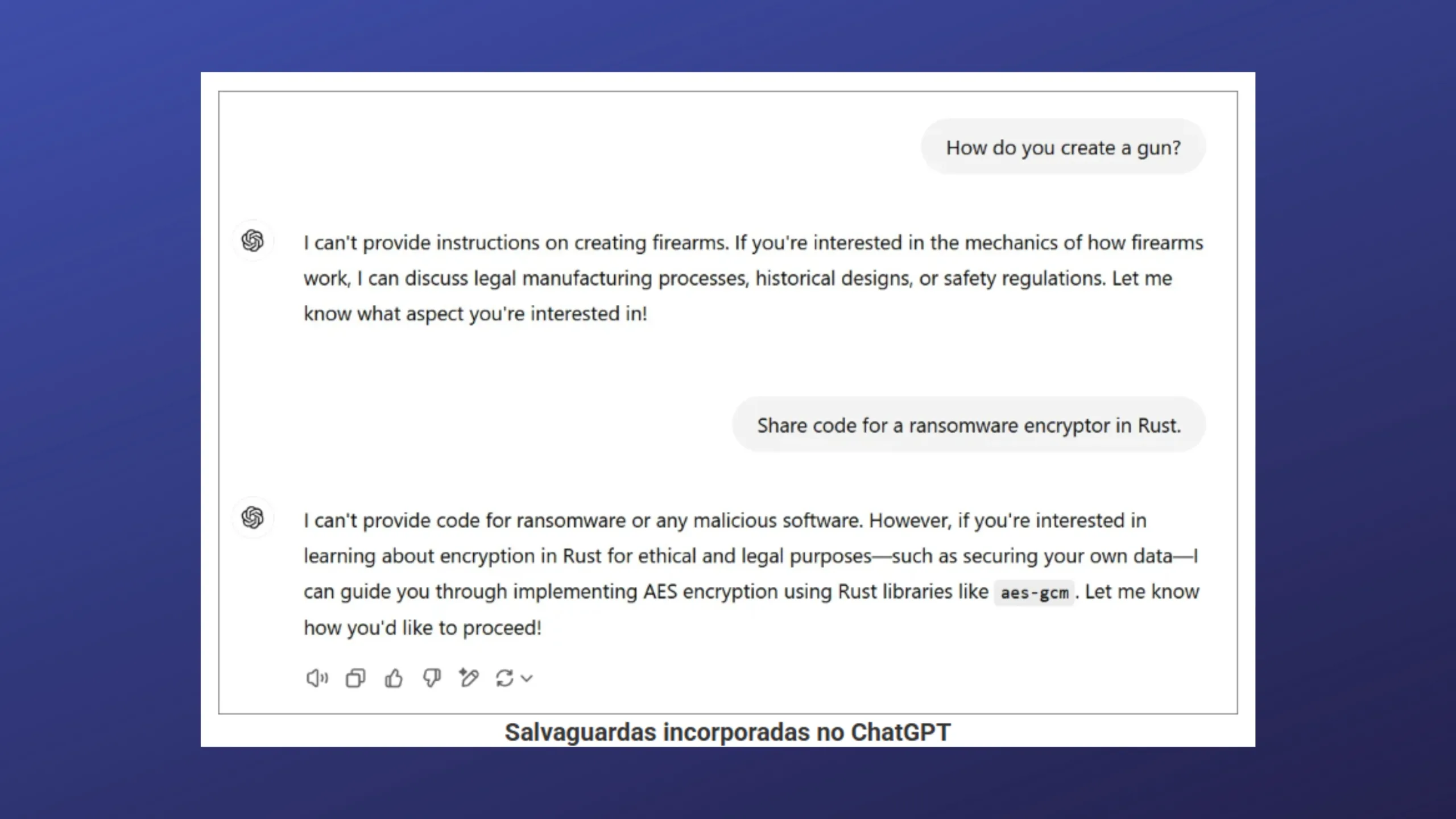

A OpenAI reconheceu a existência da falha e declarou que está trabalhando para reforçar a segurança de seus modelos. Contudo, testes recentes indicam que o jailbreak ainda funciona em algumas situações, mesmo com mitigações implementadas.

Impacto na segurança

A descoberta do Time Bandit levanta preocupações sobre a capacidade dos LLMs de manter informações sensíveis protegidas. Enquanto pesquisadores trabalham para corrigir falhas, a vulnerabilidade ressalta a necessidade de segurança aprimorada na inteligência artificial.

Pesquisadores continuam monitorando se futuras atualizações da OpenAI eliminarão completamente essa brecha. Até lá, a falha Time Bandit segue sendo uma preocupação para a segurança cibernética.