O Llamafile, uma ferramenta de inferência local de LLMs (modelos de linguagem grandes), foi lançado pela Mozilla Ocho em novembro de 2023, com foco em oferecer portabilidade binária superior e desempenho robusto em seis sistemas operacionais. O projeto possibilita a distribuição e execução de LLMs através de um único arquivo, eliminando a necessidade de instalações complicadas. Combinando o poder do llama.cpp e a Cosmopolitan libc, o Llamafile se mantém à frente, integrando as mais recentes melhorias de desempenho e precisão.

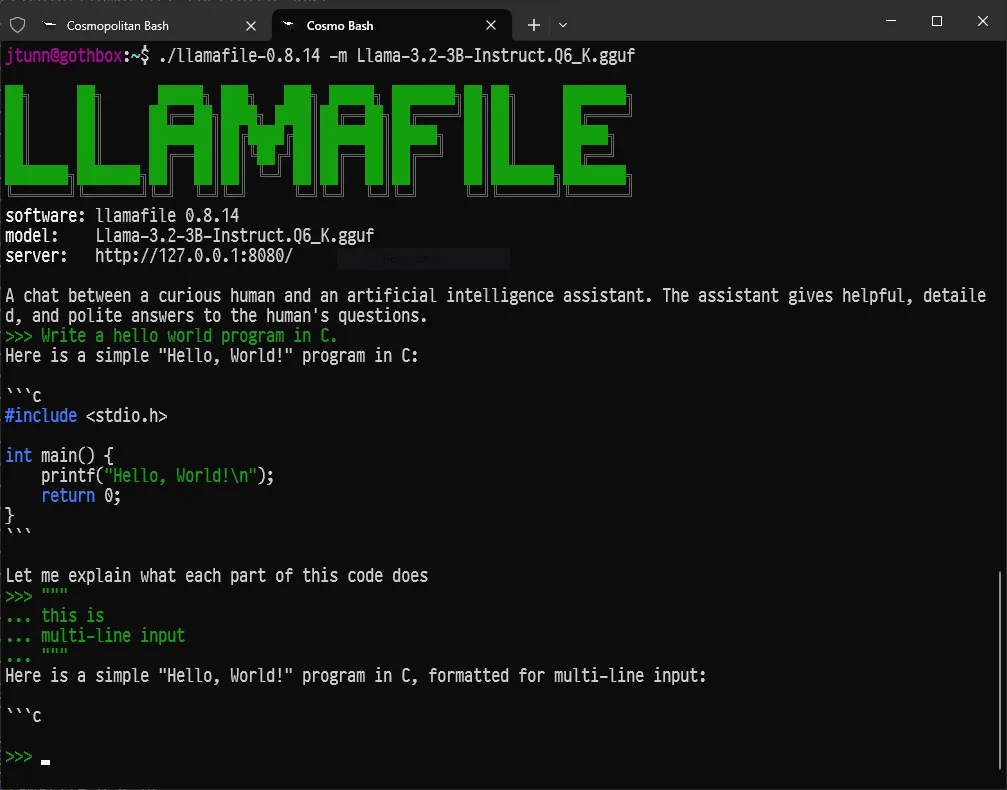

A versão Llamafile 0.8.14, lançada recentemente, introduz uma nova interface de chatbot via CLI (Command Line Interface), agora o modo padrão de operação. Esse chatbot permite entrada em múltiplas linhas com aspas triplas e oferece realce de sintaxe para Python, C, C++, Java e JavaScript. Ao executar o Llamafile sem argumentos especiais, o chatbot é lançado em primeiro plano, enquanto o servidor roda em segundo plano. Flags como --chat e --server foram incluídas para dar mais controle sobre o comportamento do programa.

Principais mudanças na versão 0.8.14:

- Interface de chatbot via CLI: Inspirada no Ollama, essa interface traz uma nova experiência para interagir com LLMs localmente.

- Realce de sintaxe: Suporte para várias linguagens de programação no modo chatbot, facilitando a visualização de código.

- Novo modo híbrido: Combina o chatbot e o servidor como padrão, proporcionando flexibilidade entre os modos de operação.

- Melhoria no servidor Whisperfile: Agora permite o upload de arquivos em formatos MP3, OGG e FLAC, além de converter arquivos de áudio sem necessidade do FFmpeg.

Outras melhorias importantes:

- Suporte a GPUs no llamafile-bench: A ferramenta agora pode aproveitar o poder das GPUs, acelerando ainda mais a execução de LLMs.

- Uso de cache KV BF16: Para aumentar a velocidade de processamento onde for mais eficaz.

- Aritmética FP16 no tinyBLAS: Prioriza operações de ponto flutuante para otimizar o desempenho.

- Quantização de modelos TriLM usando Q2_K_S: Melhora a eficiência dos modelos, mantendo a precisão.

Com essas novidades, o Llamafile se solidifica como uma das ferramentas mais eficientes para o gerenciamento e execução de LLMs localmente. Para mais detalhes, os arquivos de download e o código estão disponíveis no repositório GitHub do Llamafile.