A IA (Inteligência Artificial) tem causado uma verdadeira revolução nos últimos meses, com ChatGPT, Bard e similares gerando manchetes e, alimentando um novo caso de uso que pode melhorar um pouco alguns aspectos de nossas vidas também. Muito se fala nos riscos de usar a essa tecnologia. No entanto, o verdadeiro perigo da IA é o próprio humano, que não a usa como deveria!

Perigo do uso da IA

Felizmente, a IA não dominou o mundo. Na verdade, a ameaça iminente de uma aquisição acelerada da IA talvez tenha diminuído um pouco, pelo menos por enquanto. A verdade é que a maior ameaça vem do fato de que os humanos não entendem muito bem a IA. Se fazendo perguntas estúpidas ou encontrando uma maneira de descarregar nosso trabalho, existe o risco de substituirmos nosso próprio pensamento crítico por uma alternativa que ainda não está equipada para isso.

O que a IA realmente é (e o que não é)

A IA não é realmente inteligente, pelo menos ainda não, eles são muito bons em nos enganar fazendo-nos acreditar que são. Seja ChatGPT, Bard, Bing ou similar, esses são grandes modelos de linguagem (LLMs) que se especializam essencialmente na geração de texto semelhante ao humano. O que isso significa, em um nível muito bruto, é que eles são extremamente bons em modelar estatisticamente a próxima palavra provável (ou token) que aparece em uma frase. Graças às faixas de dados de treinamento, essa mesma modelagem estatística não é boa apenas para escrever frases; torna-se muito mais criativo e útil.

O que esses modelos certamente não são, apesar de suas respostas geralmente impressionantes, é inteligência de propósito geral. Com os conjuntos de dados muito mais massivos de hoje, os modelos são ainda melhores em conjurar respostas precisas de uma ampla gama de entradas.

A matemática é outro exemplo muito bom para ajudar a entender esse ponto. Os LLMs não calculam como um computador tradicional; nenhum processador de processamento de números garante uma resposta correta. Também não funciona como o nosso cérebro. Em vez disso, os LLMs executam a matemática essencialmente da mesma maneira que geram texto, gerando o próximo token estatisticamente mais provável, mas isso não é o mesmo que calcular a resposta.

No entanto, a revelação fascinante é que quanto mais dados você fornecer a um LLM, melhor ele simulará como fazer matemática (entre outras coisas). É por isso que GPT-3 e 4 são magnitudes melhores do que GPT-2 em aritmética simples de dois e três dígitos e pontuam muito mais alto em uma ampla variedade de testes. Não tem nada a ver com ser mais capaz de uma perspectiva tradicional de processamento de dados, mas sim com o fato de terem sido treinados com muito mais dados.

Vamos parar de fazer essas perguntas estúpidas à IA

Precisamos de uma melhor compreensão desses pontos fortes e armadilhas antes de colocar a IA em prática. Seria tolice pedir a uma IA para escrever seu curso de ciências. É improvável que você entenda as equações corretamente e, mesmo assim, produzirá uma resposta estereotipada. E seria totalmente irresponsável aceitar conselhos financeiros dela. Mas mesmo questionamentos aparentemente mais banais também podem ser problemáticos.

Embora possa ser divertido provocar reflexões sobre tópicos controversos ou enganá-lo para uma resposta errada, compartilhar o que é equivalente a uma sequência de texto probabilística como qualquer coisa próxima a uma opinião genuína está além da ignorância.

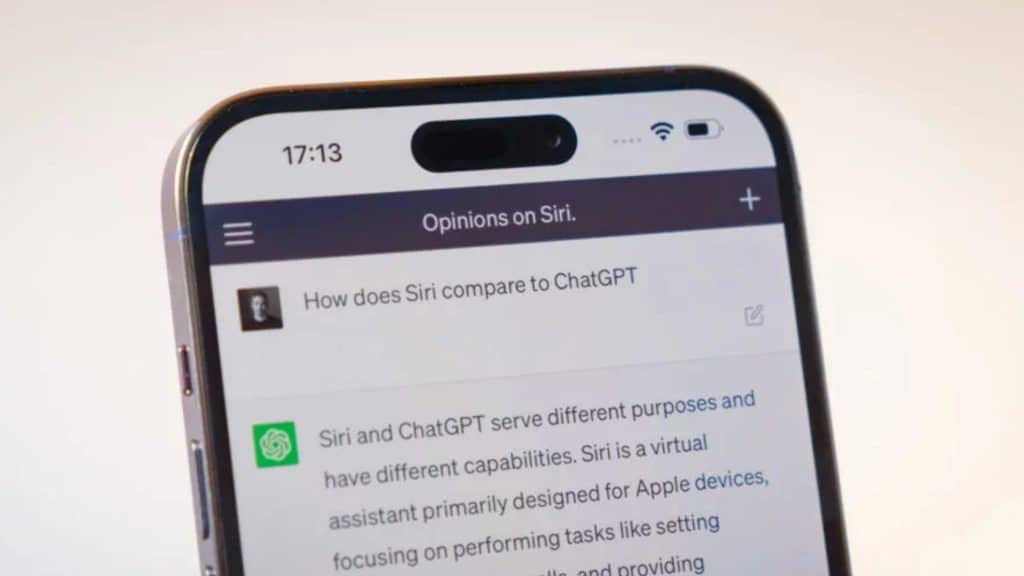

Se você perguntar a um chatbot uma preferência ou fazer uma comparação, ele não está tirando de seus próprios pensamentos, um vasto cofre de conhecimento humano ou mesmo uma opinião coletivista escondida dentro de seu conjunto de dados. Em vez disso, está modelando estatisticamente o que determina ser a resposta de texto ideal que pode produzir para sua consulta, mas isso é muito diferente de pensar em uma resposta genuína. Por isso, esses modelos são copiados para filtrar consultas e respostas para as quais o modelo realmente não foi criado. Mesmo que você possa provocar tal resposta, eles certamente devem ser ignorados.

Em suma, não devemos confundir uma resposta humana com um pensamento humano. Isso não diminui a impressão do simulacro de IA e as faixas de casos de uso emergentes para os quais eles são genuinamente úteis. Mas, em última análise, há muitos tópicos de IA mais emocionantes e existenciais para refletir do que suas preferências em cadeias de fast food e marcas de grife. Não vamos entregar nosso pensamento crítico a um preditor de texto sofisticado.