Pesquisadores de segurança cibernética identificaram duas graves vulnerabilidades na plataforma de aprendizado de máquina Vertex AI, do Google. Essas falhas podem permitir que invasores escalem privilégios e extraiam dados confidenciais, colocando modelos ajustados e informações proprietárias em risco.

Pesquisadores revelam falhas críticas no Vertex AI do google

O Vertex AI é uma plataforma usada para treinar e implantar modelos de machine learning em larga escala. Um dos principais componentes afetados é o Vertex AI Pipelines, uma ferramenta para automação e monitoramento de fluxos de trabalho MLOps.

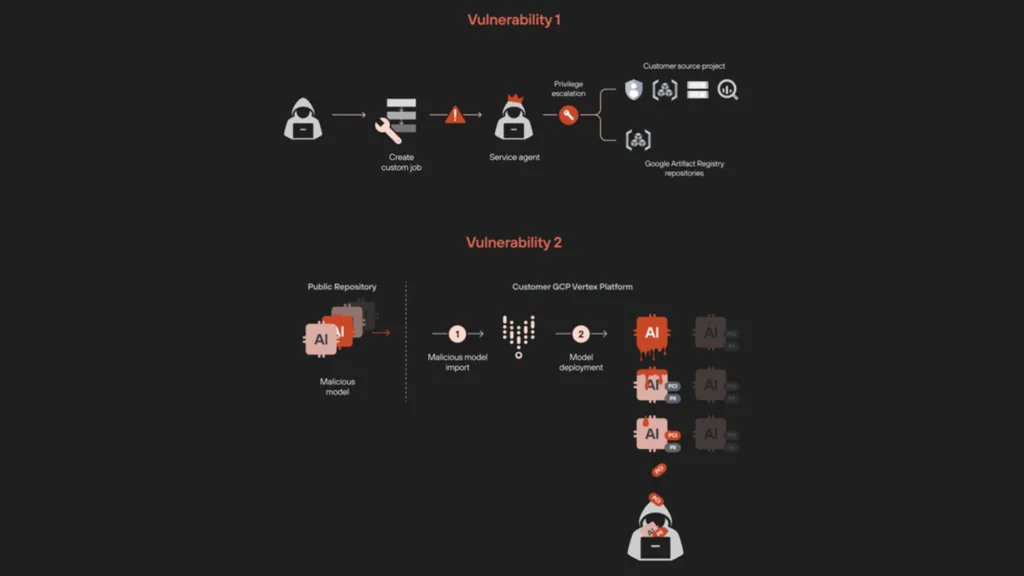

Os pesquisadores da Unidade 42 da Palo Alto Networks, Ofir Balassiano e Ofir Shaty, descobriram que, manipulando permissões de trabalhos personalizados, invasores podem:

- Criar um shell reverso para obter acesso remoto ao ambiente;

- Listar contas de serviço, acessar buckets de armazenamento e explorar tabelas do BigQuery, ampliando o alcance do ataque.

Outro vetor de ataque envolve o uso de um modelo malicioso, que, quando implantado, explora permissões para acessar clusters Kubernetes e executar comandos arbitrários. Isso possibilita extrair dados confidenciais diretamente de contêineres associados aos modelos.

Riscos para dados proprietários

As vulnerabilidades também permitem que invasores exportem modelos de linguagem (LLMs) e seus adaptadores ajustados. Esses modelos podem ser carregados em repositórios públicos, facilitando ataques em grande escala.

“Uma única implantação de modelo comprometido pode expor todo o ambiente de IA, resultando na exfiltração de dados sensíveis”, alertaram os pesquisadores.

Medidas de proteção

Após a divulgação responsável, o Google corrigiu as falhas, mas especialistas recomendam:

- Implementação de controles rigorosos em implantações de modelos;

- Auditoria contínua de permissões de usuários e serviços;

- Uso de práticas seguras ao gerenciar pipelines e permissões IAM.

Outras ameaças em inteligência artificial

Além das falhas no Vertex AI, pesquisadores da Mozilla destacaram interações intencionais no ambiente sandbox do ChatGPT, da OpenAI. Embora a execução de códigos Python e movimentação de arquivos sejam consideradas recursos esperados, o comportamento reforça a importância de proteger ambientes de IA contra possíveis explorações indevidas.

A rápida evolução da IA demanda que organizações permaneçam vigilantes, fortalecendo suas práticas de segurança para mitigar riscos e proteger dados sensíveis.