A Microsoft acaba de anunciar que fez uma parceria com a StopNCII para remover proativamente imagens e vídeos íntimos (pornografia de vingança) prejudiciais do Bing usando hashes digitais que as pessoas criam a partir de suas mídias confidenciais.

Pornografia de vingança removido da pesquisa do Bing

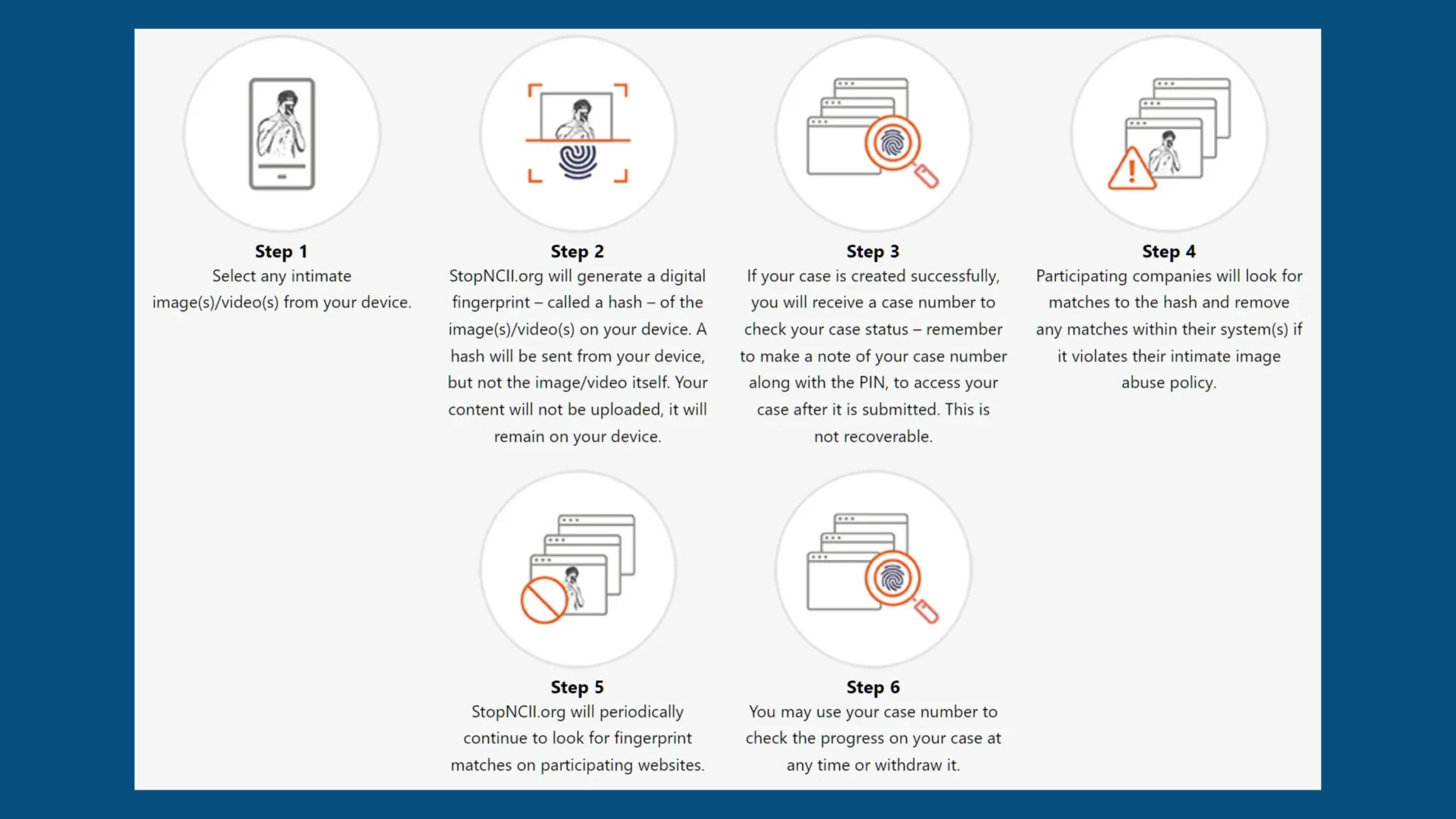

StopNCII é um projeto operado pela Revenge Porn Helpline que permite que as pessoas criem hashes digitais de suas fotos e vídeos íntimos sem fazer upload da mídia de seus telefones. StopNCII então adiciona esses hashes a um banco de dados usado para encontrar as mesmas imagens ou imagens semelhantes online, que são então removidas por seus parceiros, incluindo Facebook, TikTok, Reddit, Pornhub, Instagram, OnlyFans e Snapchat.

Em março, a Microsoft compartilhou sua tecnologia PhotoDNA com a StopNCII, permitindo a criação aprimorada de hashes digitais sem que as imagens ou vídeos de uma pessoa saiam de seu dispositivo.

Assim como a tecnologia de hash que o StopNCII.org já usa (PDQ), o PhotoDNA é um processo adicional que permite que imagens prejudiciais identificadas sejam transformadas em uma impressão digital, que pode então ser compartilhada com plataformas do setor para identificar e remover qualquer material de abuso de imagem íntima não consensual.

De acordo com a Microsoft, eles têm pilotado o uso do banco de dados de hashes do StopNCII para remover imagens íntimas dentro do índice de busca do Bing. Usando esse banco de dados, a Microsoft diz que eles tomaram medidas em 268.899 imagens até o final de agosto.

A ascensão da inteligência artificial também levou a uma geração crescente de imagens de nudez deep fake a partir de fotos não íntimas compartilhadas online. Embora essas imagens sejam falsas, elas podem ser igualmente angustiantes para aqueles que estão sendo explorados. Um relatório de 2019 (Via: Bleeping Computer) da DeepTrace, agora Sensity, mostrou que 96% dos vídeos deepfake na internet são pornográficos por natureza e quase todos apresentam uso não consensual da imagem de uma mulher. Muitas dessas imagens são carregadas como “pornografia de vingança”, para extorsão ou para gerar receita por sites inescrupulosos.

Infelizmente, imagens geradas por IA dificultam a correspondência com hashes do PhotoDNA. Nesses casos, os afetados devem reportar manualmente as imagens à Microsoft, Google e outras empresas de mídia online. A Microsoft diz que as pessoas afetadas podem usar a página Relatar uma Preocupação para solicitar que imagens reais ou sintéticas sejam retiradas do índice de pesquisa do Bing.

Via: Bleeping Computer