Como sabemos, o Facebook é uma das maiores empresas de tecnologia do mundo. Neste artigo, entenda como o próprio Facebook desenvolve uma IA de regeneração de voz impressionante.

Desenvolvendo métodos para copiar com precisão

Aconteceram muitos avanços em técnicas de machine learning nos anos recentes. Estas técnicas se saíram muito bem em reconhecer objetos, rostos e gerar imagens realistas.

No entanto, quando se trata de áudio, a inteligência artificial (IA) é um desapontamento. Até mesmo os melhores sistemas e texto-para-voz não têm características básicas, como mudanças na entonação. Você já ouviu a voz gerada por computador de Stephen Hawking? Às vezes, ficava muito difícil entender suas falas.

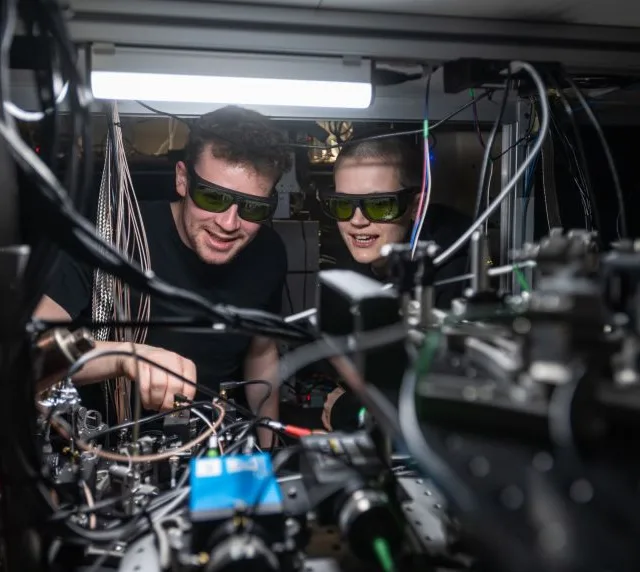

Agora, cientistas do Facebook AI Research desenvolveram um método para superar as limitações dos sistemas texto-para-voz existentes. Eles construíram um modelo gerador – chamado MelNet – que consegue produzir a entonação humana com incrível precisão. De fato, pode falar fluentemente com a voz de qualquer pessoa.

Como o MelNet é diferente das máquinas de fala existentes?

A maioria dos algoritmos de deep-learning são treinados com grandes bancos de dados de áudio para regenerar os padrões da fala real. O maior problema com essa metodologia é o tipo de dado. Tipicamente, esses algoritmos são treinados com as ondas da gravações do áudio, que têm estruturas complexas com variações consideráveis.

Essas gravações representam como a amplitude do som varia com o tempo: um segundo de áudio contém dezenas de milhares de intervalos de tempo. Tais ondas sonoras refletem padrões particulares em um número de escalas diferentes.

Modelos regenerativos existentes de formas de onda (como SampleRNN e WaveNet) somente conseguem melhorar previsões de dados com exatidão em uma fração de segundo. Portanto, eles não conseguem capturar a estrutura de alto nível que surge na escala de vários segundos.

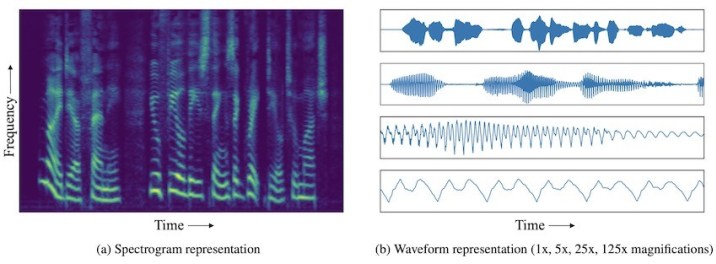

MelNet, por outro lado, usa espectrogramas (ao invés das ondas do áudio) para treinar redes de deep-learning. Espectrogramas são representações em 2D de tempo-frequência que mostram o espectro inteiro de frequências de áudio e como elas variam com o tempo.

Enquanto formas de onda do domínio 1D de tempo capturam as mudanças com o tempo através de uma única variável (amplitude), espectrogramas capturam mudanças em diferentes frequências. Deste modo, a informação do áudio é empacotada mais densamente em espectrogramas.

Isso possibilita que o MelNet produza discurso incondicional e amostras de música com consistência por vários segundos.

Os resultados da IA que o Facebook desenvolve são impressionantes

Os pesquisadores treinaram o MelNet em numerosas palestras do Ted e ele foi capaz de regenerar a voz do palestrante dizendo frases aleatórias por alguns segundos. Veja no GitHub alguns exemplos do MelNet usando a voz de Bill Gates para dizer frases aleatórias.

Mais exemplos estão disponíveis neste link.

Embora o MelNet crie clipes de áudio notavelmente reais, ele não é capaz de gerar frases mais longas ou parágrafos. Contudo, o sistema pode melhorar a interação computador-humano.

Muitas conversas no atendimento ao cliente envolvem frases curtas. O MelNet pode ser usado para automatizar tais interações ou substituir o sistema atual de voz automática para melhorar a experiência da pessoa que telefona.

Um aspecto negativo é que a tecnologia aumenta o espectro de uma nova era de conteúdos em áudios falsos. E, como outros avanços na inteligência artificial, isso levanta mais questões éticas do que as responde.

Em suma, o fato de que o Facebook desenvolve uma IA capaz de regenerar a voz traz muitas contribuições às técnicas de machine-learning e deep-learning.

E você, gostou dessa ferramenta incrível?

Leia sobre a Libra, a criptomoeda do Facebook.