Para impulsionar a nova onda de data centers de Inteligência Artificial (IA), a NVIDIA anuncia sua plataforma de computação acelerada de última geração com a arquitetura NVIDIA Hopper™ proporcionando, um imenso salto de desempenho em relação à antecessora.

Batizada em homenagem a Grace Hopper, cientista da computação pioneira nos EUA, a nova arquitetura é a sucessora da arquitetura NVIDIA Ampere, lançada há dois anos.

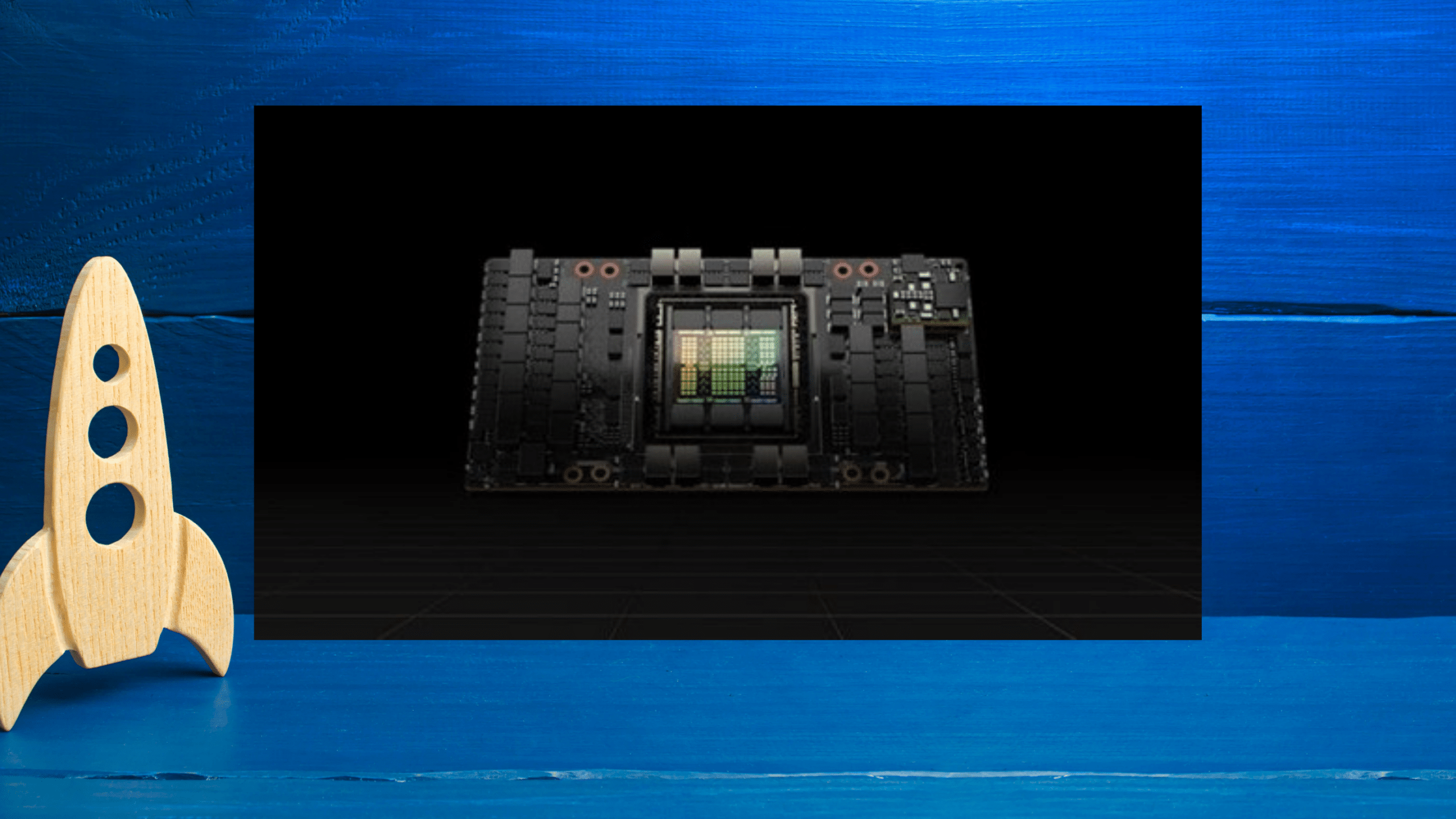

A empresa também anuncia a primeira GPU baseada na Hopper, a NVIDIA H100, com 80 bilhões de transistores. O maior e mais potente acelerador do mundo, a H100 tem recursos inovadores, como um revolucionário engine Transformer e uma interconexão NVIDIA NVLink® altamente dimensionável para o avanço de gigantescos modelos de linguagem de IA, sistemas de recomendação profundos, genômica e digital twins complexos.

“Os data centers estão se tornando fábricas de IA, processando e refinando montanhas de dados para produzir inteligência”, conta Jensen Huang, fundador e CEO da NVIDIA. “A NVIDIA H100 é o motor da infraestrutura de IA utilizado por empresas de todo o mundo para acelerar seus negócios orientados por IA.”

Inovações tecnológicas do H100

A GPU NVIDIA H100 estabelece um novo padrão na aceleração de IA e HPC em grande escala, oferecendo seis inovações revolucionárias:

- O chip mais avançado do mundo: construído com 80 bilhões de transistores usando um processo TSMC 4N de ponta projetado para as necessidades de computação aceleradas da NVIDIA, a H100 apresenta grandes avanços para acelerar IA, HPC, largura de banda de memória, interconexão e comunicação, incluindo 5 terabytes por segundo de conectividade externa. A H100 é a primeira GPU a oferecer suporte para PCI e de 5ª geração e a primeira a usar o HBM3, possibilitando uma largura de banda de memória de 3TB/s. 20 GPUs H100 são capazes de sustentar o equivalente ao tráfego de Internet de todo o mundo, possibilitando que os clientes ofereçam sistemas de recomendação avançados e grandes modelos de linguagem executando inferência de dados em tempo real.

- Novo Engine Transformer: atualmente o modelo padrão para o processamento de linguagem natural, o Transformer é um dos mais importantes modelos de deep learning já criados. O engine Transformer do acelerador H100 foi desenvolvido para acelerar essas redes em até 6 vezes, em relação à geração anterior sem prejuízos à precisão.

- GPU multi-Instância segura de 2ª geração: a tecnologia MIG permite particionar uma única GPU em sete instâncias menores e totalmente isoladas para executar diferentes tarefas. A arquitetura Hopper amplia os recursos da MIG em até 7x em relação à geração anterior, oferecendo configurações seguras multitenant e multiusuários em ambientes de cloud de até sete instâncias de GPU.

- Computação confidencial: a H100 é o primeiro acelerador do mundo com recursos de computação confidenciais para proteger modelos de IA e dados de clientes durante o processamento. Os clientes também podem aplicar computação confidencial à federated learning em setores que dependem de privacidade, como a área de saúde e serviços financeiros, bem como em infraestruturas de cloud compartilhadas.

- NVIDIA NVLink de 4ª geração: para acelerar grandes modelos de AI, o NVLink trabalha com um novo Switch NVLink externo para estender o NVLink como uma rede para ampliação além do servidor, conectando até 256 GPUs H100 com uma largura de banda 9 vezes maior em relação à geração anterior, utilizando o NVIDIA HDR Quantum InfiniBand.

- Instruções DPX: usadas em diversos algoritmos, incluindo otimização de rotas e genômica, as novas instruções DPX aceleram a programação dinâmica em até 40 vezes, em comparação com CPUs, e até 7 vezes em comparação com as GPUs da geração anterior. Isso inclui o algoritmo de Floyd-Warshall para encontrar as rotas ideais para frotas de robôs autônomos em ambientes dinâmicos de depósito e o algoritmo de Smith-Waterman usado no alinhamento de sequências para classificação e enovelamento de DNA e proteínas.

As inovações tecnológicas combinadas da H100 ampliam a liderança de inferência e treinamento em IA da NVIDIA para permitir aplicações imersivas e em tempo real usando modelos de IA de escala gigante. Com a H100, é possível ter chatbots que usam o modelo de linguagem monolítico de transformadores mais avançado do mundo, o Megatron 530B, com taxa de processamento até 30 vezes maior do que a geração anterior, além de atingir a latência de menos de um segundo necessária para IA de conversação em tempo real. A H100 também permite que pesquisadores e desenvolvedores treinem modelos enormes, como o Mixture of Experts, com 395 bilhões de parâmetros, até 9 vezes mais rápido, reduzindo de semanas para dias o tempo de treinamento.

Ampla adoção da NVIDIA H100

A NVIDIA H100 pode ser implementada em todos os tipos de data center, incluindo on-premises, no cloud, no cloud híbrido e no edge. Ainda este ano, ela poderá ser encontrada diretamente na NVIDIA e em todo o mundo, nos principais fornecedores de serviço em cloud e fabricantes de computadores.

O sistema DGX™ de quarta geração da NVIDIA, o DGX H100, conta com oito GPUs H100 para oferecer 32 petaflops de desempenho de IA com nova precisão de FP8, proporcionando a escala necessária para os enormes requisitos computacionais de grandes modelos de linguagem, sistemas de recomendação, pesquisas na área da saúde e ciência climática.

“É um orgulho para toda a NVIDIA o poder computacional conquistado nessa arquitetura. Com essa novidade, poderemos atender diversos setores, principalmente os que demandam o uso de diversas escalas”, ressalta Marcio Aguiar, diretor da divisão Enterprise da NVIDIA para América Latina.

Todas as GPUs de sistemas DGX H100 são conectadas pela NVLink de quarta geração, oferecendo conectividade de 900GB/s, 1,5 vez maior que a geração anterior. O NVSwitch™ permite que todas as oito GPUs H100 se conectem por NVLink. Um novo switch externo NVLink pode conectar até 32 nós DGX H100 nos supercomputadores NVIDIA DGX SuperPOD™ de última geração.

A Hopper recebeu amplo apoio do setor dos principais provedores de serviço em cloud, Alibaba Cloud, Amazon Web Services, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud e Tencent Cloud, que planejam oferecer instâncias baseadas em H100.

Vários servidores baseados na H100 são esperados dos principais fabricantes de computadores do mundo, incluindo Atos, BOXX Technologies, Cisco, Dell Technologies, Fujitsu, GIGABYTE, H3C, Hewlett Packard Enterprise, Inspur, Lenovo, Nettrix e Supermicro.

NVIDIA H100 em todas as escalas

A H100 virá em formatos SXM e PCIe para oferecer suporte a diversos requisitos de design de servidor. Também haverá um acelerador convergente disponível, emparelhando uma GPU H100 com uma NVIDIA ConnectX®-7 de 400Gb/s InfiniBand e Ethernet SmartNIC.

A H100 SXM da NVIDIA está disponível em placas de servidores HGX™ H100 com configurações de quatro e oito vias para empresas com aplicações dimensionadas para várias GPUs em um servidor e em vários servidores. Os servidores baseados em HGX H100 oferecem o mais alto desempenho de aplicações para treinamento e inferência de IA, além de aplicações de análise de dados e HPC.

A H100 PCIe, com NVLink para conectar duas GPUs, oferece uma largura de banda 7 vezes maior do que o PCIe 5.0, proporcionando excelente desempenho para aplicações executadas em servidores empresariais tradicionais. O formato facilita a integração à infraestrutura de data center existente.

O H100 CNX, novo acelerador convergente, combina uma H100 com um SmartNIC ConnectX-7 para oferecer desempenho inovador para aplicações com uso intensivo de I/O, como treinamento de IA de vários nós em data centers empresariais e processamento de sinais 5G no edge.

A H100 também pode ser pareada com a NVIDIA Grace™ CPU com uma interconexão NVLink®-C2C ultrarrápida para uma comunicação mais de 7 vezes mais rápida entre a CPU e a GPU em relação ao PCIe 5.0. Essa combinação, a Grace Maximize Superchip, é um módulo integrado projetado para atender a aplicações de HPC e IA em escala gigante.

Suporte a Software NVIDIA

A GPU NVIDIA H100 é compatível com avançadas ferramentas de software que permitem que desenvolvedores e empresas criem e acelerem aplicações de IA a HPC. Isso inclui grandes atualizações para o conjunto de software NVIDIA AI para cargas de trabalho como fala, sistemas de recomendação e inferência de hiperescala. A NVIDIA também lançou mais de 60 atualizações para sua coleção CUDA-X™ de bibliotecas, ferramentas e tecnologias para o desenvolvimento de aplicações aceleradas, como computação quântica e pesquisa em 6G, segurança cibernética, genômica e descoberta de medicamentos.

Disponibilidade

A NVIDIA H100 estará disponível a partir do terceiro trimestre. Para saber mais sobre a NVIDIA Hopper e H100, assista à apresentação de Jensen Huang no GTC 2022. Inscreva-se no GTC 2022 gratuitamente para participar de sessões com a NVIDIA e demais líderes do setor.