O ChatGPT acelerou as empresas a lançarem seus projetos de Inteligência Artificial (IA). A IA pode ser uma grande aliada, principalmente ao buscarmos algo na internet, por exemplo. No entanto, precisamos tomar cuidado com o que pesquisamos usando o ChatGPT. A orientação de especialistas é que nunca colemos dados confidenciais da empresa no ChatGPT. Especialistas alertam que os funcionários estão fornecendo dados corporativos confidenciais para o popular modelo de chatbot de inteligência artificial ChatGPT. Isso, sem dúvidas, é um risco.

Dados confidenciais de uma empresa no ChatGPT pode ser um risco

Pesquisadores do Cyberhaven Labs analisaram o uso do ChatGPT por 1,6 milhão de trabalhadores em empresas de vários setores. Eles relataram que 5,6% deles o usaram no local de trabalho e 4,9% forneceram dados da empresa para o popular modelo de chatbot desde o lançamento.

O ChatGPT usa esses dados para construir sua base de conhecimento, mas compartilha publicamente as informações construídas sobre eles. E é aí que está o risco! O uso do ChatGPT está se tornando um problema sério no espaço de trabalho, pois pode potencialmente causar o vazamento de dados sensíveis e confidenciais.

Os especialistas relataram que menos de um por cento (0,9%) dos funcionários é responsável por 80% dos vazamentos causados pela colagem de dados da empresa no chatbot. Essa porcentagem pode aumentar rapidamente nos próximos meses com a integração da tecnologia em vários serviços, por exemplo, por meio do uso da API ChatGPT.

Funcionários em busca de produtividade

Os funcionários acreditam que o chatbot de inteligência artificial desenvolvido pela OpenAI pode melhorar significativamente sua produtividade. Talvez, por isso, entreguem dados confidenciais da empresa para a tecnologia.

Os especialistas também alertam que o software de segurança empresarial não pode monitorar o uso do ChatGPT pelos funcionários e evitar o vazamento de dados sensíveis/confidenciais da empresa.

Os pesquisadores também monitoraram os trabalhadores copiando dados do popular chatbot e colando-os em outro lugar, como um e-mail da empresa, Google Doc ou seu editor de código-fonte. Eles notaram que os funcionários copiam dados do chatbot mais do que colam dados da empresa no ChatGPT em uma proporção de quase 2 para 1.

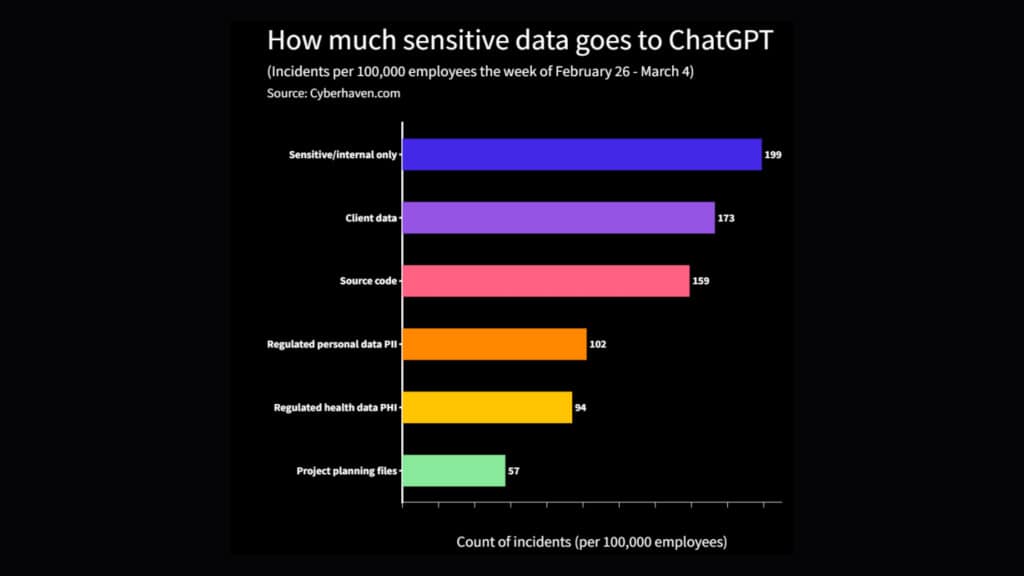

As descobertas dos pesquisadores apontam que a empresa média vaza dados confidenciais para o ChatGPT centenas de vezes por semana. Por exemplo, durante a semana de 26 de fevereiro a 4 de março, os funcionários da empresa média com 100.000 funcionários forneceram documentos confidenciais ao chatbot baseado em IA 199 vezes, dados do cliente 173 vezes e código-fonte 159 vezes.

ChatGPT pode ser um risco se você compartilhar dados da empresa

O Bleeping Coomputer resolveu perguntar à tecnologia “Qual é o risco de fornecer dados da empresa ao ChatGPT? E ele respondeu:

Como um grande modelo de linguagem, o ChatGPT não tem a capacidade de armazenar ou adquirir dados pessoais ou da empresa. Isso significa que não há risco inerente em usar o ChatGPT para discutir questões gerais ou fazer perguntas relacionadas ao conhecimento.

No entanto, se você fornecer informações confidenciais ou sensíveis sobre uma empresa, ou pessoa, essas informações podem ficar vulneráveis a possíveis ameaças de segurança ou privacidade associadas à comunicação online. Em geral, é sempre importante exercer a devida diligência ao discutir informações confidenciais online.

Em resumo, o ChatGPT não representa um risco para a segurança dos dados da empresa em si, mas é sempre importante estar atento à privacidade e segurança online e considerar cuidadosamente que tipo de informação você compartilha em uma plataforma de chatbot.

Então, compartilhar dados confidenciais da empresa que você trabalha, é um enorme erro!