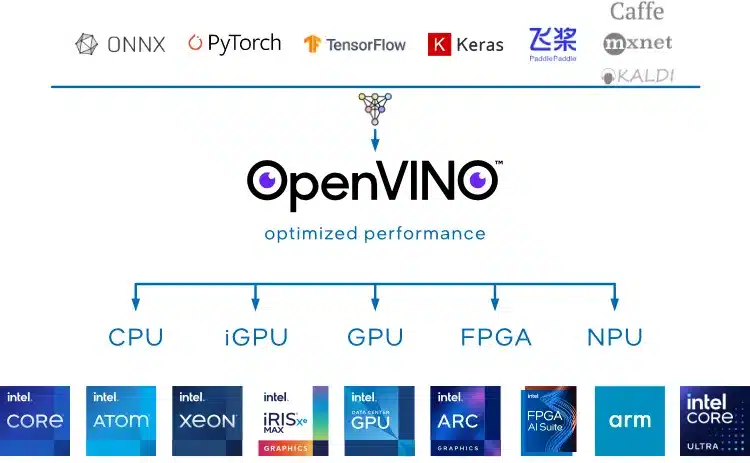

O OpenVINO 2024.0 traz mais recursos GenAI e nova API JavaScript. A Intel lançou o kit de ferramentas OpenVINO 2024.0 de código aberto para otimizar e implantar inferência de IA em uma variedade de hardware.

O OpenVINO é o maravilhoso kit de ferramentas de IA de código aberto da Intel para acelerar a inferência de IA não apenas em CPUs x86_64, mas também em CPUs ARM e outras arquiteturas, gráficos integrados e discretos da Intel e muito mais – incluindo seu recente plug-in NPU para aproveitar a Unidade de Processamento Neural Intel encontrada com os novos SoCs Core Ultra “Meteor Lake”.

Com a versão 2024.0 do OpenVINO de hoje, há mais foco generativo de IA “GenAI” com uma melhor experiência pronta para uso para modelos de codificação de sentenças TensorFlow, suporte para Mix of Experts (MoE), uma API JavaScript para acesso contínuo à API OpenVINO e modelos validados para Mistral e muito mais.

OpenVINO 2024.0 traz mais recursos GenAI e nova API JavaScript

O OpenVINO 2024.0 também traz melhor qualidade na compressão de peso INT4 para LLMs, desempenho LLM aprimorado em CPUs Intel, otimização e conversão mais fáceis de modelos Hugging Face e outras melhorias de integração do Hugging Face.

O OpenVINO 2024.0 descontinua o anterior Gaussian e Neural Accelerator (Intel GNA) da Intel, agora se concentrando na NPU encontrada com o Meteor Lake e mais recente. O plug-in Intel NPU para OpenVINO agora também é distribuído como parte do pacote OpenVINO principal no PyPi. Para usuários não-Intel, OpenVINO 2024.0 também ostenta melhor desempenho de CPU ARM e várias melhorias de plataforma.

Downloads e mais detalhes sobre o grande lançamento de recursos do OpenVINO 2024.0 de hoje via GitHub. Eu terei alguns novos benchmarks OpenVINO em breve.