- Desempenho máximo com uso mínimo de recursos: Descubra como os motores TensorRT da NVIDIA revolucionam a eficiência em IA.

- Eficiência de memória: Motores otimizados que operam em dispositivos de borda e móveis.

- Desempenho aprimorado: Inferências mais rápidas, latência reduzida e velocidade de resposta aumentada.

- Escalabilidade superior: Execute mais instâncias de inferência simultaneamente com menor uso de memória.

No mundo em rápida evolução da inteligência artificial (IA), a eficiência é a chave para desbloquear todo o potencial das aplicações. A NVIDIA, sempre na vanguarda das inovações tecnológicas, apresentou uma solução notável para otimizar tanto o desempenho quanto a eficiência das aplicações de IA: os motores TensorRT com modelos otimizados.

O que são motores TensorRT?

Antes de mergulharmos nos detalhes dos motores com modelos otimizados, é importante entender o que é o TensorRT. O TensorRT é uma biblioteca de inferência de alta performance desenvolvida pela NVIDIA, projetada para acelerar cargas de trabalho de aprendizado profundo. Ele permite que os modelos de IA sejam executados com máxima eficiência em GPUs NVIDIA, tornando possível alcançar latências ultrabaixas e throughput elevado.

Motores com modelos otimizados: uma revolução em eficiência

Os motores TensorRT com modelos otimizados são uma inovação que leva essa eficiência a um novo nível. Normalmente, os modelos de IA incluem um grande número de parâmetros, conhecidos como pesos, que são responsáveis pela precisão do modelo. Esses pesos, no entanto, podem ocupar uma quantidade significativa de memória e largura de banda, o que pode ser um desafio em ambientes com recursos limitados.

A solução da NVIDIA para isso é a remoção de parâmetros redundantes ou menos significativos, mantendo a precisão do modelo. Esse processo, conhecido como otimização de modelos, resulta em motores de inferência que consomem menos memória e utilizam menos recursos, sem sacrificar o desempenho.

Benefícios dos motores com modelos otimizados

- Eficiência de memória: Reduzindo a quantidade de memória necessária para armazenar os parâmetros, os motores com modelos otimizados podem operar em dispositivos com recursos limitados, como dispositivos de borda e dispositivos móveis.

- Desempenho aprimorado: Com menos dados para processar, esses motores podem realizar inferências mais rapidamente, reduzindo a latência e aumentando a velocidade de resposta.

- Escalabilidade: A menor utilização de memória permite que mais instâncias de inferência sejam executadas simultaneamente em uma única GPU, melhorando a escalabilidade das aplicações de IA.

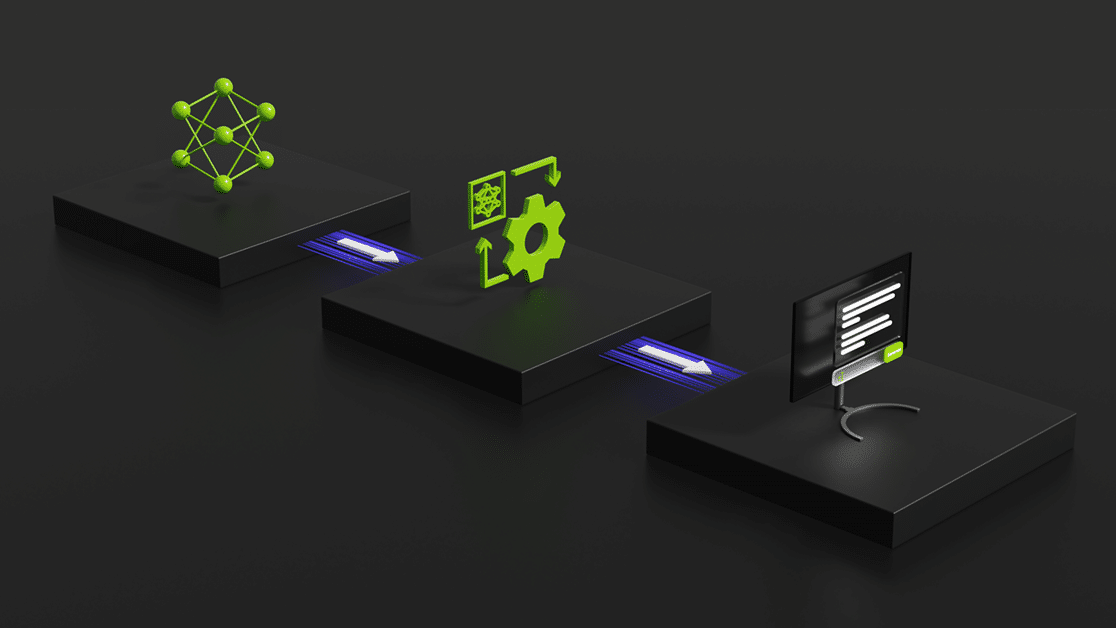

Como implementar motores TensorRT com modelos otimizados

Implementar esses motores pode parecer desafiador, mas a NVIDIA fornece ferramentas e documentação abrangentes para facilitar o processo. Aqui estão os passos básicos:

- Treinamento do modelo: Primeiro, você precisa treinar seu modelo de IA normalmente.

- Conversão para TensorRT: Use a API do TensorRT para converter seu modelo treinado em um motor TensorRT.

- Otimização de modelos: Utilize as ferramentas de otimização do TensorRT para remover os parâmetros desnecessários.

- Implementação e teste: Implante o motor otimizado e teste-o em seu ambiente alvo para garantir que ele atenda às suas necessidades de desempenho e precisão.

Conclusão: o futuro da IA otimizada

A introdução dos motores TensorRT com modelos otimizados pela NVIDIA é um passo significativo na direção de uma IA mais eficiente e acessível. Ao reduzir a memória necessária e melhorar o desempenho, esses motores permitem que desenvolvedores criem aplicações de IA mais robustas e escaláveis, mesmo em ambientes com recursos limitados.

À medida que a tecnologia continua a avançar, é essencial que os desenvolvedores se mantenham atualizados com as últimas ferramentas e técnicas. Os motores TensorRT com modelos otimizados são uma dessas inovações que não apenas simplificam o desenvolvimento, mas também impulsionam a eficiência ao máximo. Se você está procurando maneiras de otimizar suas aplicações de IA, definitivamente vale a pena explorar o poder desses motores.