Em um movimento rápido e crucial para a estabilidade dos sistemas Linux, o lançamento do Kernel Linux 6.16-rc7 traz uma correção que elimina um bug capaz de gerar valores falsos na carga média (load average) do sistema. Embora a alteração no código tenha sido pequena, seu impacto é gigantesco para quem depende da precisão das métricas de desempenho — especialmente administradores de sistemas, engenheiros de performance e todos que gerenciam servidores ou infraestrutura crítica.

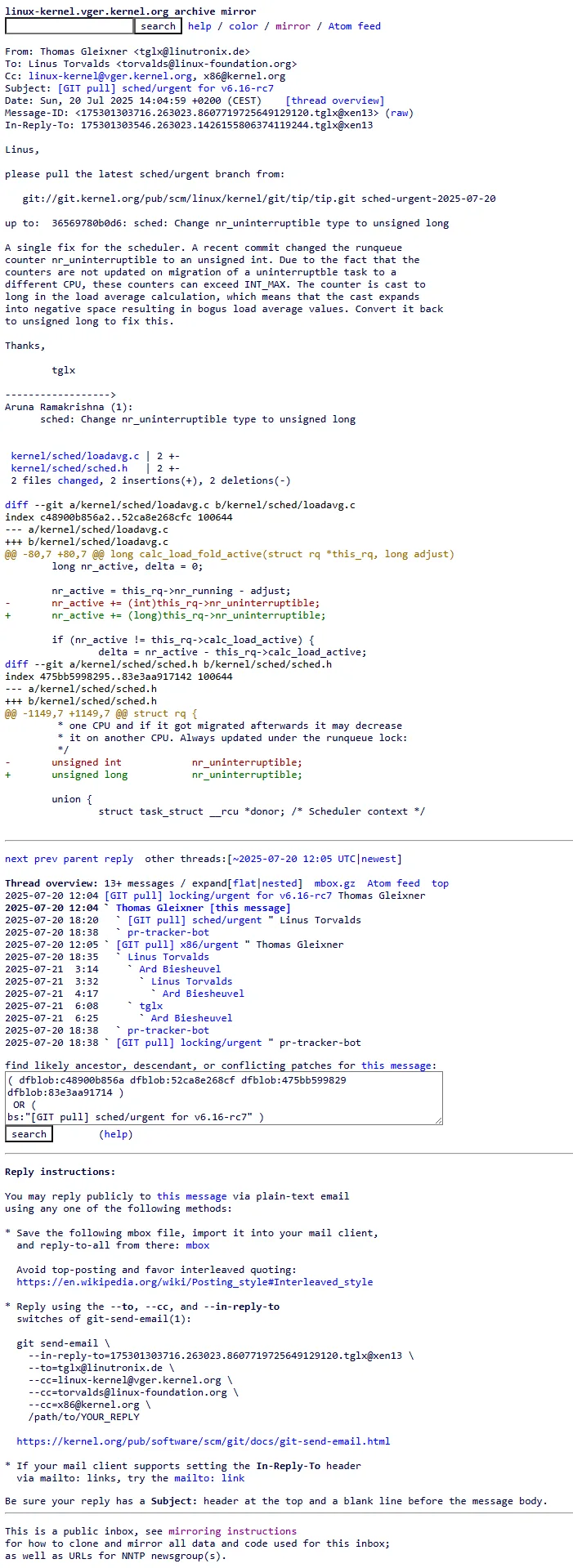

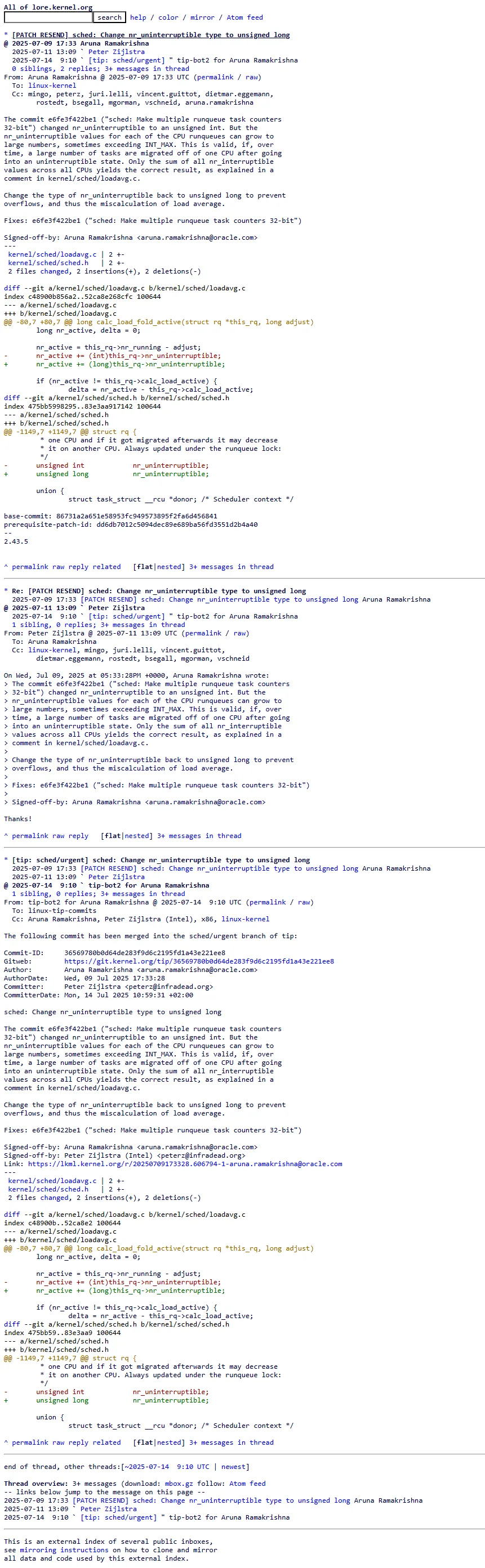

O problema, causado por um overflow no contador nr_uninterruptible (responsável por rastrear tarefas em estado ininterruptível), podia levar a situações em que o sistema reportava cargas incorretas, enganando ferramentas de monitoramento, scripts automáticos de gestão de recursos e, em última instância, os próprios administradores. A solução veio de Aruna Ramakrishna (Oracle), foi incluída por Thomas Gleixner (Linutronix) em um pull request urgente e aprovada por Linus Torvalds — que aproveitou para levantar um debate sobre a escolha correta dos tipos de dados no núcleo do sistema.

O agendador do Kernel Linux e a importância da carga média

O agendador é, literalmente, o coração do Kernel Linux. Ele decide quais tarefas (processos ou threads) devem ser executadas em cada CPU a cada instante, organizando a fila de execução (runqueue) para garantir máxima eficiência, responsividade e justiça no uso do processador. Entre as métricas fundamentais que ele oferece para monitoramento, a carga média (load average) se destaca: ela indica quantas tarefas estão prontas para rodar ou aguardando CPU, ao longo de intervalos de 1, 5 e 15 minutos.

A carga média (load average) como métrica vital de desempenho do sistema

A carga média é uma das primeiras métricas verificadas por administradores de sistemas e ferramentas de observabilidade. Ela resume, de forma sintética, o nível de ocupação do processador e possíveis gargalos. Um valor alto e sustentado de carga média pode indicar sobrecarga, deadlocks, processos travados ou até ataques de negação de serviço (DoS). Da mesma forma, quedas abruptas e inexplicáveis levantam suspeitas de falhas graves, panes ou ociosidade forçada.

Como o agendador distribui tarefas e afeta a performance geral

Ao distribuir tarefas pelas CPUs, o agendador precisa manter controles rigorosos sobre estados de execução, prioridade, afinidade de CPU e outros critérios. Entre os estados mais importantes está o ininterruptível, usado por processos que aguardam I/O de disco, operações de rede ou eventos críticos do sistema. O correto rastreamento de quantas tarefas estão nesse estado é fundamental para o cálculo do load average, já que afeta diretamente a percepção de carga real.

O bug de nr_uninterruptible: causas e consequências de uma métrica falsa

O núcleo do problema estava no contador nr_uninterruptible, historicamente usado para manter o número de tarefas em estado ininterruptível no sistema. Ele era implementado como unsigned int, presumindo-se que o valor nunca seria negativo e raramente ultrapassaria o limite máximo desse tipo de dado (INT_MAX, ou 2.147.483.647 em sistemas de 32 bits).

No entanto, devido a migrações de tarefas entre CPUs — especialmente em sistemas multicore, onde o kernel move processos para balancear a carga — esse contador podia, em situações de estresse ou bugs na atualização dos estados, exceder o valor máximo de unsigned int. O resultado? Um overflow, levando o contador a “voltar” para zero ou mesmo para valores negativos ao ser convertido para long durante o cálculo do load average em funções como calc_load_fold_active().

O overflow do contador e a migração de tarefas

O detalhe técnico é sutil, mas devastador: quando tarefas ininterruptíveis são migradas e o contador não é devidamente sincronizado em todas as CPUs, o valor total pode crescer sem controle. Ao ultrapassar INT_MAX, o valor de nr_uninterruptible sofre um wrap-around, tornando-se incorreto e gerando cálculos absurdos para a carga média. Dependendo do momento e da arquitetura, era possível ver números negativos, gigantescos ou até mesmo zerações esporádicas no load average.

O impacto da carga média falsa: diagnósticos incorretos e decisões equivocadas

Os efeitos práticos de uma carga média falsa vão muito além de um número errado no top ou no htop. Muitas infraestruturas modernas usam scripts automatizados, alertas e orquestradores baseados no load average para decisões críticas: migrar workloads, reiniciar serviços, alocar recursos extras ou acionar equipes de plantão. Um overflow que reporta uma carga média irreal pode levar a decisões precipitadas, desperdício de recursos ou até a negligenciar um problema real, acreditando que o sistema está saudável.

A solução: restaurando a precisão com a mudança do tipo de dados

A correção do bug veio de Aruna Ramakrishna, engenheira da Oracle, que identificou a raiz do problema: o tipo unsigned int era simplesmente inadequado para as exigências atuais do kernel, principalmente em ambientes multicore com migrações intensas de tarefas. O fix é elegante e direto: mudar o tipo do contador nr_uninterruptible de unsigned int para unsigned long — que comporta valores muito mais altos, elimina o risco imediato de overflow e se alinha ao tipo já utilizado nas funções de cálculo da carga média.

De unsigned int para unsigned long: o fix de Aruna Ramakrishna

O patch, incluído por Thomas Gleixner no pull request sched/urgent para o Linux 6.16-rc7, modificou apenas dois arquivos: kernel/sched/loadavg.c e kernel/sched/sched.h, com 2 inserções e 2 deleções. Simples na forma, mas essencial no conteúdo. Essa alteração garante que, mesmo em sistemas massivos, o contador não estoure seu limite tão facilmente, mantendo a consistência e a confiabilidade das métricas fornecidas pelo kernel.

A validação de Linus Torvalds: consistência e confiabilidade do código

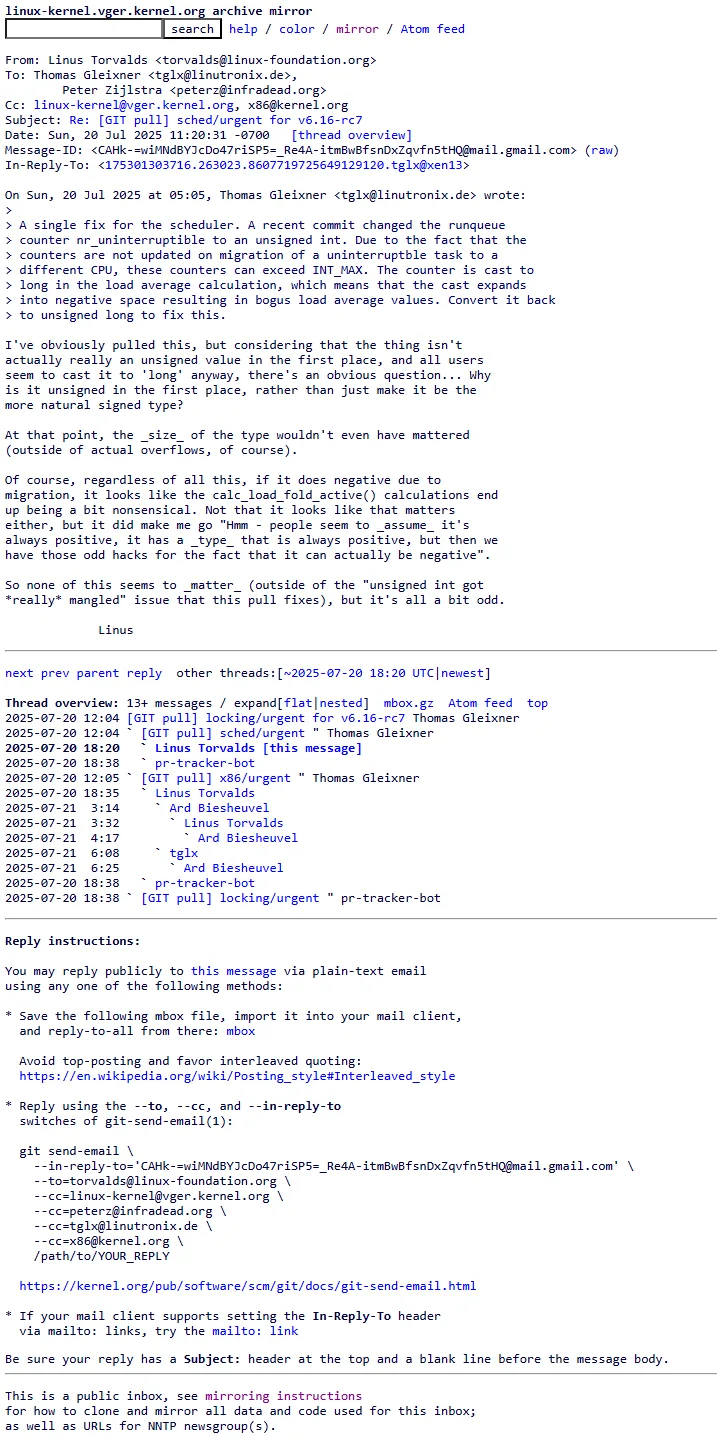

Ao aprovar a correção, Linus Torvalds não deixou de questionar por que o tipo era unsigned int originalmente, já que o contador era convertido para long nas funções críticas e seu comportamento não era realmente “unsigned” devido aos hacks necessários para tratar as migrações. Torvalds enfatizou a necessidade de consistência e clareza nos tipos de dados usados no kernel, alertando para a proliferação de pequenos “workarounds” que, ao longo do tempo, dificultam a manutenção e aumentam o risco de bugs.

A discussão expõe o desafio de manter uma base de código gigantesca, com décadas de evolução, livre de “erros herdados” — especialmente quando mudanças aparentemente triviais podem afetar todo o ecossistema.

Implicações e o futuro: um Kernel Linux mais preciso e confiável

A correção traz benefícios imediatos para administradores de sistema, engenheiros de desempenho e desenvolvedores: a carga média volta a refletir fielmente o estado real do sistema, sem ser afetada por anomalias de contagem causadas por overflows. Isso fortalece a confiança nas métricas nativas do kernel, reduz o risco de alarmes falsos e melhora a tomada de decisão automatizada em ambientes de missão crítica.

Mais do que isso, o episódio reforça a importância de uma atenção obsessiva aos detalhes — até mesmo aos tipos de dados aparentemente triviais — no desenvolvimento do kernel. Pequenas decisões, quando negligenciadas, podem se transformar em bugs críticos anos depois.

Benefícios para administradores de sistema e engenheiros de desempenho

Com a correção, ferramentas de monitoramento (como top, htop, Grafana, Zabbix e afins) passam a exibir valores precisos de load average, especialmente em sistemas com grande quantidade de CPUs ou workloads muito dinâmicos. Isso facilita o diagnóstico de problemas reais, a análise de tendências de uso e o planejamento de capacity sem sustos de última hora.

A atenção aos detalhes no desenvolvimento do Kernel: a importância de fixes ‘urgent’

A inclusão do patch na release candidate 7 (rc7) demonstra o compromisso da comunidade com a estabilidade e a confiabilidade do Linux. Fixes “urgent” perto do congelamento do código são raros, mas absolutamente necessários quando o impacto pode comprometer o monitoramento e a operação de milhares de servidores e dispositivos no mundo todo.

Conclusão: a precisão das métricas é fundamental para a saúde do seu sistema Linux

O caso do nr_uninterruptible e do bug de carga média falsa no Kernel Linux 6.16-rc7 é um exemplo didático de como detalhes de implementação podem ter impacto sistêmico. Métricas confiáveis são o alicerce do monitoramento, da automação e da tomada de decisões em TI. Graças ao olhar atento de engenheiros como Aruna Ramakrishna, ao processo colaborativo de revisão de código e à liderança vigilante de Linus Torvalds, o Linux mantém sua reputação de robustez e evolução constante — sempre buscando o equilíbrio entre inovação e confiança.