Nos últimos dias, três falhas críticas de segurança foram identificadas no NVIDIA Triton Inference Server, uma das principais ferramentas utilizadas para servir modelos de inteligência artificial (IA) em produção. As vulnerabilidades — catalogadas como CVE-2025-23319, CVE-2025-23320 e CVE-2025-23334 — permitem a execução remota de código (RCE) e podem ser exploradas em cadeia para comprometer servidores, roubar modelos de IA e até aprofundar o ataque em redes corporativas.

Este artigo explica o que é o NVIDIA Triton, como as vulnerabilidades funcionam, os riscos envolvidos e, principalmente, como proteger sua infraestrutura de IA. Diante do crescimento exponencial do uso de modelos de aprendizado de máquina em ambientes críticos, a segurança do Triton se torna um ponto central de atenção para desenvolvedores, equipes de DevOps e profissionais de cibersegurança.

O que é o NVIDIA Triton Inference Server?

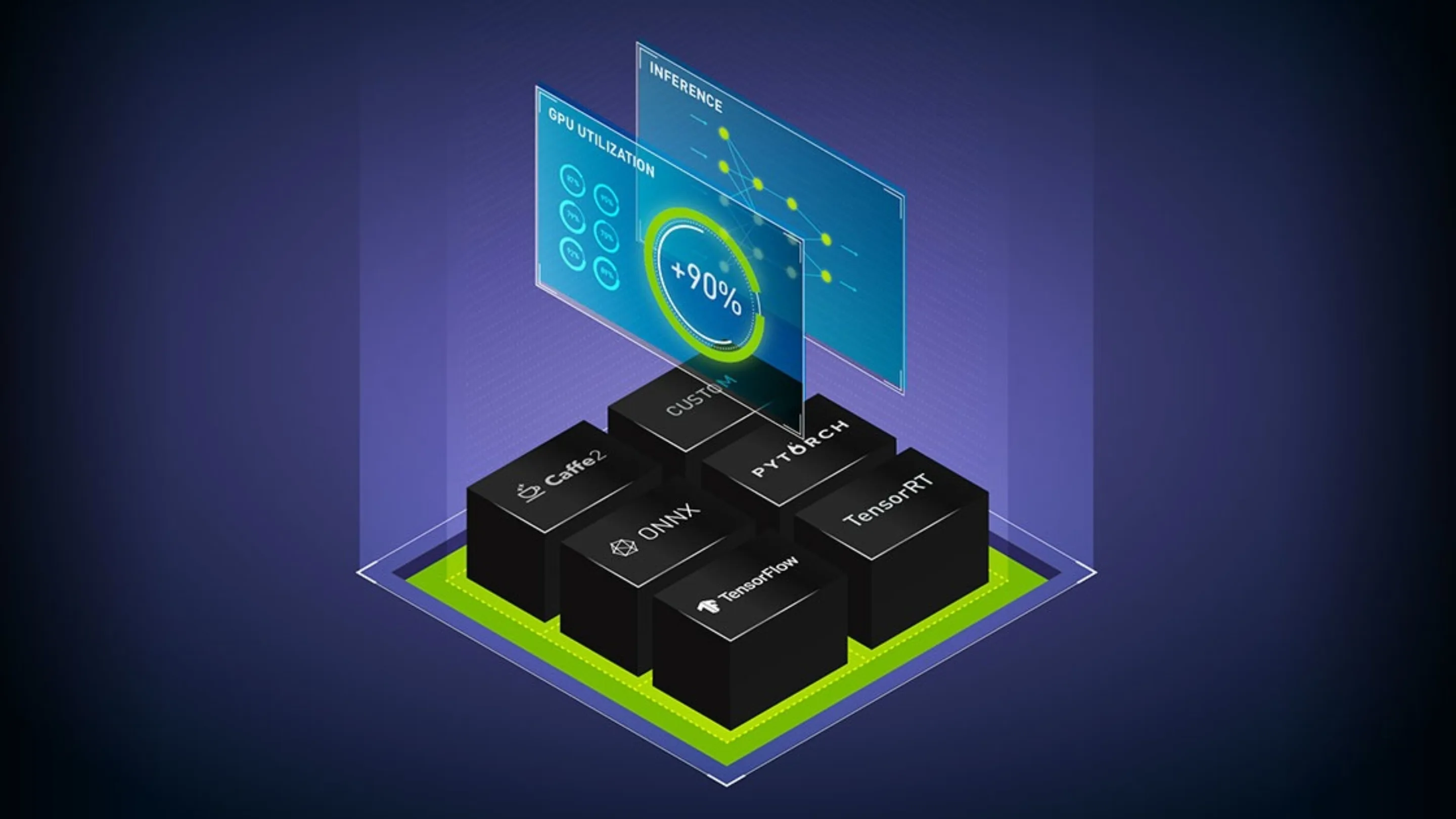

O NVIDIA Triton Inference Server é uma plataforma de código aberto projetada para servir modelos de machine learning (ML) e deep learning (DL) em produção. Ele suporta modelos treinados em diversas estruturas, como TensorFlow, PyTorch, ONNX e TensorRT, permitindo a inferencia de modelos de forma escalável, com suporte a GPUs e CPUs.

Ao centralizar o serviço de inferência, o Triton simplifica o deployment de IA e melhora a eficiência operacional em ambientes que vão desde aplicações de análise preditiva em tempo real até sistemas de visão computacional embarcados em data centers.

Onde o NVIDIA Triton Inference Server é usado?

Empresas como NVIDIA, Microsoft, Meta, OpenAI e Tesla utilizam o Triton como parte de sua infraestrutura de IA. O servidor é amplamente adotado em setores como:

- Financeiro, para detecção de fraudes e análise preditiva;

- Saúde, em diagnósticos assistidos por IA;

- Indústria automotiva, em sistemas de condução autônoma;

- Comércio eletrônico, para recomendação de produtos e personalização.

As vulnerabilidades críticas e o ataque em cadeia

As recentes falhas descobertas no Triton Inference Server chamam atenção não só por sua gravidade, mas também pelo potencial de ataque em cadeia — ou seja, a exploração sequencial de diferentes vulnerabilidades para obter controle total do sistema.

Detalhes das falhas de segurança: CVE-2025-23319, CVE-2025-23320 e CVE-2025-23334

- CVE-2025-23319 – Uma falta de validação adequada de entrada ao processar modelos carregados permite que um invasor envie cargas maliciosas que escapam do ambiente de execução restrito.

- CVE-2025-23320 – Vulnerabilidade que permite a escalada de privilégios, explorando o mecanismo de manipulação de arquivos temporários mal protegidos.

- CVE-2025-23334 – A falha mais crítica, com pontuação CVSS 9.8, permite a execução remota de código (RCE) através de requisições especialmente manipuladas via API, sem necessidade de autenticação.

Como as vulnerabilidades permitem a execução remota de código (RCE)?

A cadeia de ataque ocorre quando um invasor combina as falhas em uma sequência lógica: primeiro, carrega um modelo malicioso (via CVE-2025-23319), depois ganha acesso a recursos privilegiados (via CVE-2025-23320), e por fim executa comandos arbitrários remotamente (via CVE-2025-23334).

Esse encadeamento pode dar ao atacante controle completo do servidor, com capacidade para:

- Instalar backdoors;

- Capturar tráfego;

- Acessar redes internas;

- Manipular o comportamento de modelos de IA.

Riscos e implicações de um ataque bem-sucedido

A exploração dessas vulnerabilidades pode levar a consequências devastadoras, especialmente em ambientes corporativos e de missão crítica. Entre os principais riscos, destacam-se:

Roubo de modelos de IA

Modelos treinados representam ativos valiosos, fruto de anos de desenvolvimento, investimento em dados e esforço computacional. Ao acessar o servidor Triton, um invasor pode copiar modelos proprietários e revendê-los ou usá-los indevidamente.

Acesso a dados confidenciais e manipulação de respostas

Ao controlar o serviço de inferência, o atacante pode:

- Interceptar dados sensíveis usados como entrada nos modelos;

- Alterar as respostas dos modelos, sabotando decisões automatizadas em diagnósticos médicos, finanças ou segurança.

Aprofundamento na rede

O servidor Triton, por operar em contato com outras APIs e recursos de rede, pode funcionar como ponto de entrada para ataques maiores. Um comprometimento bem-sucedido pode levar ao movimento lateral na infraestrutura, afetando bancos de dados, sistemas de autenticação e outros serviços críticos.

Como se proteger: a solução da NVIDIA

Felizmente, a NVIDIA lançou correções para as vulnerabilidades identificadas. A versão 25.07 do Triton Inference Server corrige as três falhas e está disponível no repositório oficial do projeto.

As medidas recomendadas são:

- Atualizar imediatamente para a versão 25.07;

- Verificar logs de acesso e execução em busca de indícios de exploração;

- Isolar o servidor Triton da internet pública sempre que possível;

- Aplicar autenticação e criptografia em APIs expostas;

- Monitorar continuamente a integridade dos modelos servidos.

A adoção rápida dos patches de segurança é crucial para proteger modelos de IA e manter a integridade da infraestrutura.

Conclusão e visão geral da segurança em IA

As vulnerabilidades críticas no NVIDIA Triton Inference Server revelam uma realidade cada vez mais presente: modelos de inteligência artificial são alvos valiosos e exigem o mesmo nível de proteção de sistemas tradicionais.

A resposta rápida da NVIDIA mostra o compromisso da empresa com a segurança, mas também reforça a responsabilidade dos profissionais da área em manter suas infraestruturas atualizadas e protegidas.

Manter a segurança em primeiro plano, especialmente em soluções que lidam com modelos de IA, não é mais opcional — é uma obrigação técnica e estratégica. Organizações que subestimam esses riscos correm o sério perigo de perdas financeiras, exposição de dados e danos à reputação.