A inteligência artificial está rapidamente desmontando as últimas barreiras que ainda impediam a comunicação global em tempo real, e o Google Translate em óculos inteligentes está prestes a se tornar o eixo central dessa transformação. Com a evolução do Gemini e a chegada de recursos avançados de Live Translate, a Google está demonstrando que a tradução instantânea não é mais um sonho futurista, mas uma experiência natural, contínua e integrada ao cotidiano digital.

As descobertas mais recentes revelam novas funções no aplicativo, incluindo controles refinados de áudio, uso persistente em segundo plano e, principalmente, a preparação explícita para integração com óculos inteligentes. Este artigo analisa como essas novidades não apenas aprimoram o aplicativo atual, mas pavimentam o caminho para a próxima grande plataforma computacional, a Realidade Estendida (XR), onde a tradução será transparente e ubíqua.

Mais do que ajustes estéticos ou pequenas melhorias, essas mudanças mostram que o Google Translate está se moldando para se tornar o aplicativo definitivo de tradução para óculos AR, habilitando uma comunicação verdadeiramente universal.

O que muda no Live Translate: controle e persistência

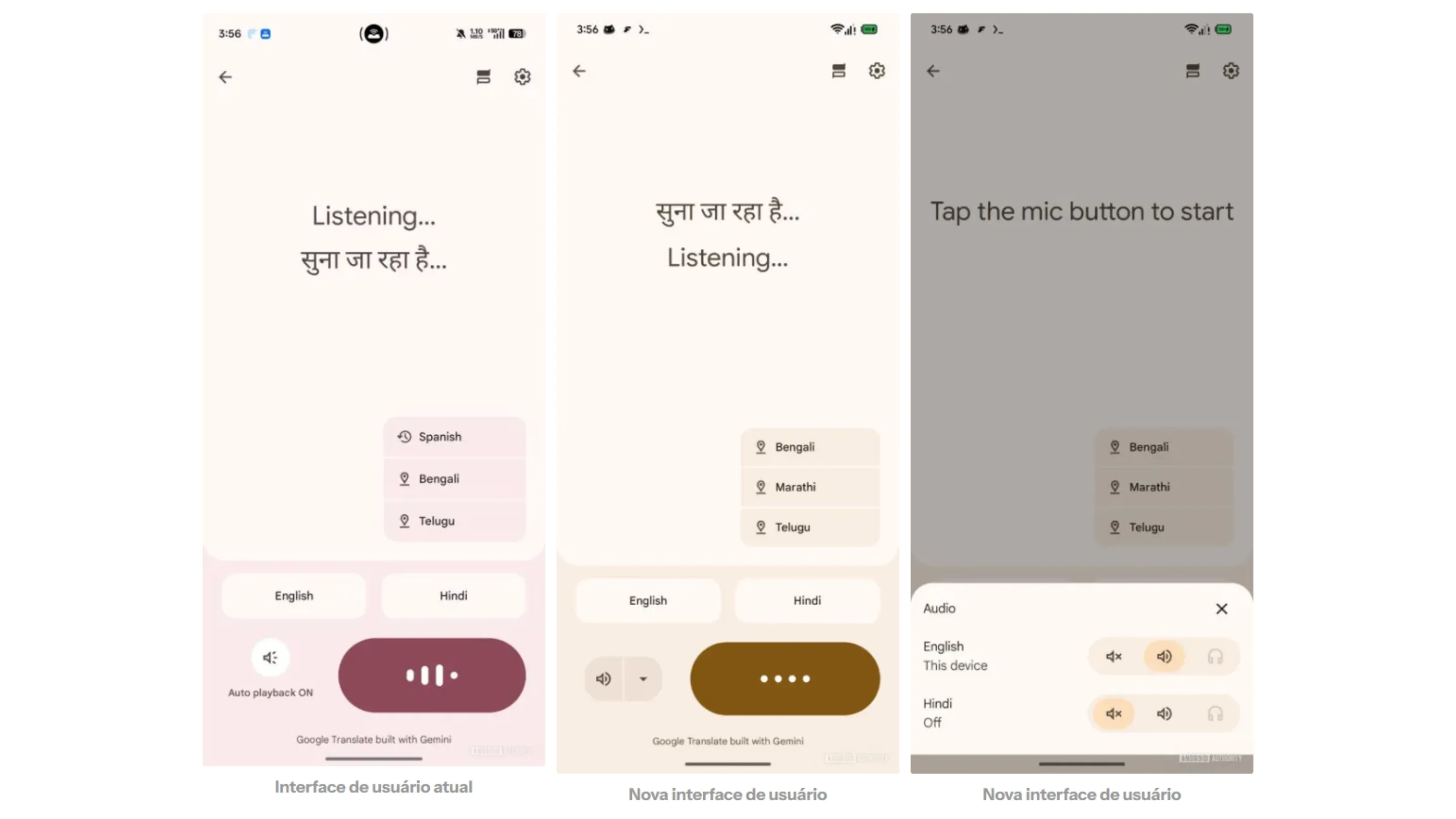

Uma das alterações mais impactantes dentro do Live Translate é a adição de um novo e mais avançado controle de áudio por idioma, permitindo ajustar como a tradução é ouvida durante uma conversa. Esse painel foi reformulado para oferecer três modos distintos de saída, cada um projetado para um tipo de uso ou dispositivo.

Os usuários agora encontram a opção de silenciar o áudio, útil para situações em que apenas legendas ou transcrição visual são necessárias. O modo alto-falante torna a conversa audível para quem está ao redor, especialmente em interações presenciais que exigem clareza. Já o modo fone de ouvido indica uma operação mais privada, ideal para ambientes barulhentos ou para uso com dispositivos vestíveis, como óculos AR conectados via Bluetooth.

Essa modularidade deixa claro que o Google está construindo uma interface que se adapta automaticamente ao contexto e ao dispositivo. Em um futuro onde o Live Translate em óculos se populariza, esses botões tornam-se essenciais para garantir que a tradução seja fluida, discreta ou amplificada conforme a necessidade.

Tradução sem interrupções: o poder do segundo plano

Outra descoberta importante envolve a implementação de uma notificação persistente que mantém o Live Translate ativo mesmo quando o usuário muda de aplicativo. Isso significa que, ao alternar para o navegador, WhatsApp ou câmera, a tradução continua funcionando sem interrupções, similar ao modo contínuo do Gemini Live.

Essa funcionalidade é crítica para transformar a tradução instantânea em algo realmente útil no mundo real. Hoje, no smartphone, ela permite que o usuário acompanhe uma conversa enquanto realiza outras tarefas simultaneamente. Em dispositivos XR, essa persistência é ainda mais importante, já que a experiência é totalmente imersiva e precisa funcionar sem depender da interface do celular.

A possibilidade de operar em segundo plano aproxima o aplicativo de um comportamento mais sistêmico e menos “aplicativo dependente”, reforçando a visão de uma tradução embarcada diretamente no dispositivo, sempre ativa e sempre acessível.

O Google Translate como o aplicativo definitivo para óculos inteligentes

O ponto mais revelador de toda a investigação está na presença explícita do termo Glasses no seletor de dispositivos dentro do aplicativo. Isso sugere que o Live Translate não está apenas recebendo suporte periférico, mas sendo realmente preparado para funcionar nativamente em óculos inteligentes.

Esse seletor indica que o usuário poderá alternar entre diferentes dispositivos conectados — como o telefone, fones de ouvido e agora óculos AR — para realizar traduções em tempo real. Tudo aponta para uma integração profunda com produtos do ecossistema Android XR, incluindo possíveis prototypes internos da Google.

A visão da Google para a comunicação ubíqua

Ao adicionar suporte a óculos inteligentes, a Google revela uma visão ousada para o futuro da comunicação, onde a tradução deixa de ser um processo intermediado pelo celular e passa a ser uma experiência superposta ao mundo físico. Imagine conversar com alguém enquanto vê legendas flutuando ao lado da boca da pessoa, ou caminhar por uma cidade desconhecida lendo automaticamente placas e avisos traduzidos diante dos olhos.

Essa tecnologia transforma completamente a forma como viajantes, profissionais multilíngues, estudantes e turistas se comunicam. E mais: coloca o Google Translate como protagonista em uma corrida já disputada por Meta, Apple e outras empresas que apostam na computação espacial.

Neste cenário, o aplicativo Tradutor deixa de ser apenas um app utilitário e se torna uma peça central do sistema operacional — quase como um middleware de comunicação universal entre seres humanos e ambientes.

O impacto do Gemini no Live Translate e o futuro da comunicação

Nenhuma dessas mudanças seria possível sem o avanço do Gemini, o modelo de IA da Google que combina linguagem, visão, áudio e raciocínio em uma plataforma unificada. Graças à capacidade multimodal do Gemini, o Live Translate passa a identificar não apenas palavras, mas contexto, sotaques, pausas e intenções.

Com a IA entendendo nuances da fala, a tradução se torna mais natural, mais rápida e mais alinhada com a realidade das conversas humanas. Em um futuro próximo, óculos AR serão capazes de exibir traduções instantâneas com mínima latência, tornando o idioma quase irrelevante na comunicação.

A promessa é clara: acabar com a barreira linguística em qualquer interação social ou profissional. Seja em reuniões internacionais, viagens ou até eventos culturais, o Live Translate com Gemini em óculos inteligentes será a ponte que conecta pessoas sem esforço.

Conclusão: um passo gigantesco para o futuro da AR

As novas funções do Google Translate não são apenas incrementos de qualidade, mas passos estratégicos na construção do primeiro grande aplicativo indispensável para a era da Realidade Aumentada. Desde o controle avançado de áudio até o funcionamento em segundo plano e a preparação nativa para óculos inteligentes, tudo indica que o Live Translate será a primeira experiência de massa que realmente justificará o uso diário desses dispositivos vestíveis.

A Google está pavimentando um caminho onde a comunicação ultrapassa fronteiras e limitações técnicas, e o Translate surge como a solução ideal para tornar essa visão realidade.

Você usaria um óculos inteligente apenas pela tradução em tempo real? Compartilhe sua opinião nos comentários!