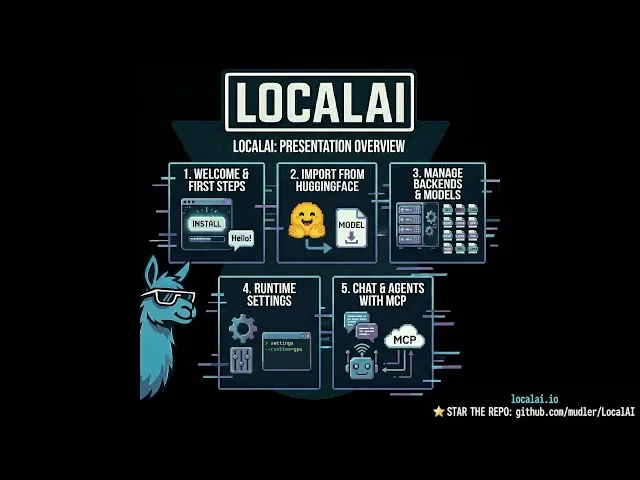

Local Stack é a evolução prática do LocalAI: em vez de ser apenas uma API compatível com OpenAI para inferência local, ele passa a integrar uma suíte modular para inferência (LocalAI), orquestração de agentes (LocalAGI) e memória persistente (LocalRecall), com foco em soberania de dados e operação on-premises.

Versão Analisada: Janeiro 2026 / Suporte: CUDA 13 & MCP

LocalAI se posiciona como um drop-in replacement: você mantém SDKs, clientes e fluxos desenhados para a API da OpenAI (e especificações similares), só que apontando o endpoint para a sua infraestrutura local. A diferença em 2025–2026 é que isso deixou de ser “somente chat e completions”: virou uma pilha completa para LLMs, imagens, áudio e agentes, com WebUI integrada e uma arquitetura que reduz drasticamente o peso do runtime ao baixar backends sob demanda.

O que mudou de verdade é a trindade do Local Stack: LocalAI (motor de inferência/API), LocalAGI (agentes e “Responses API” local) e LocalRecall (memória e base de conhecimento persistente).

Resumo

- LocalAI: o motor de inferência e a API REST compatível com OpenAI, para texto, visão, áudio e tarefas especializadas, rodando localmente e sem exigir GPU.

- LocalAGI: plataforma de gestão e execução de agentes, desenhada como substituta “drop-in” da Responses API, com capacidades agentic avançadas.

- LocalRecall: API REST para memória persistente e gestão de conhecimento, habilitando armazenamento e recuperação de contexto de longo prazo para agentes.

A nova arquitetura modular

A virada arquitetural mais relevante é a separação explícita entre binário principal e backends. Na prática:

- O LocalAI ficou mais leve: os backends foram migrados para fora do binário principal e podem ser gerenciados independentemente.

- Você instala ou seleciona um modelo e o sistema baixa apenas o backend necessário (por exemplo, llama.cpp, diffusers, whisper.cpp), em vez de carregar imagens “monolíticas” com tudo embutido.

- Existe uma Backend Gallery com instalação/remoção on-the-fly, “powered by OCI images”, e a gestão é customizável e API-driven.

- Para o ciclo de containers, isso muda o padrão de “imagens gigantes” para um modelo que privilegia time-to-first-token e atualização incremental. O próprio projeto sinaliza que imagens “extras” tendem a ser descontinuadas em releases futuras, reforçando o caminho modular.

NOTA DE PERFORMANCE: Com os backends fora do binário e baixados sob demanda, o runtime do LocalAI fica mais enxuto. A escolha do backend passa a acontecer no momento em que você instala um modelo via galeria ou YAML/URL, reduzindo peso inicial e simplificando atualizações.

Detecção automática de backend e hardware

Ao instalar modelos pela galeria ou via arquivos de configuração, o LocalAI faz detecção automática e escolhe o caminho de aceleração adequado (CPU, NVIDIA, AMD, Intel, Apple). Isso é especialmente útil em ambientes heterogêneos (homelab com múltiplas máquinas) e em cenários de rolling upgrades de GPU.

O que isso habilita em DevOps

- Imutabilidade seletiva: você pode “fixar” versão do LocalAI e evoluir backends separadamente (ou o inverso), reduzindo blast radius.

- Imagens menores e deploy mais previsível: especialmente relevante para edge, clusters com storage limitado e pipelines CI/CD.

- Operação multi-backend: texto, imagem e áudio coexistem sem você precisar construir um “super container” com tudo.

Instalação e quickstart

Comando 1: instalação básica (script)

# Basic installation

curl https://localai.io/install.sh | sh

ALERTA (macOS): os DMGs não são assinados pela Apple e podem ficar em quarentena. O projeto referencia um workaround no Issue #6268 (há acompanhamento do fix no #6244).

Comando 2: Docker (run vs start)

Docker Run vs Docker Start (conceito operacional)

docker runcria e inicia um novo container. Se já existir um container com o mesmo nome, vai falhar.docker startinicia um container existente criado anteriormente comdocker run.

Se você já executou e quer iniciar novamente:

docker start -i local-aiCPU only

docker run -ti --name local-ai -p 8080:8080 localai/localai:latestComando 3: acelerado por GPU (NVIDIA CUDA 13 / AMD ROCm)

NVIDIA (CUDA 13.0)

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-13NVIDIA (CUDA 12.0)

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12Para hardware NVIDIA mais novo, as imagens CUDA 13 são o caminho natural para reduzir atrito de compatibilidade e aproveitar a pilha recente de aceleração.

NVIDIA Jetson (L4T) ARM64

# CUDA 12 (for Nvidia AGX Orin and similar platforms)

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-nvidia-l4t-arm64

# CUDA 13 (for Nvidia DGX Spark)

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-nvidia-l4t-arm64-cuda-13AMD (ROCm / hipBLAS)

docker run -ti --name local-ai -p 8080:8080 --device=/dev/kfd --device=/dev/dri --group-add=video localai/localai:latest-gpu-hipblasIntel (oneAPI)

docker run -ti --name local-ai -p 8080:8080 --device=/dev/dri/card1 --device=/dev/dri/renderD128 localai/localai:latest-gpu-intelVulkan (cross-platform)

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-gpu-vulkanAIO images (modelos pré-baixados)

As imagens AIO aceleram o “primeiro uso” porque já vêm com modelos, mas custam storage e têm trade-offs no mundo modular.

# CPU version

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu

# NVIDIA CUDA 13 version

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-13

# AMD GPU version

docker run -ti --name local-ai -p 8080:8080 --device=/dev/kfd --device=/dev/dri --group-add=video localai/localai:latest-aio-gpu-hipblasCarregamento de modelos

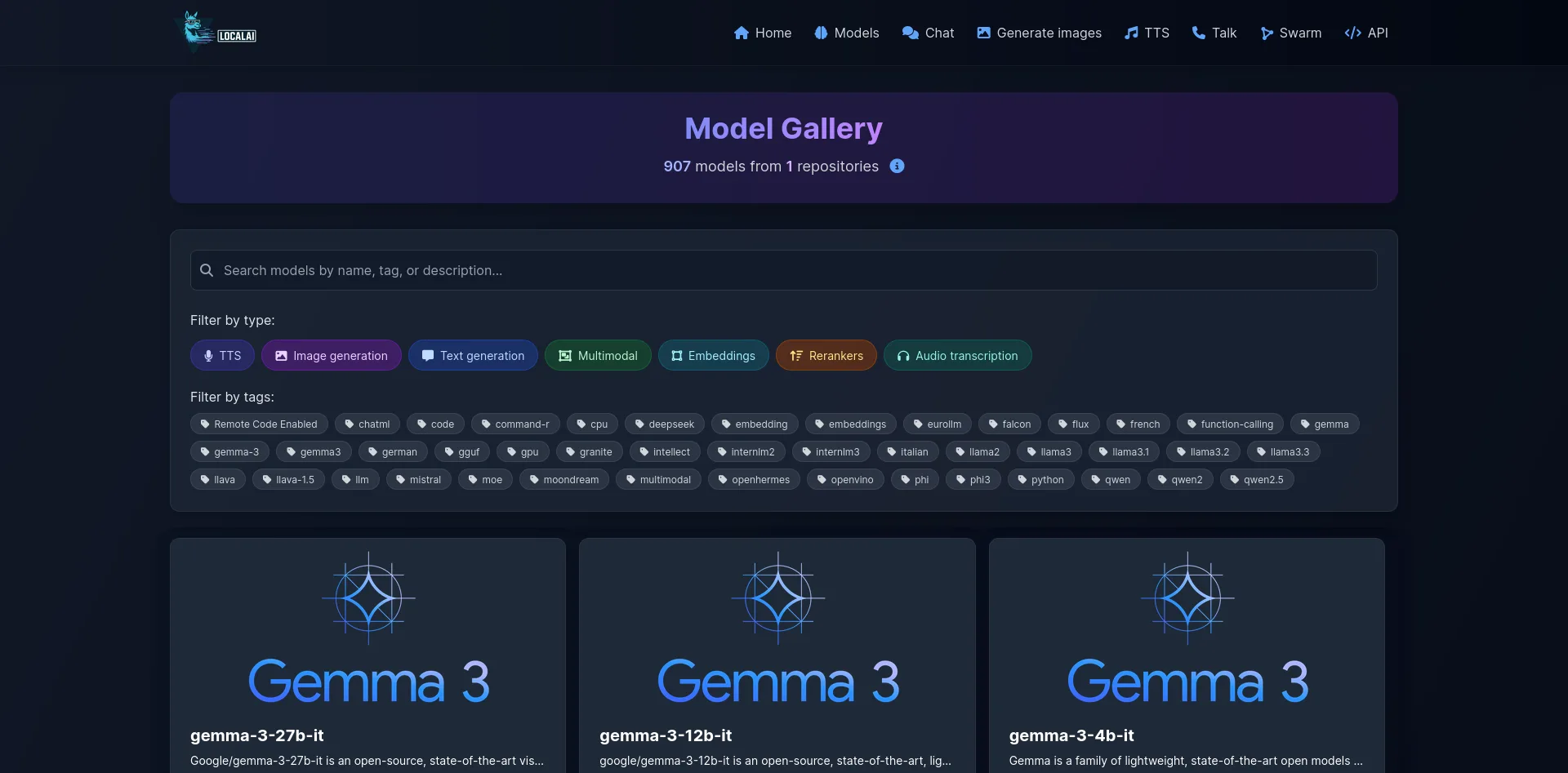

O LocalAI permite instalar e executar modelos de múltiplas fontes (galeria, Hugging Face, registro OCI e compatibilidade com o registro OCI do Ollama).

# Da galeria de modelos (lista: `local-ai models list`, WebUI, ou models.localai.io)

local-ai run llama-3.2-1b-instruct:q4_k_m

# Modelo direto do Hugging Face (GGUF)

local-ai run huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf

# Registro OCI do Ollama

local-ai run ollama://gemma:2b

# Arquivo de configuração via URL (YAML remoto)

local-ai run https://gist.githubusercontent.com/.../phi-2.yaml

# Registro OCI padrão (ex.: Docker Hub)

local-ai run oci://localai/phi-2:latestPonto operacional importante: ao instalar modelos via galeria ou YAML/URL, o projeto descreve detecção automática de GPU (NVIDIA, AMD, Intel) e download do backend apropriado, o que reduz a necessidade de pré-montar imagens específicas por stack.

Recursos avançados: agentes, MCP e soberania operacional

NOVIDADE 2026: o projeto adicionou suporte ao Model Context Protocol (MCP) para capacidades agentic com ferramentas externas, em conjunto com as capacidades de agentes do LocalAGI.

O MCP resolve um problema clássico de agentes em ambientes soberanos: como conectar o modelo local a ferramentas (web search interno, repositórios, APIs corporativas, automações) sem “vazar” tráfego para um SaaS por padrão. A proposta é padronizar a integração de ferramentas para agentes, mantendo a execução no seu perímetro.

Por que isso importa para LocalAGI

Na prática, LocalAGI se posiciona como “substituto do Responses API”, com um enfoque em:

- orquestração agentic (planejamento, execução de passos, uso de ferramentas),

- integração via MCP,

- memória e estado acoplados via LocalRecall (quando você precisa de persistência real, não só contexto de janela).

LocalRecall como “memória persistente”

Em stacks agentic, o gargalo não é só inferência. É estado: lembrar preferências, armazenar artefatos, indexar conhecimento e recuperar contexto. LocalRecall entra como API e camada de base de conhecimento para transformar “chat” em “sistema” (com histórico e memória duráveis).

Matriz de execução: CPU, NVIDIA, AMD, Intel e Apple

Um diferencial prático do LocalAI é a amplitude de execução, com backends e acelerações que cobrem:

- CPU: operação sem GPU, com foco em instruções e otimizações (AVX e quantização).

- NVIDIA: imagens dedicadas para CUDA 12 e CUDA 13.

- AMD: imagens com ROCm/hipBLAS.

- Intel: imagens com oneAPI.

- Apple Silicon: suporte a Metal e backends como MLX e MLX-VLM (conforme trilha do projeto).

Isso é relevante para DevOps porque reduz lock-in de hardware e permite desde “rodar no NUC” até “escalar com GPUs”.

Análise crítica: prós e contras

Prós

- Soberania de dados: inferência, ferramentas e memória podem ficar 100% no seu perímetro.

- Custo previsível: sem cobrança por token, apenas o custo de infraestrutura.

- Drop-in replacement: reduz fricção para migração de apps já integrados à API da OpenAI.

- Arquitetura modular: runtime mais leve, backends sob demanda, upgrades mais controláveis.

- Cobertura multimodal: texto, imagem, áudio e tarefas específicas no mesmo ecossistema.

- Variedade de aceleração: CPU, CUDA 12/13, ROCm, oneAPI, Metal, Vulkan e variantes.

Contras

- Requisitos de hardware para modelos grandes: para obter latência baixa e alta taxa de tokens, GPUs robustas fazem diferença.

- Complexidade inicial maior que SaaS: backends, modelos, armazenamento e tuning exigem disciplina operacional.

- Observabilidade e SRE ainda são responsabilidade sua: logs, métricas, quotas, multi-tenancy e governança precisam de desenho.

FAQ rápido

Preciso de GPU?

Não. O LocalAI declara operação sem GPU e oferece imagens CPU. A GPU entra para acelerar e ampliar o teto de desempenho e de modelos viáveis.

Substitui o ChatGPT?

Para muitos cenários, sim, principalmente quando o objetivo é ter um chat local com WebUI integrada e suporte multimodal. O limite prático passa a ser o seu hardware e a curadoria dos modelos.

O que muda com CUDA 13?

Você ganha um caminho de container já preparado para a pilha CUDA mais recente suportada pelo projeto, o que tende a reduzir incompatibilidades e facilitar adoção de GPUs NVIDIA atuais.

O que é “Local Stack” em uma frase?

Uma pilha local para inferência, agentes e memória, desenhada para substituir APIs SaaS mantendo dados e execução on-premises.