Por anos, o marketing de AI PC girou em torno de um número mágico: TOPS. Cada fabricante de CPU e NPU correndo para ver quem empilhava mais “trilhões de operações por segundo” para tarefas pequenas, como desfocar o fundo da webcam ou gerar legendas em tempo real. A AMD, com o AMD Ryzen AI Max+ (Strix Halo), simplesmente mudou de jogo. Em vez de disputar quem tem o NPU mais forte, ela colocou em um notebook algo muito mais ambicioso: um supercomputador de IA pessoal, focado em memória massiva para rodar modelos de data center localmente.

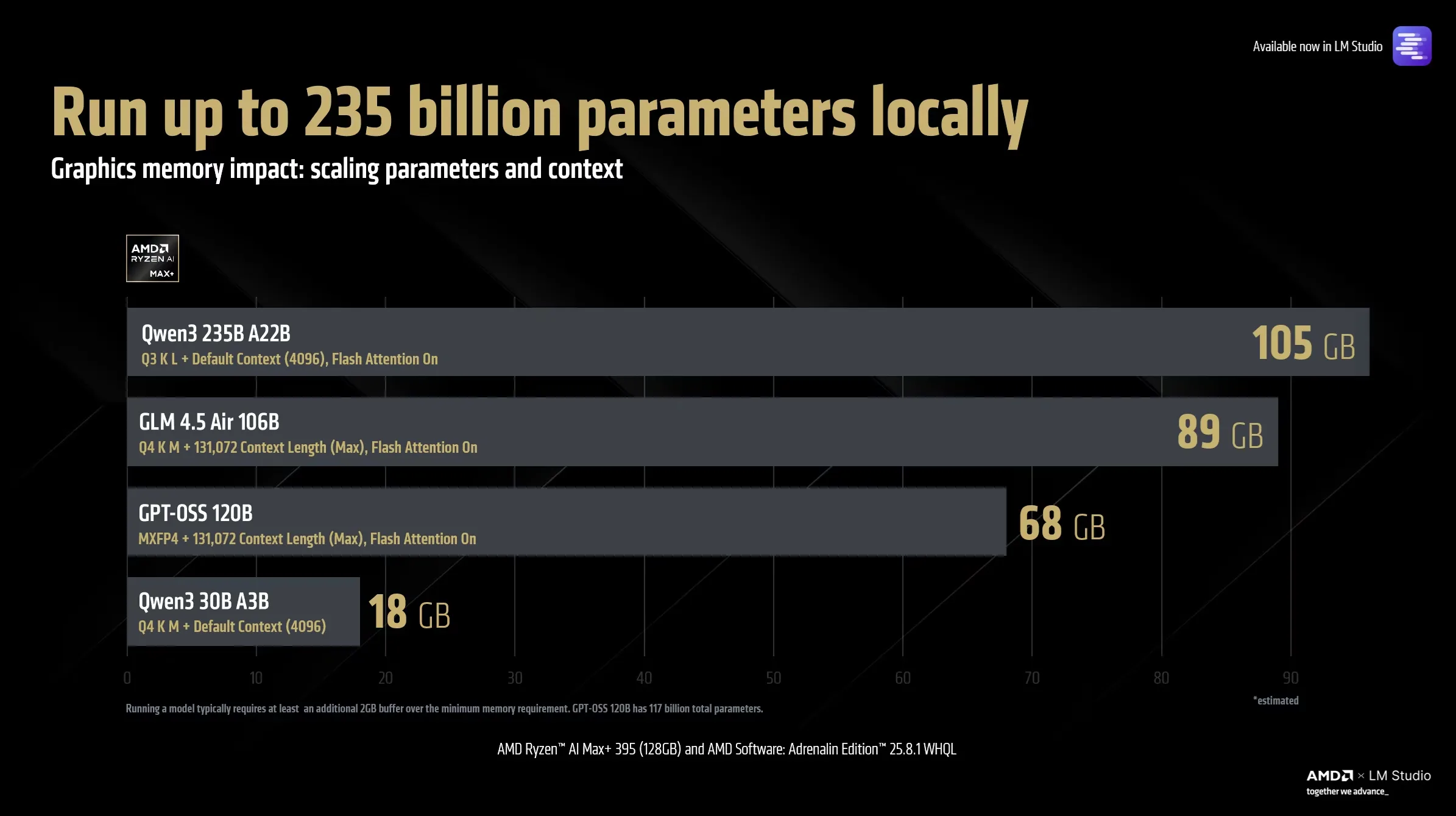

Na prática, isso significa o seguinte: a AMD está dizendo que você pode carregar um LLM de até 235 bilhões de parâmetros em um sistema x86 com Windows ou Linux, sem depender da nuvem. Modelos do porte de GPT-OSS 120B e GLM 4.5 Air deixam de ser exclusivos de clusters com GPUs de servidor e passam a caber em um único PC com AMD Ryzen AI Max+.

Mais memória, modelos maiores: a nova estratégia da AMD

A chave desta virada não é o NPU, e nem apenas a GPU. É a memória.

Enquanto a maior parte dos concorrentes foca em NPUs com muitos TOPS, mas pouca memória dedicada, o AMD Ryzen AI Max+ aposta em uma arquitetura na qual a GPU pode endereçar até 112 GB de memória, dos quais até 96 GB são dedicados como “graphics memory”.

Por que isso importa mais que TOPS brutos? Porque, em inferência de LLM, a pergunta crucial não é “quão rápido você multiplica matrizes”, e sim “qual o maior modelo que você consegue carregar inteiro na memória da GPU, com contexto alto, sem começar a ‘swapear’ e morrer de lentidão”. É o tamanho do “cérebro” que cabe na máquina.

Com esses 112 GB de memória GPU-addressable e quantização do tipo Q4 K M, a AMD afirma que é possível carregar modelos de até 235 bilhões de parâmetros em um único sistema com Ryzen AI Max+.

Em termos simples: antes, esse tipo de carga exigia GPUs como uma H100 ou MI300X em data centers. Agora, entra no território de um notebook ou mini PC x86 bem configurado.

Do “blur da webcam” ao supercomputador de IA pessoal

A analogia é direta. Até agora:

- Intel, Qualcomm e afins vendiam o AI PC como uma máquina com um NPU que age como um “assistente” para tarefas menores, em baixa potência, como efeitos de vídeo, tradução em tempo real e alguns modelos compactos.

- O AMD Ryzen AI Max+, em vez de só melhorar esse assistente, traz para o colo do usuário algo mais próximo de um nó de data center em miniatura, com foco na GPU integrada RDNA 3.x e nesse enorme pool de memória compartilhada.

Não se trata de abandonar o NPU, e sim de mudar o centro da conversa. A mensagem é: se você quer experimentar LLMs de 70B, 120B, 200B+, com contexto gigantesco e workflows complexos, o recurso crítico não é um NPU de 50 ou 60 TOPS, e sim VRAM suficiente para acomodar tudo isso com folga.

É por isso que já surgem mini PCs e estações compactas com Ryzen AI Max+ 395 e 128 GB de RAM LPDDR5X, vendidos explicitamente como máquinas para rodar localmente LLMs colossais, não apenas como “notebooks de escritório com IA”.

Como o Ryzen AI Max+ consegue rodar um LLM de 235B

O segredo está na combinação de três elementos:

- APU monolítica de alta performance

O Strix Halo reúne até 16 núcleos Zen 5, GPU integrada Radeon 8060S baseada em RDNA 3.x e um NPU XDNA 2. Tudo em um único pacote, com foco em throughput de GPU e eficiência de memória para IA de larga escala. - Memória LPDDR5X de altíssima capacidade

Em vez de depender de uma GPU dedicada com VRAM própria, o Ryzen AI Max+ usa um pool unificado de LPDDR5X, que pode chegar a 128 GB em alguns sistemas. Uma parte dessa memória pode ser “convertida” em dedicated graphics memory via BIOS e drivers (até 96 GB), o que na prática simula uma GPU de servidor com VRAM enorme, mas dentro de um form factor de notebook ou mini PC. - Endereçamento total de 112 GB pela GPU

A AMD explica que a combinação de memória dedicada e compartilhada permite à GPU endereçar até 112 GB para uso em LLMs. Com quantização adequada (Q4 K M, MXFP4, etc.), isso é suficiente para:- Rodar modelos de até 235B parâmetros.

- Manter modelos até 128B com o máximo de context length, algo essencial para workflows com tool-calling, MCP e agentes mais sofisticados.

Ou seja, não é só “caber” o modelo, é caber o modelo com contexto longo, prompt extenso, histórico e chamadas de ferramentas sem que tudo colapse em swap.

Workflows de agentes e tool-calling sem nuvem

Quando a AMD fala em “personal AI supercomputer”, a ambição não é apenas gerar texto rápido. A plataforma foi apresentada já com foco em casos como:

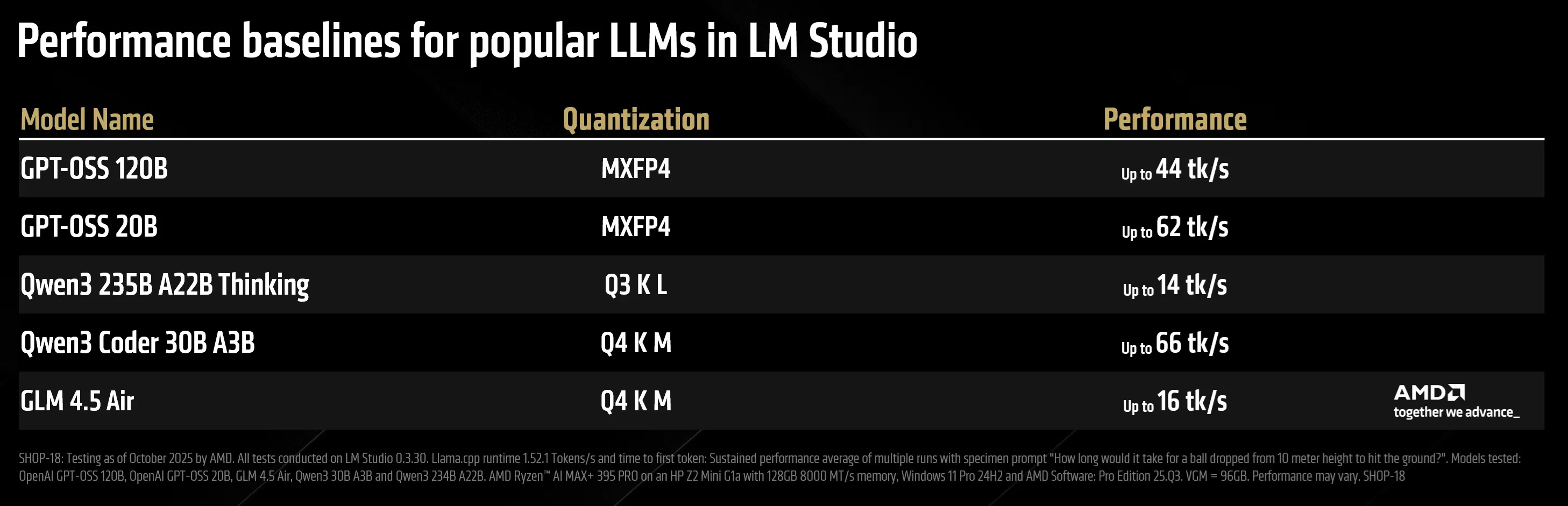

- Rodar GPT-OSS 120B localmente via LM Studio e llama.cpp.

- Explorar modelos como GLM 4.5 Air em cenários de pesquisa e desenvolvimento.

- Montar agentes autônomos com Cline + VS Code, usando MCP (Model Context Protocol) para orquestrar ferramentas e APIs de forma local.

O ponto sensível aqui é a independência da nuvem. Não é que data centers desapareçam de uma hora para outra, mas, para uma grande fatia de desenvolvedores, startups e laboratórios, passa a ser totalmente viável:

- Prototipar agentes complexos em casa, mantendo dados sensíveis offline.

- Treinar e ajustar modelos menores e médios e depois só escalar na nuvem o que realmente demandar.

- Transformar um desktop x86 ou um mini PC em um “servidor de IA pessoal”, atendendo outros dispositivos da rede local.

Para o ecossistema de local LLMs, que já abraçou o Ryzen AI Max+ em benchmarks comunitários, isso é praticamente um novo patamar de referência.

Ecossistema x86, ROCm e Pytorch no Windows

Outro ponto importante é que a AMD não está vendendo apenas o silício. O AMD Ryzen AI Max+ vem acompanhado de:

- Suporte ao Windows com foco em ROCm e builds noturnos de Pytorch para Windows, permitindo que desenvolvedores usem as mesmas ferramentas que já dominam em servidores, mas agora em um laptop ou mini PC.

- Integração com o ecossistema x86 tradicional, mantendo compatibilidade com aplicações de produtividade, jogos e softwares legados.

- Uma narrativa de open innovation alinhada ao stack ROCm, que facilita portar modelos e workloads entre Instinct GPUs no data center e hardware client, como o Strix Halo.

Na prática, isso significa que o salto de “rodar na nuvem” para “rodar localmente” fica muito menor em termos de código. O mesmo Pytorch, o mesmo ecossistema Python, os mesmos frameworks, só que agora com a opção de apontar para um Ryzen AI Max+ em vez de um cluster remoto.

O que muda para desenvolvedores, empresas e entusiastas

Para o usuário final, o impacto imediato talvez seja sutil: o notebook continua parecendo um notebook. Para quem está por trás dos modelos, no entanto, a história é outra.

- Desenvolvedores indie e pesquisadores podem testar modelos e arquiteturas que antes dependiam de GPUs alugadas por hora.

- Empresas pequenas e médias conseguem manter dados sensíveis em casa, usando modelos grandes em modo air-gapped para protótipos, POCs e até workloads internos.

- Entusiastas de IA local recebem uma nova “plataforma de sonho”: um sistema x86 que concorre diretamente com máquinas baseadas em GPUs dedicadas de 80 GB para rodar LLMs de altíssima escala.

Se a promessa do AMD Ryzen AI Max+ (Strix Halo) se sustentar na prática, esta pode ser lembrada como a geração em que o termo AI PC deixou de significar “efeitos bonitos na webcam” e passou a significar algo mais próximo de um data center pessoal em forma de laptop.