A AMD decidiu provar, na prática, o que significa um AI PC virar cérebro de robô. O STX-B0T é um protótipo de robô assistente criado pelo Advanced Technologies Group (ATG) da empresa para mostrar o poder do recém-anunciado Ryzen AI Max+ “Strix Halo” em um cenário bem concreto: um robô social que segue pessoas, desvia de obstáculos e imita seus gestos em tempo real, rodando tudo localmente em um simples laptop.

Pense nos robôs tradicionais como o Batman: para “enxergar” o mundo, eles carregam um cinto de utilidades caro e pesado, com LiDAR, sensores de profundidade e radares espalhados pela carcaça. O STX-B0T, por outro lado, joga nesse campo como o Superman. Ele usa só os “olhos” de uma webcam comum de notebook e um “super-cérebro” baseado em AMD STX-B0T Ryzen AI para interpretar a cena, estimar profundidade, entender gestos e tomar decisões em frações de segundo. Nada de nuvem, nada de data center escondido nos bastidores.

Visão de super-homem: como o STX-B0T enxerga o mundo

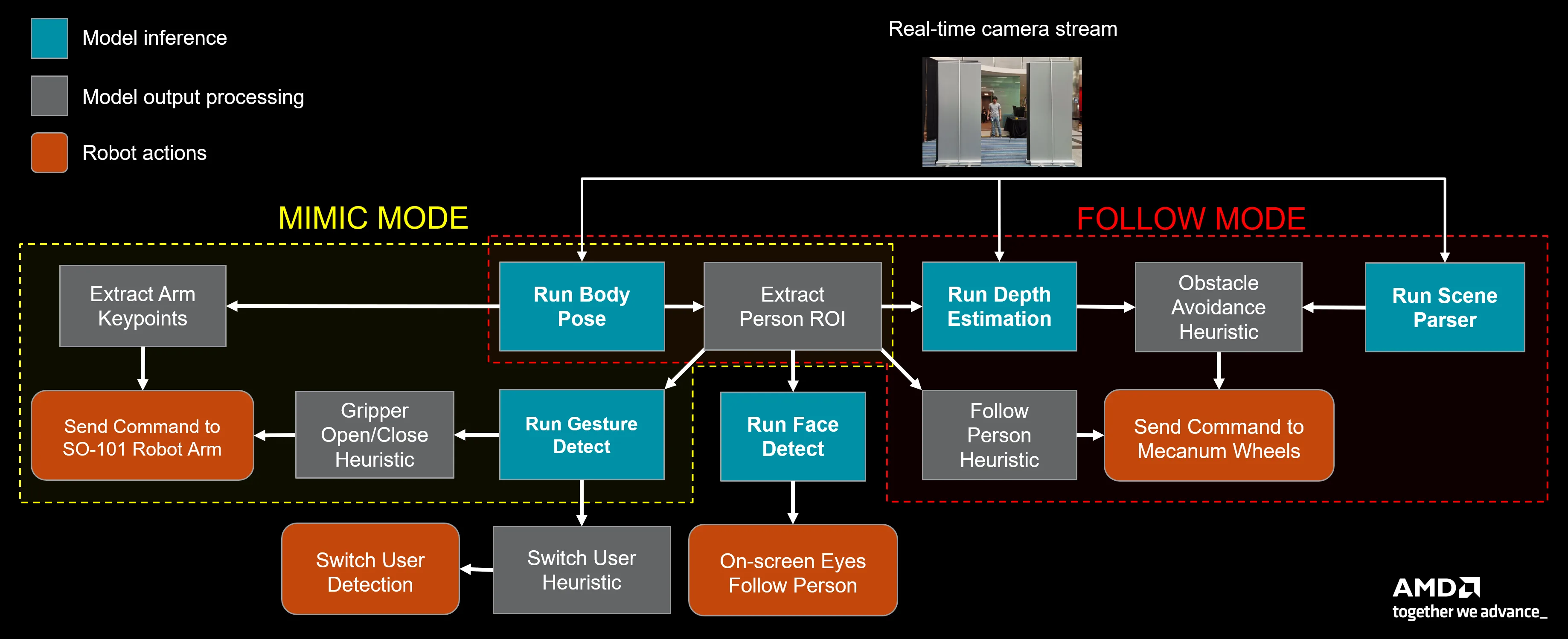

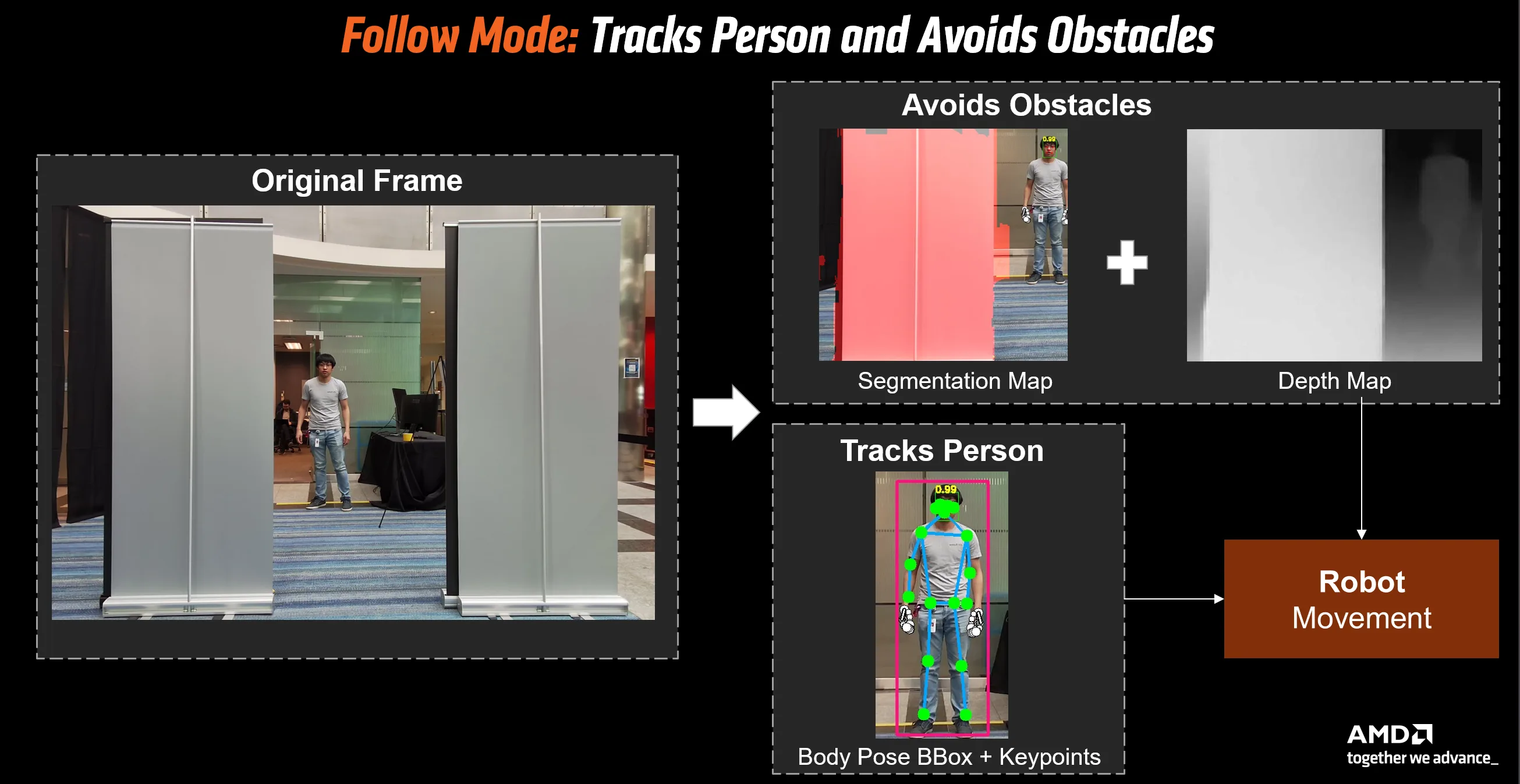

A mágica começa em algo que todo notebook moderno tem: a webcam. No caso do protótipo, é uma câmera de 5,2 megapixels integrada ao AMD ISP (Image Signal Processing) do HP ZBook Ultra, e ela é o único sensor do robô. Cada quadro dessa câmera passa por um pipeline de modelos de visão computadorizada rodando em cima do Ryzen AI CVMLSDK, a pilha de Computer Vision e Machine Learning da AMD.

A partir desse único fluxo de vídeo, o STX-B0T roda, em tempo real:

- Detecção de rosto e detecção de corpo/pose para entender a posição das articulações humanas.

- Reconhecimento de gestos para interpretar comandos como “um”, “dois”, “apontar” ou “OK”.

- Um scene parser para rotular elementos da cena (parede, chão, cadeira).

- Um modelo de estimativa de profundidade que extrai um mapa de distância relativo a partir da imagem 2D.

Juntos, esses modelos transformam pixels em compreensão espacial. É aqui que entra o conceito de IA Física: em vez de limitar a IA a uma janela de chat ou a um filtro de vídeo, a AMD mostra como o mesmo PC que você usaria para programar ou navegar pode entender o mundo ao redor e comandar motores, rodas e garras em tempo real, sem depender de um servidor remoto.

O cérebro Ryzen AI Max+: laptop como central de IA física

No coração do STX-B0T está um HP ZBook Ultra equipado com o Ryzen AI Max+ 395, um APU Strix Halo de nova geração. É ele que concentra CPU, GPU integrada (iGPU) e NPU em um único pacote, fornecendo o desempenho necessário para rodar múltiplos modelos de visão simultaneamente.

A arquitetura de software foi pensada exatamente para explorar esse combo. Os modelos de visão são otimizados para rodar na NPU por meio do CVMLSDK, enquanto tarefas de inferência adicionais são empurradas para a iGPU usando MIGraphX em cima do ecossistema ROCm. Isso cria um pipeline híbrido NPU + GPU que mantém a latência baixa mesmo com várias redes neurais ativas ao mesmo tempo.

O ATG deixa claro que o STX-B0T não é só um brinquedo de laboratório. Ele é pensado como plataforma de referência para futuros projetos de robótica e sistemas embarcados baseados em Ryzen AI, mostrando que é possível fazer percepção avançada no próprio dispositivo, sem depender de nuvem para processar vídeo ou tomar decisões de navegação.

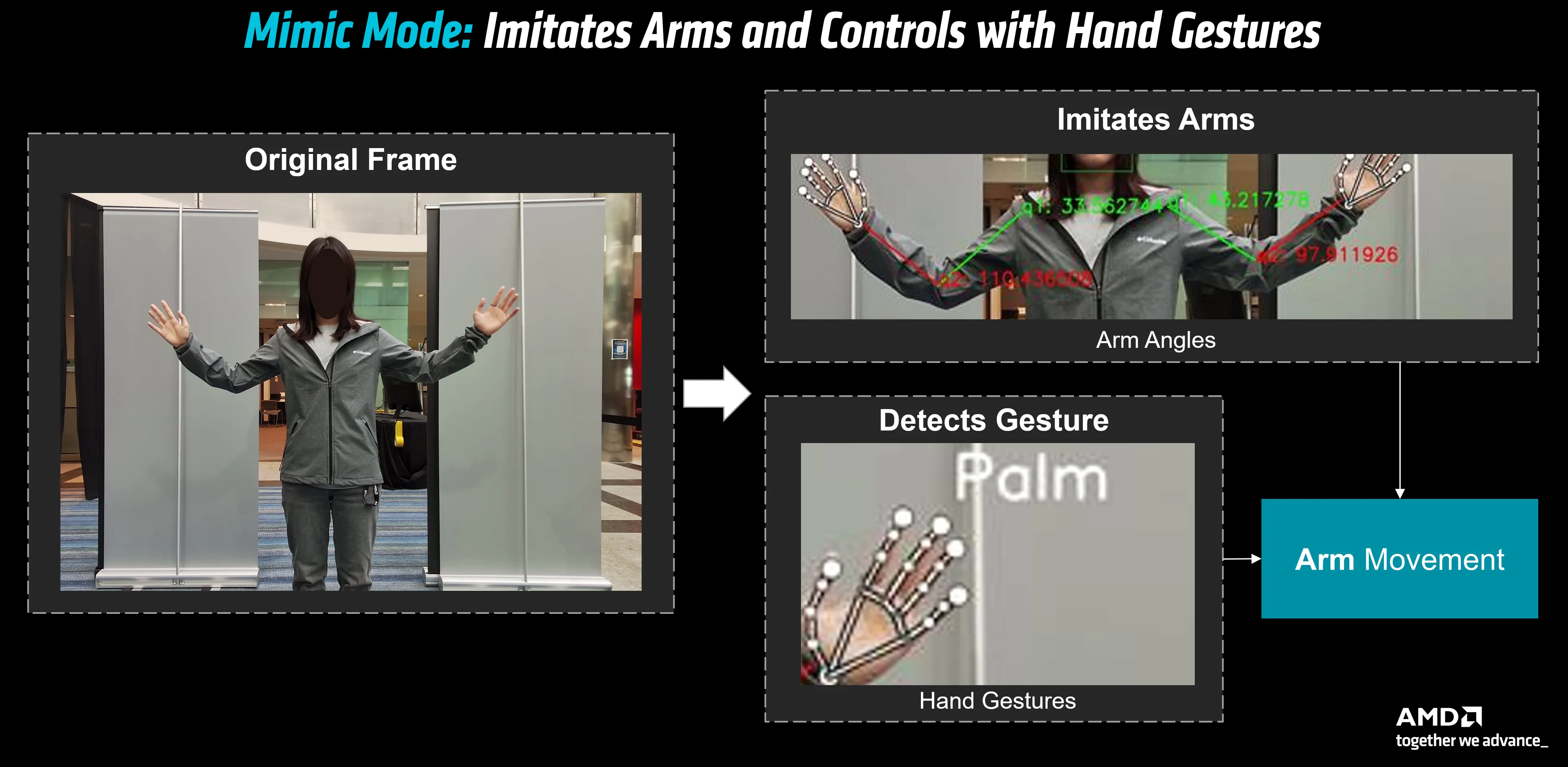

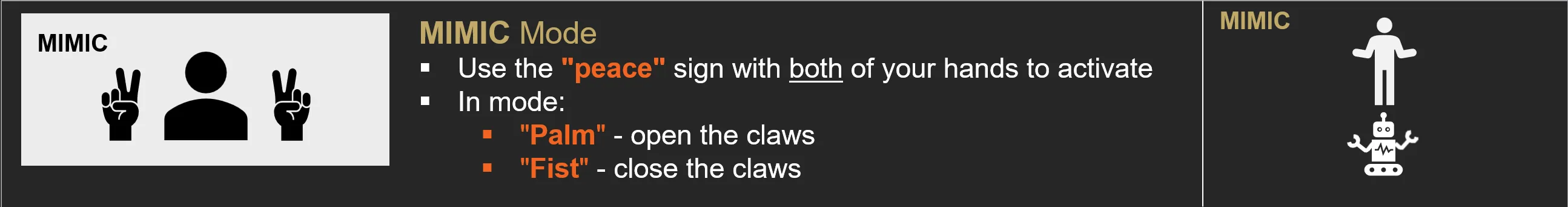

Modo MIMIC: o robô que imita seus gestos

O primeiro “superpoder” do STX-B0T é o modo MIMIC. Quando o usuário faz o gesto de “dois” (o clássico sinal de paz), o robô entra em um estado em que passa a espelhar os movimentos dos braços humanos.

Funciona assim: o modelo de detecção de corpo do CVMLSDK extrai, em tempo real, as coordenadas das articulações dos braços do usuário. A partir dessas coordenadas em pixels, o software calcula ângulos de ombro, cotovelo e punho. Esses ângulos são convertidos em comandos seriais enviados para um Arduino Mega, que por sua vez aciona os servomotores dos braços robóticos SO-101, montados em ambos os lados do robô.

Por segurança, o time da AMD limita o alcance de movimentação de cada junta e monitora a corrente nas garras para evitar esmagar objetos ou se chocar com a própria estrutura. Gestos adicionais, como “palma aberta” ou “punho fechado”, controlam abertura e fechamento das garras, o que transforma o robô em um espelho físico dos movimentos do usuário e abre caminho para aplicações de teleoperação mais avançadas.

Modo FOLLOW: seguir pessoas e desviar de cadeiras com uma câmera só

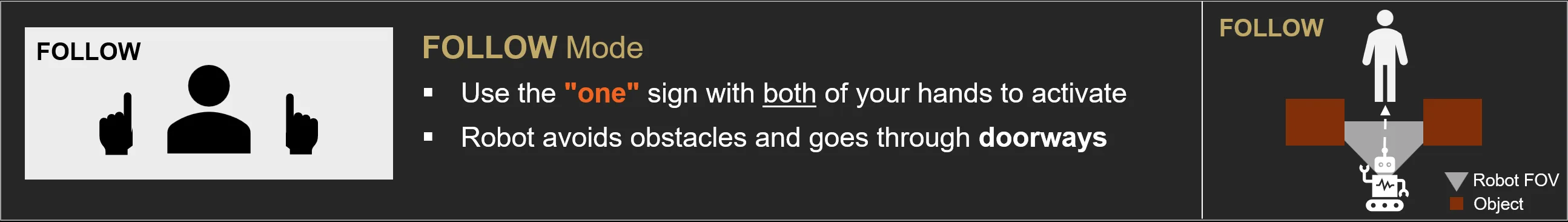

O outro modo principal é o FOLLOW. Um gesto simples, mostrando “um” com a mão, coloca o STX-B0T em modo perseguidor amigável: ele escolhe uma pessoa na cena, centraliza a bounding box dessa pessoa no quadro e passa a seguir, mantendo uma distância pré-definida.

A graça aqui é que, de novo, tudo se baseia em visão monocular. O robô usa pose estimation para encontrar o corpo-alvo, aplica o scene parser para entender onde estão paredes, chão e cadeiras, e roda o modelo de profundidade para descobrir o que está “na frente” de quem está sendo seguido. Se o sistema detecta um obstáculo entre o robô e a pessoa, ele decide se precisa se deslocar lateralmente para a esquerda ou para a direita antes de avançar, usando a base de rodas Mecanum que permite esse “strafing” suave sem girar o corpo inteiro.

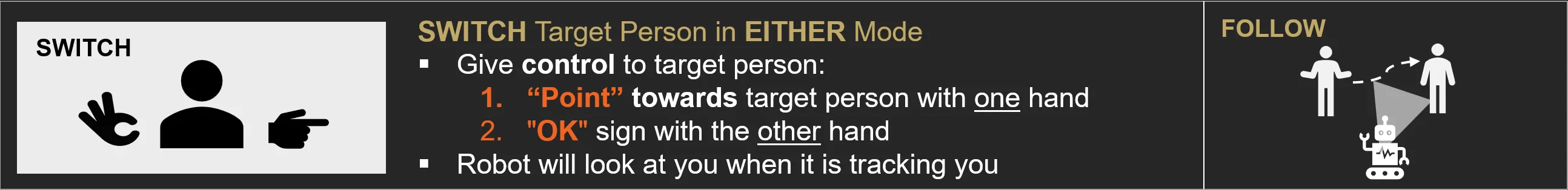

O FOLLOW também é social. Em um escritório, você pode querer que o robô pare de seguir uma pessoa e passe a acompanhar outra. Para isso, o ATG criou um protocolo de gestos: quem está sendo seguido aponta para a nova pessoa e, em seguida, faz o gesto de “OK”. O algoritmo calcula a distância do dedo apontando até as outras pessoas na imagem e troca o alvo para quem estiver mais próximo dessa linha de visão, exibindo em seguida o rosto da nova pessoa recortado na tela do robô como confirmação visual.

Por que o STX-B0T importa na corrida dos AI PCs

O STX-B0T é uma mensagem bem clara da AMD: o “AI PC” não precisa ficar preso à mesa, ele pode ganhar rodas e braços. Um único laptop com Ryzen AI Max+ coordena visão, planejamento básico de movimento e controle de hardware em tempo real, o que até pouco tempo atrás parecia território exclusivo de estações de trabalho com GPUs de data center.

No roadmap, o ATG já fala em integrar um assistente de voz local usando GAIA, estender o controle dos braços para o espaço 3D com modelos VLA como o Pi0, e treinar comportamentos em simulação usando o ambiente de RL Schola, tudo ainda dentro do ecossistema Ryzen AI e ROCm.

Para a comunidade de robótica e visão computacional, o recado é simples: se você tem interesse em IA Física, pode usar o mesmo stack de software disponível publicamente no repositório Ryzen AI no GitHub para construir seus próprios protótipos, combinando modelos de visão com hardware relativamente acessível, sem a necessidade de construir uma infraestrutura de nuvem só para experimentação.