Rodar um LLM local é ótimo para privacidade e para fugir de limites de API, mas ainda deixa uma pergunta no ar: como transformar esse modelo em um aplicativo útil, tipo um chatbot que lê seus PDFs, sem escrever um backend inteiro?

A combinação Dify + Lemonade Server + AMD Ryzen AI resolve exatamente isso.

Pense assim:

- Lemonade Server é o motor de alta performance do carro, usando NPU e iGPU do seu PC com AMD Ryzen AI para rodar o LLM.

- Dify é o chassi e o painel: ele permite que você conecte o motor aos seus documentos (a “base de conhecimento”) e a uma interface de chat, usando caixinhas em um editor visual.

Este guia mostra, passo a passo, como você também pode montar esse carro e criar um “ChatGPT de documentos” 100% local com Dify AMD Ryzen AI.

O que é Dify e o que é o Lemonade Server?

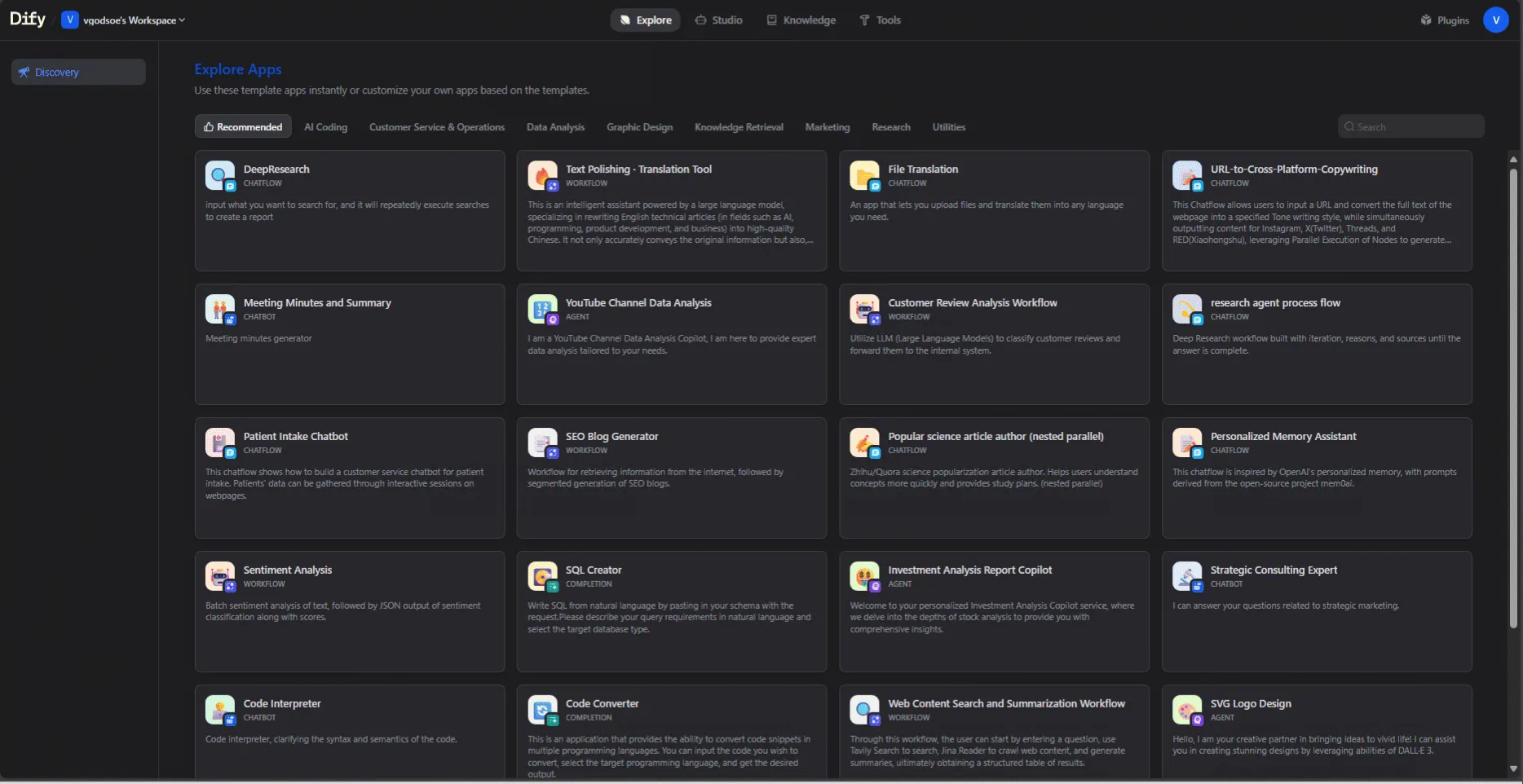

Dify: o “designer visual” de workflows de IA

O Dify é uma plataforma open source que permite montar aplicações de IA com workflows visuais. Em vez de programar, você conecta nós:

- Nó de Input: recebe a pergunta do usuário.

- Nó de Knowledge / Retrieval: busca trechos relevantes nos seus documentos.

- Nó de LLM: o modelo que gera a resposta.

- Nó de Output: devolve a resposta para o chat.

Ele já traz recursos de RAG (Retrieval-Augmented Generation), agentes, datasets e APIs, mas continua acessível para quem não é especialista em ML.

Lemonade Server: o motor de LLM local da AMD

O Lemonade Server é o runtime local da AMD que:

- Baixa e gerencia modelos como Qwen, Llama e DeepSeek.

- Usa NPU, iGPU e outras acelerações (Vulkan, ROCm, etc.) para rodar o modelo com boa performance.

- Expõe uma API compatível com OpenAI na sua máquina, em um endpoint local.

Na prática, qualquer ferramenta que hoje conversa com a API da OpenAI pode conversar com o Lemonade mudando apenas a URL. O Dify aproveita isso para tratar o Lemonade como mais um “provedor de modelo”.

Passo 1: escolhendo o sistema operacional e instalando os pré-requisitos

O fluxo é o mesmo em qualquer lugar: você precisa de Docker, Dify e Lemonade Server rodando na mesma máquina ou na mesma rede. A diferença está nos detalhes de instalação.

No Windows 11 com AMD Ryzen AI (caminho recomendado)

Se você tem um notebook com AMD Ryzen AI rodando Windows 11, este é o caminho mais direto.

- Instale o Docker Desktop

- Baixe o instalador do Docker Desktop para Windows.

- Durante a instalação, ative o suporte a WSL 2 se for solicitado.

- Depois de instalar, abra o Docker Desktop e confirme que:

- O backend está em modo Linux (containers Linux).

- O Docker está “Running”.

- Instale o Lemonade Server

- Baixe o instalador do Lemonade Server para Windows.

- Conclua a instalação padrão.

- Abra o aplicativo e verifique se o ícone aparece na bandeja do sistema.

- O Lemonade costuma expor um servidor local na porta

8000.

Você deve terminar este passo com algo comohttp://localhost:8000respondendo.

- Teste rápido do Lemonade

- Se quiser conferir, use um cliente HTTP (curl, Insomnia, Postman) para chamar o endpoint de modelos.

- O importante é saber que o Lemonade está rodando e consegue listar pelo menos um modelo (mesmo que ainda não baixado).

- Baixe um modelo no Model Manager

- No ícone do Lemonade, abra o Model Manager.

- Escolha um modelo de instrução, por exemplo Qwen2.5-7B-Instruct-Hybrid.

- Clique para baixar e aguarde o download terminar.

No Linux com GPU AMD (caminho para usuários avançados)

Se você usa Linux e já está acostumado com Docker e drivers de GPU, o fluxo é semelhante, com um pouco mais de cuidado em drivers.

- Instale Docker e Docker Compose

- Use o gerenciador de pacotes da sua distro para instalar Docker e Docker Compose.

- Habilite e inicie o serviço do Docker (por exemplo,

sudo systemctl enable --now docker).

- Instale e rode o Lemonade Server

- Siga as instruções da versão Linux do Lemonade Server (binário, AppImage ou container, conforme o projeto disponibilizar).

- Deixe o Lemonade ouvindo em

http://localhost:8000ou na porta que você escolher.

- Verifique drivers e aceleração

- Em desktops com GPU AMD, certifique-se de que os drivers e, se desejado, ROCm estão configurados.

- O Lemonade usará o backend mais adequado disponível.

- Baixe o modelo no gerenciador do Lemonade

- Assim como no Windows, use o gerenciador de modelos do Lemonade para baixar algo como Qwen2.5-7B-Instruct-Hybrid.

O restante do tutorial é igual: uma vez que Lemonade e Docker estejam rodando, o Dify se comporta da mesma forma.

Passo 2: configurando o Dify para rodar local

Com Docker pronto, vamos subir o Dify.

No terminal (Windows com WSL ou Linux):

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker compose up -dEsses comandos:

- Baixam o repositório do Dify.

- Entram na pasta de configuração com Docker.

- Copiam um

.envde exemplo. - Sobem todos os serviços (banco, backend, frontend) em contêineres.

Quando o Docker terminar, abra o navegador em:

http://localhost/Faça o cadastro da conta administrador e entre no painel do Dify.

Passo 3: conectando o Dify ao Lemonade Server

Agora vamos dizer ao Dify que o seu provedor de modelo é o Lemonade.

- No painel do Dify, acesse a área de Plugins / Model Providers.

- Procure por Lemonade e instale.

- Vá em Settings → Model Providers → Lemonade → Add a Model.

- Preencha os campos principais:

- Model Name: por exemplo

Qwen2.5-7B-Instruct-Hybrid. - Model Type:

LLM. - API endpoint URL:

- Em Docker Desktop (Windows ou Linux):

http://host.docker.internal:8000. - Se isso não funcionar no Linux, use o IP do host, por exemplo

http://172.17.0.1:8000ou o IP retornado porhostname -I.

- Em Docker Desktop (Windows ou Linux):

- Model context size: comece com

2048e aumente se a sua máquina aguentar. - Campos opcionais como Agent Thought e Vision Support podem ser ativados conforme as capacidades do modelo.

- Model Name: por exemplo

Repita para cada modelo que quiser expor ao Dify através do Lemonade.

Exemplo: criando um chatbot “Ask My Docs” privado

Com o “motor” e o “designer” conectados, vamos montar o seu chatbot de documentos.

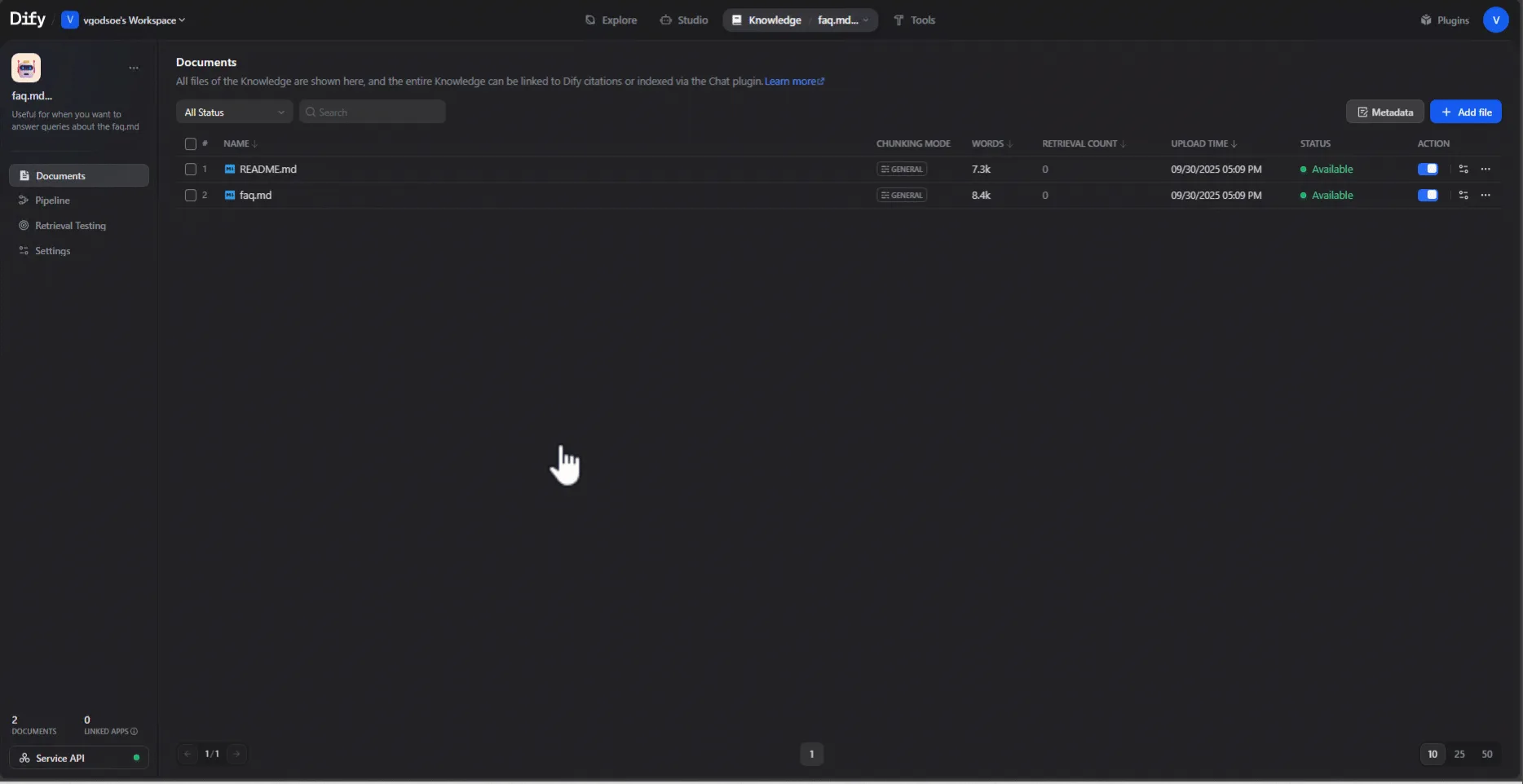

1. Criar a base de conhecimento

- No Dify, vá em Knowledge / Datasets.

- Crie uma nova base de conhecimento, por exemplo “Documentos internos”.

- Faça upload dos seus PDFs, arquivos Markdown e outros documentos de texto.

- Aguarde o processo de indexação. O Dify vai criar embeddings e preparar a busca semântica.

Nada disso sai da máquina. Toda a indexação acontece localmente.

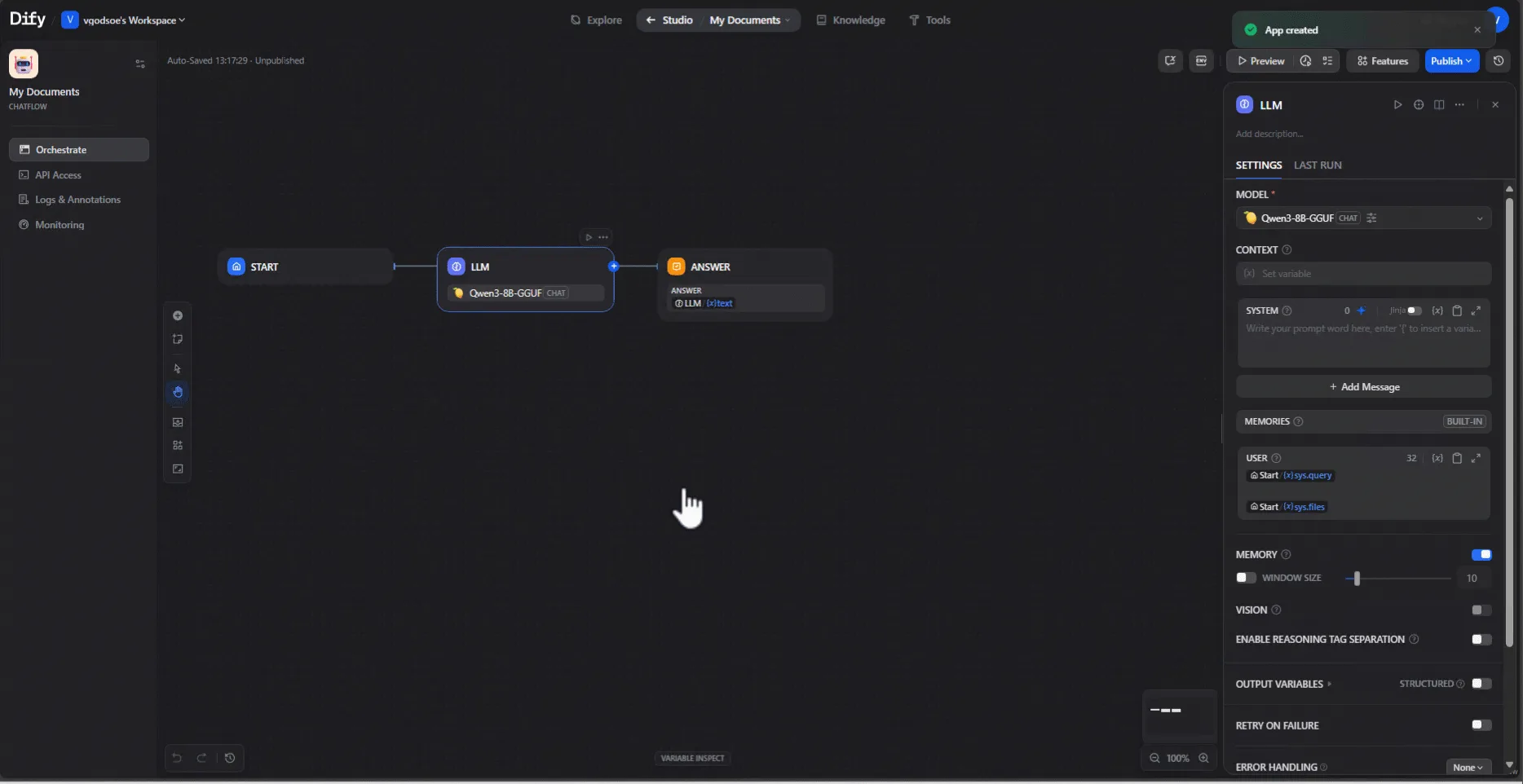

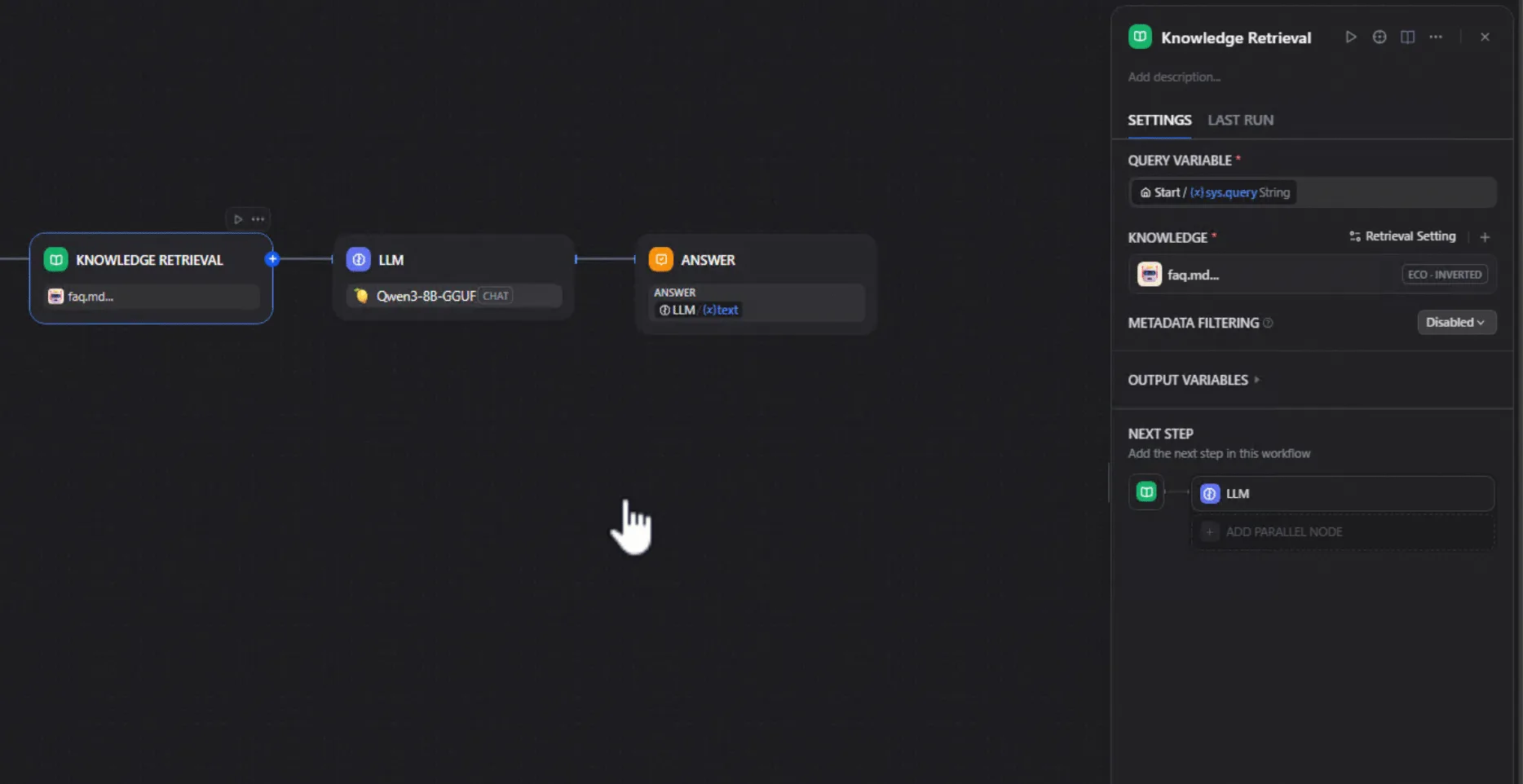

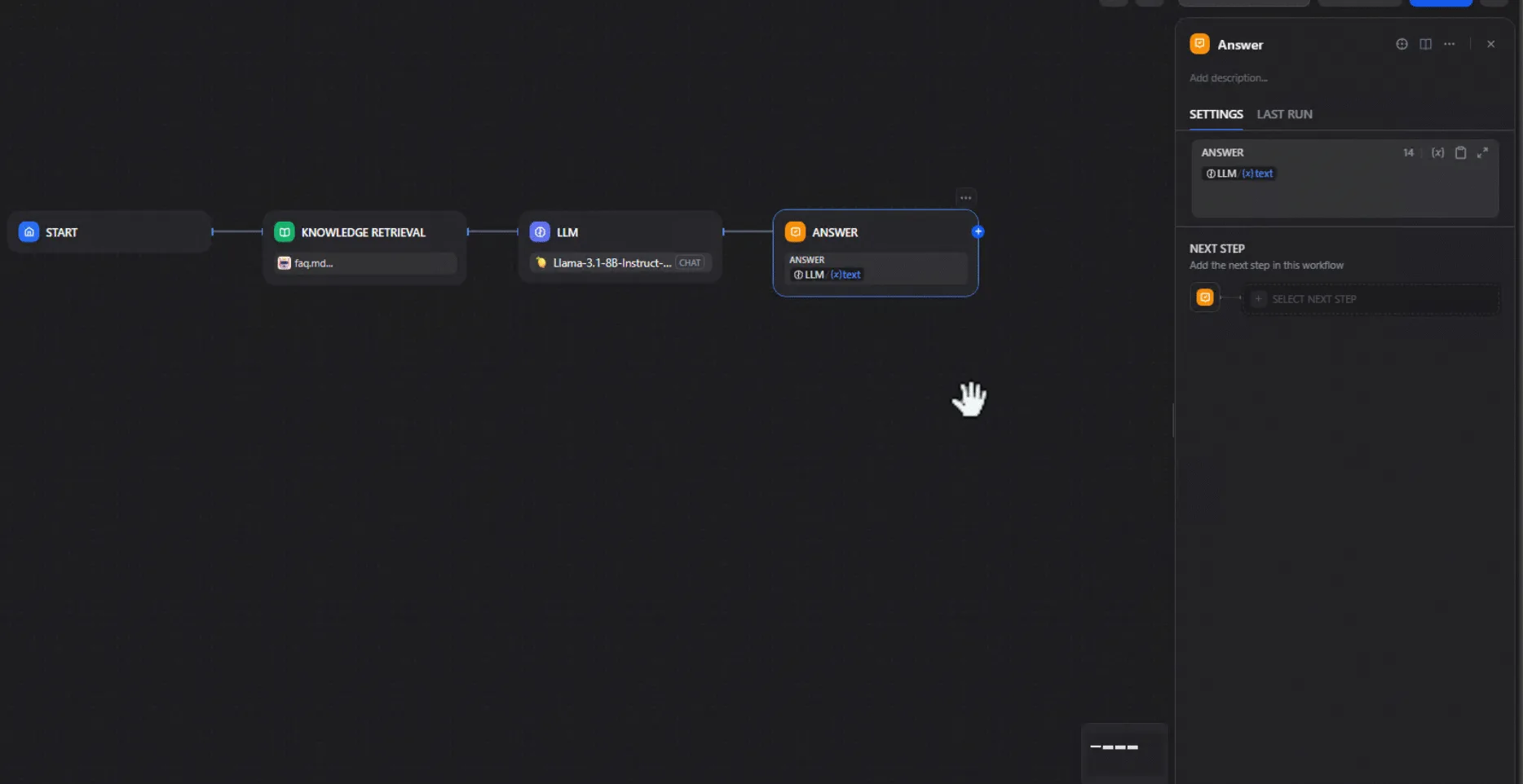

2. Criar o Chatflow

- Vá em Apps e crie um novo app do tipo Chatbot.

- Acesse a aba de Workflow / Chatflow.

- Você verá um fluxo básico:

Input → LLM → Output.

Vamos inserir o Retrieval no meio.

3. Adicionar o nó de Knowledge Retrieval

- Adicione um nó Knowledge Retrieval.

- Selecione a base “Documentos internos”.

- Ajuste quantos trechos de contexto serão retornados.

Depois conecte tudo assim:

Input → Knowledge Retrieval → LLM → OutputAgora você tem um fluxo de RAG: primeiro o sistema busca trechos relevantes nos documentos, depois passa isso para o LLM.

4. Escolher o LLM local via Lemonade

No nó LLM:

- Selecione o provedor Lemonade.

- Escolha o modelo cadastrado, por exemplo

Qwen2.5-7B-Instruct-Hybrid. - Ajuste temperatura, tamanho máximo de resposta e outros parâmetros conforme sua preferência.

5. Configurar o System Prompt

No System Prompt, você define o “contrato” com o modelo. As ideias principais são:

- Deixar claro que ele é um assistente que responde perguntas sobre os documentos carregados.

- Dizer que ele deve usar apenas o contexto enviado pelo nó de Retrieval.

- Orientar que, se a informação não estiver nos documentos, ele deve dizer isso explicitamente, sem inventar.

Algo como: usar linguagem clara, citar de onde veio a informação no contexto e admitir quando não há dados suficientes.

Depois de salvar, teste o chatbot fazendo perguntas que você sabe estar respondidas nos seus PDFs e outras perguntas que você sabe que não estão, para validar o comportamento.

Por que esse setup faz sentido para privacidade e times

Ao juntar Dify AMD Ryzen AI com o Lemonade Server, você ganha:

- Privacidade total dos documentos: nada precisa sair da máquina, nem para inferência, nem para indexação.

- Baixa latência e custo previsível: o LLM roda na NPU e na GPU integradas, sem cobrança por token.

- Fluxo low-code: o time monta o aplicativo arrastando nós no Dify, sem precisar escrever um backend do zero.

É uma forma prática de levar RAG e LLM local para dentro da sua rotina ou da sua organização, com um equilíbrio saudável entre poder técnico e simplicidade de uso.