O fim da era dos chatbots tradicionais parece estar mais próximo do que imaginamos. Com a análise do código beta 17.4 do app Google, descobriu-se que o Gemini está prestes a evoluir de um assistente de texto para um verdadeiro agente de IA, capaz de interagir com aplicativos e realizar tarefas do mundo real, como pedir comida, reservar viagens e até gerenciar compromissos. Essa mudança promete transformar o Android 16 QPR3 em um ecossistema mais inteligente e automatizado, mas também levanta questões importantes sobre privacidade e supervisão do usuário.

O que é o projeto bonobo e a automação de tela

O projeto bonobo é o núcleo da nova funcionalidade de automação de tela Gemini. Ele permitirá que a IA controle aplicativos diretamente, clicando em botões, preenchendo formulários e navegando por menus sem intervenção humana constante. Imagine abrir o iFood, selecionar sua refeição e finalizar o pedido sem tocar na tela, ou reservar um voo pelo app de companhias aéreas com comandos de voz ou via texto.

O Google deixa claro que essa automação não funciona como magia: o bonobo depende de instruções precisas e pode cometer erros se houver mudanças nos aplicativos ou falhas de rede. Por isso, ele foi projetado para operar sob supervisão humana constante.

Como a supervisão humana funciona

Mesmo com o Gemini atuando no Android 16, o usuário mantém o controle total. Sempre que a IA tentar realizar uma ação, uma notificação alertará sobre a operação em andamento, permitindo que você aceite, modifique ou cancele a tarefa. Esse modelo de supervisão garante que a responsabilidade final pelo que é feito nos aplicativos continue com o usuário, evitando problemas como pedidos duplicados, compras equivocadas ou alterações não autorizadas.

Essa abordagem cria um equilíbrio entre produtividade e segurança, transformando o agente de IA Google em um assistente proativo, mas não autônomo demais.

Privacidade em jogo

Com o bonobo interagindo com aplicativos, surge a questão da privacidade. O Google confirmou que treina partes da IA com screenshots para melhorar a compreensão de interfaces e processos, e que humanos podem revisar algumas capturas de tela para fins de aprimoramento.

Para proteger dados sensíveis, como informações de pagamento, o sistema implementa criptografia ponta a ponta e minimiza o armazenamento de dados confidenciais. Ainda assim, usuários devem estar atentos ao compartilhar informações pessoais, pois a automação completa exige confiança na plataforma.

Essa atenção à privacidade será um fator determinante para a adoção do Gemini no Android 16, principalmente entre usuários que realizam transações financeiras frequentes.

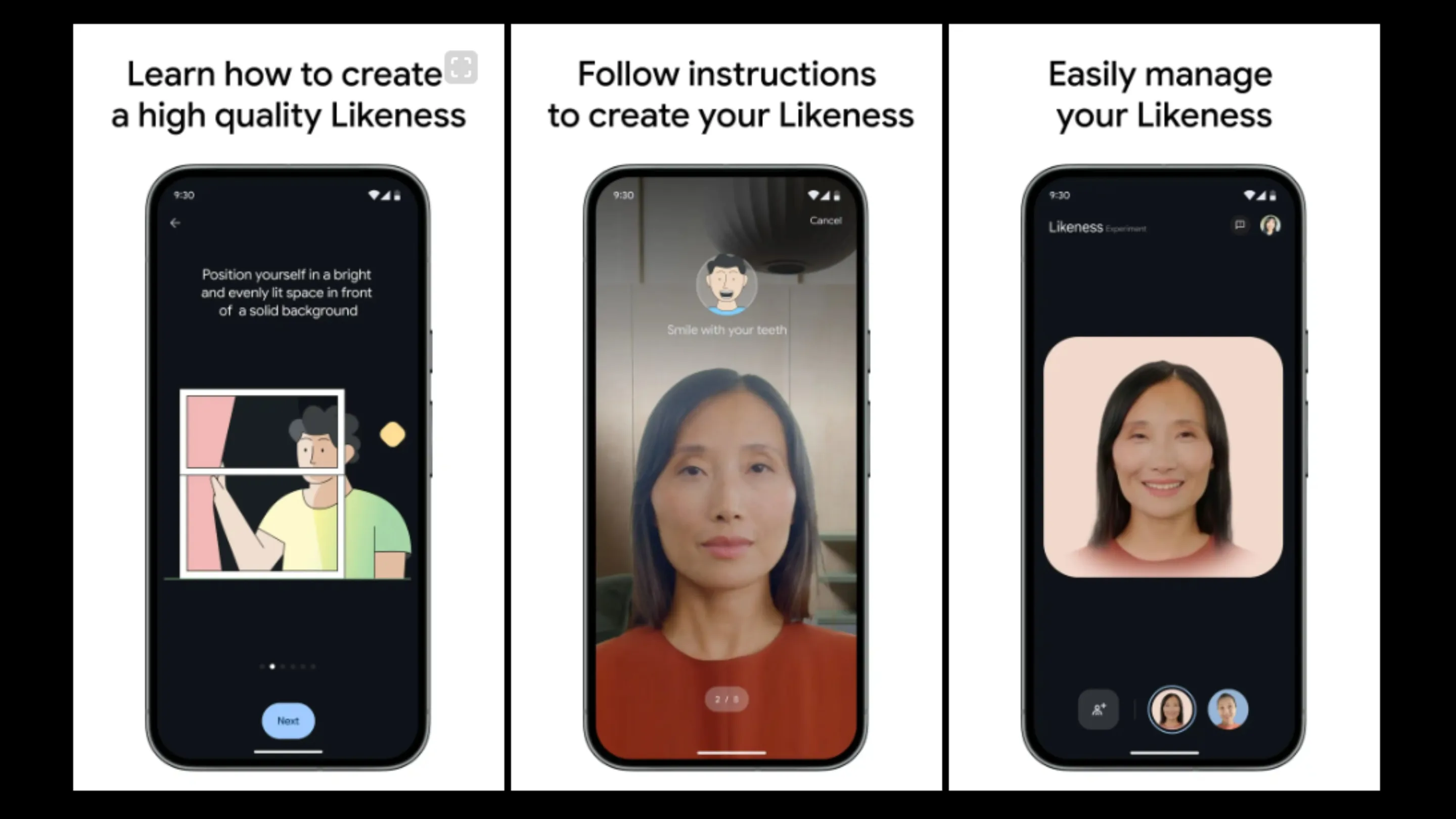

Projeto wasabi e o recurso likeness

Paralelamente, o projeto wasabi está trazendo avatares 3D realistas para o Android, integrando o Gemini ao Android XR. Com o recurso likeness, será possível criar personagens digitais que interagem com você de forma visual e verbal, tornando a experiência de assistência virtual mais humana e imersiva.

Essa funcionalidade vai além do entretenimento. Imagine ter um avatar que orienta você enquanto agenda compromissos, ensina receitas ou ajuda em compras online, tudo dentro do ecossistema mobile. A integração com Android 16 QPR3 novidades garante que essa experiência seja fluida e compatível com a maioria dos dispositivos recentes.

Quando o recurso chega ao Android 16

Segundo o cronograma divulgado internamente, a integração completa do Gemini com automação de tela e avatares deve chegar com o QPR3 de março de 2026. Isso significa que usuários de Android 16 poderão testar os agentes de IA Google em aplicativos de uso diário, aproveitando funcionalidades avançadas de produtividade e personalização visual.

Ainda que a chegada seja próxima, o Google mantém o recurso em fase beta para ajustes finos de estabilidade, segurança e experiência do usuário, o que indica um lançamento gradual e controlado.

Conclusão e impacto

O Gemini no Android 16 representa uma mudança significativa na forma como interagimos com smartphones. Transformando comandos simples em tarefas automatizadas, e combinando isso com avatares 3D realistas, o Google propõe um futuro onde o dispositivo atua quase como um assistente pessoal completo.