Uma descoberta recente via APK Teardown revelou sinais promissores de que o Gemini, o assistente de inteligência artificial do Google, poderá em breve aceitar uploads de arquivos de áudio diretamente no aplicativo para Android. Embora a função ainda esteja em desenvolvimento e não completamente funcional, a novidade abre portas para usos poderosos — desde transcrever reuniões até analisar músicas e auxiliar na acessibilidade.

Com a rápida evolução das IAs multimodais, que conseguem entender texto, imagem, áudio e vídeo, integrar a análise de áudio é um passo natural rumo a um assistente verdadeiramente completo. Neste artigo, você vai entender o que foi descoberto, por que isso é relevante, e o que podemos esperar nos próximos meses com a chegada dessa tecnologia ao seu smartphone.

O que foi descoberto: o upload de áudio chega ao Gemini

Sinais no código e a interface preliminar

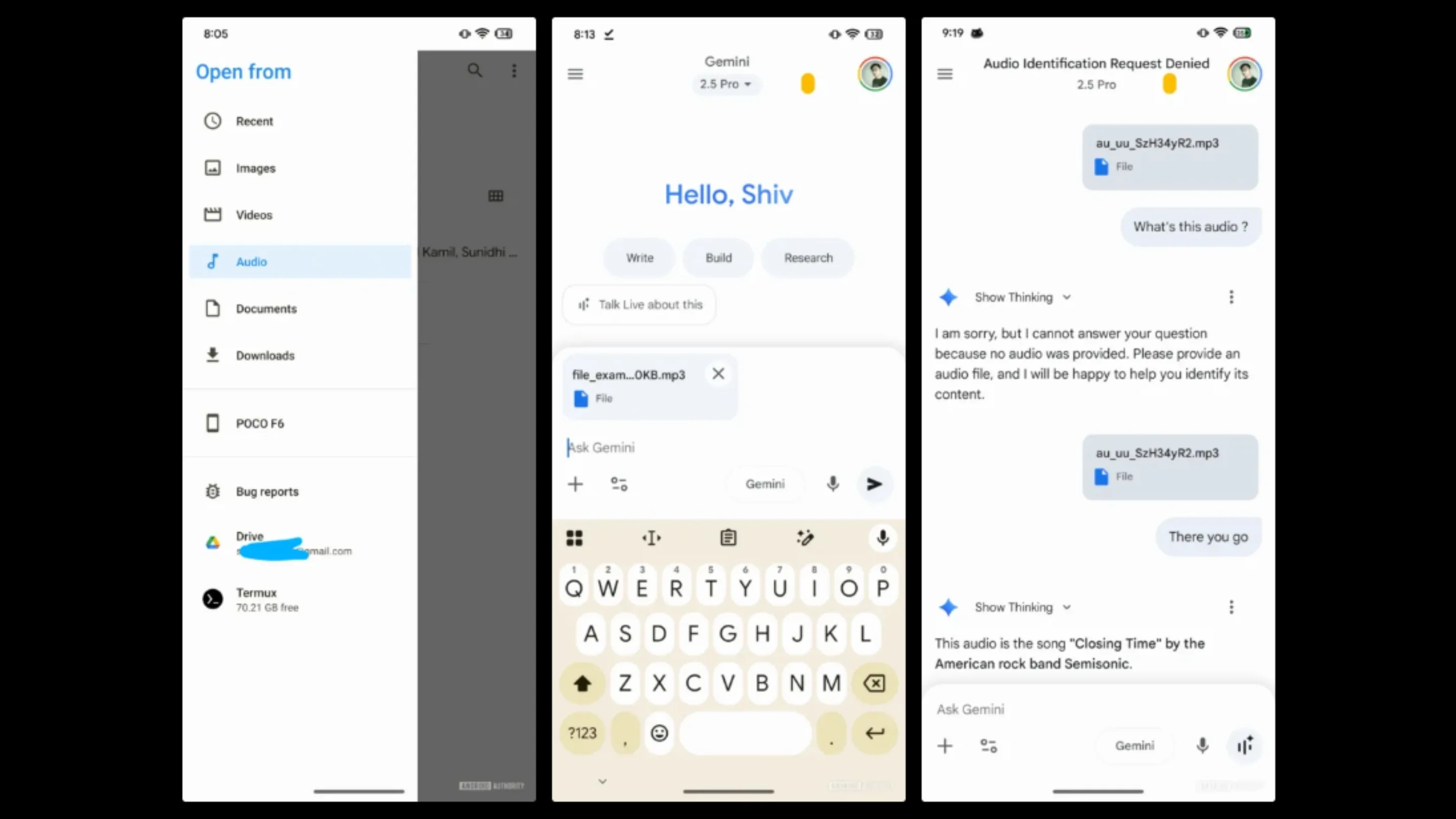

A descoberta veio de uma análise detalhada da versão beta do aplicativo Google para Android (v16.30.59.sa.arm64), feita pelo especialista AssembleDebug, conhecido por suas explorações em APKs. Ao ativar funcionalidades ocultas nessa versão, uma nova opção de upload de áudio foi identificada dentro da interface do Gemini.

Especificamente, um novo botão de anexar arquivos aparece com a sugestiva frase: “Fale ao vivo sobre isso”, indicando a intenção de permitir que o usuário envie um áudio e interaja com a IA sobre seu conteúdo.

Essa interface ainda é simples, mas já mostra os primeiros passos de uma integração que pode mudar a forma como interagimos com assistentes virtuais.

Um recurso em desenvolvimento: o que ainda não funciona

Apesar da animação, é importante destacar: a função ainda não está operacional. Nos testes realizados, o Gemini ignora o áudio enviado ou responde com informações irrelevantes — fenômeno conhecido como alucinação de IA.

Isso indica que, embora o botão e a interface estejam presentes, o backend ainda não foi plenamente ativado ou integrado. Em outras palavras, a função está visível, mas os mecanismos que a fazem funcionar ainda estão sendo ajustados.

Por que isso é importante: o poder da IA multimodal no seu bolso

A chegada do upload de áudio ao Gemini Android representa um avanço significativo no conceito de IA multimodal — sistemas capazes de processar diversos tipos de entrada, como texto, imagens e sons. Essa abordagem torna os assistentes muito mais flexíveis e úteis em situações do dia a dia.

A base técnica já existe: a API do Gemini já sabe ouvir

Vale lembrar que, mesmo que essa função esteja estreando no app, a tecnologia por trás dela já está madura. A API do Gemini, voltada para desenvolvedores, já suporta entrada de áudio em formatos como MP3, WAV e FLAC.

Essa API já permite transcrição, geração de resumos e até análise semântica de conteúdo falado. Isso significa que o Google já domina essa capacidade — a limitação atual é apenas a integração com a interface do Android. A função chegar ao app é, portanto, apenas uma questão de tempo.

Casos de uso práticos: do estudante ao profissional

Quando estiver totalmente funcional, essa ferramenta poderá ser revolucionária para diferentes perfis de usuários:

- Estudantes: poderão enviar uma gravação de aula e pedir um resumo, economizando horas de revisão.

- Jornalistas: terão um recurso de transcrição automática para entrevistas, com possibilidade de gerar insights ou pautas automaticamente.

- Músicos: poderão usar o Gemini Android áudio para descrever trechos musicais, identificar estilos ou sugerir acordes complementares.

- Criadores de conteúdo: poderão transformar brainstormings gravados em roteiros organizados com poucos toques.

- Pessoas com deficiência auditiva: terão mais uma forma de acessibilidade, com transcrições rápidas e confiáveis de mensagens de voz ou áudios recebidos.

O que esperar a seguir e a visão do Google

Com o suporte a imagens já presente no Gemini Android, a inclusão de áudio consolida ainda mais o assistente como uma IA multimodal completa. Isso o coloca em posição de destaque em relação a concorrentes como o ChatGPT no Android e outros serviços do setor.

No entanto, é essencial lembrar que essa descoberta veio por meio de um APK Teardown, o que significa que não há confirmação oficial de lançamento. O Google pode alterar, adiar ou até cancelar o recurso antes que ele chegue ao público final.

Ainda assim, considerando o histórico da empresa e o investimento crescente em inteligência artificial, é plausível supor que essa funcionalidade será lançada nos próximos ciclos de atualização.

Conclusão: a próxima fronteira da interação com a IA

A descoberta da função de upload e análise de áudio no Gemini Android marca um novo capítulo na evolução dos assistentes virtuais. Essa não é apenas uma adição de conveniência — é uma mudança estrutural na forma como interagimos com a tecnologia.

Ao permitir que o Gemini “ouça” e compreenda sons, o Google coloca um superassistente multimodal literalmente no seu bolso. Ainda não está pronto, mas o caminho está claramente traçado.

E você, o que achou dessa novidade? Para quais tarefas você usaria a análise de áudio do Gemini? Deixe sua opinião nos comentários!