O Google anunciou oficialmente o Programa de Recompensa de Vulnerabilidade de IA (IA VRP), uma iniciativa inédita que promete pagar até US$ 30.000 (≈ R$ 160.800,00) para quem encontrar falhas de segurança em seus sistemas de inteligência artificial. O movimento marca um passo importante na proteção de tecnologias como o Gemini e reforça o compromisso da empresa com a cibersegurança em tempos de avanços acelerados da IA.

Neste artigo, vamos destrinchar como funciona o novo programa de recompensas, quais produtos estão inclusos, que tipo de falhas são elegíveis, e por que esta iniciativa representa um marco para a segurança digital. Também vamos discutir como desenvolvedores e pesquisadores podem participar e o que isso sugere sobre o futuro da segurança em IA.

Com o crescimento explosivo de sistemas baseados em aprendizado de máquina — como chatbots, assistentes virtuais e ferramentas generativas — cresce também o número de ataques voltados à manipulação desses modelos. O novo programa do Google surge em um momento estratégico: proteger a integridade e confiabilidade das respostas de IA é mais crucial do que nunca.

O que é o novo programa de recompensas de vulnerabilidade de IA do Google?

O IA VRP (AI Vulnerability Reward Program) é um programa de bug bounty dedicado para falhas de segurança relacionadas à inteligência artificial. Diferente de programas tradicionais do Google que visam vulnerabilidades em software puro, este se concentra em riscos específicos de IA, como manipulação de prompts, vazamentos de informação de modelos e comportamento indevido gerado por IA.

Entre os produtos que fazem parte do escopo estão:

- Pesquisa Google, com foco nas respostas melhoradas por IA

- Gemini Apps, nas versões Web, Android e iOS

- Google Workspace, incluindo Gmail, Drive, Docs e Sheets

- Outros serviços integrados à infraestrutura de IA generativa do Google

Esses produtos são amplamente usados por milhões de pessoas, o que amplia o potencial de impacto caso haja alguma vulnerabilidade. Por meio do IA VRP, o Google pretende estreitar o laço com a comunidade de pesquisa em segurança, protegendo simultaneamente usuários e ativos sensíveis.

Desvendando as recompensas: quanto vale uma falha de IA?

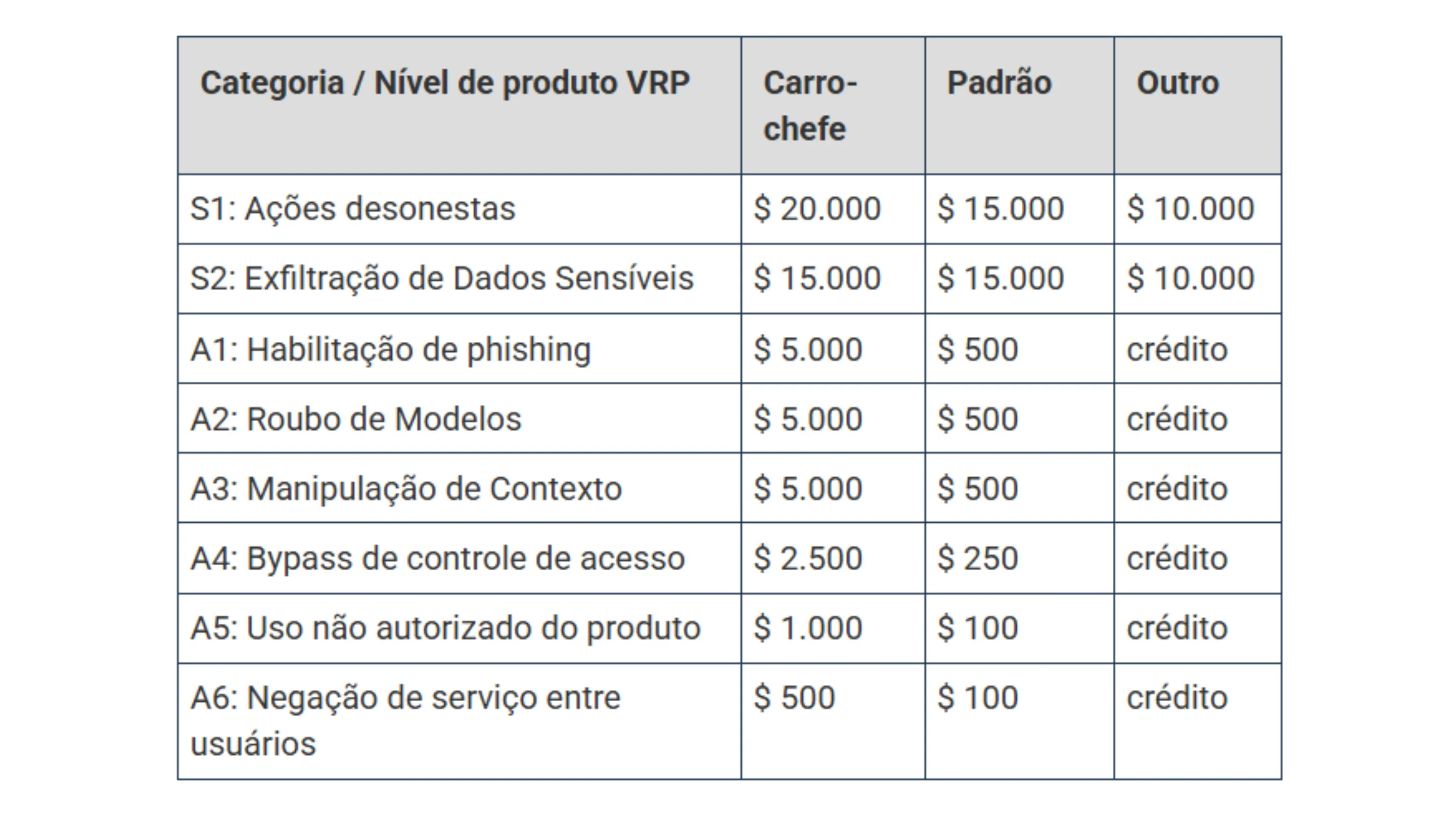

As recompensas em dólares variam segundo a gravidade e o impacto da falha identificada. Aqui estão os valores convertidos para reais com base na taxa ~ R$ 5,36 por US$ 1:

Ações desonestas e exfiltração de dados: as falhas mais críticas

As falhas mais graves envolvem cenários em que a IA é forçada a revelar dados confidenciais ou executar comandos não autorizados. Exemplos incluem vazamentos de dados de usuários, prompt injection para burlar restrições, ou acesso não autorizado a dados de treinamento.

- Recompensas de até US$ 20.000 (≈ R$ 107.200,00)

- Em casos excepcionais de alto impacto, o valor pode chegar a US$ 30.000 (≈ R$ 160.800,00)

Roubo de modelos e phishing: protegendo propriedade intelectual e usuários

Outra categoria coberta é o roubo de modelos (model theft), quando alguém consegue copiar ou replicar o comportamento de um modelo proprietário. Essa ameaça compromete a propriedade intelectual do Google, já que modelos são resultado de enormes investimentos.

Além disso, o programa recompensa com até US$ 5.000 (≈ R$ 26.800,00) falhas que permitam ataques de phishing aprimorados por IA, onde o modelo é induzido a gerar conteúdo malicioso convincente. Tais ataques são especialmente perigosos em ambientes corporativos ou em massa.

Por que um programa de bug bounty específico para IA é tão importante?

A criação do IA VRP evidencia uma mudança no paradigma de segurança. Vulnerabilidades em sistemas de IA são essencialmente diferentes das falhas de software tradicionais, pois envolvem comportamentos emergentes, interpretação de linguagem natural e dependência de grandes volumes de dados.

Além do código: os novos vetores de ataque em IA

Diferente de falhas clássicas como buffer overflow ou SQL injection, vulnerabilidades em IA muitas vezes residem em como o modelo interpreta e responde a comandos. Alguns vetores de ataque relevantes:

- Prompt injection: inserir instruções maliciosas ocultas que o modelo executa

- Data poisoning: contaminar os dados de treinamento para distorcer o comportamento do modelo

- Context manipulation: manipular o contexto da entrada para induzir respostas erradas ou revelar dados sensíveis

Esses vetores exigem atuação além do escopo puramente de código — é preciso entender como o modelo “pensa” e como ele responde a estímulos sutis.

Um sinal para o mercado: a maturidade da segurança em IA

Ao lançar um programa específico para falhas de IA, o Google envia um sinal claro ao mercado: segurança de IA já é um pilar estratégico. Esse tipo de iniciativa pode incentivar outras grandes empresas — como Microsoft, OpenAI, Anthropic — a também abrirem seus próprios programas de recompensa para IA, elevando o nível geral de proteção no setor.

Além disso, o IA VRP demonstra que o modelo ideal de defesa inclui colaboração pública: pesquisadores externos atuam como olheiros, ajudando a fortalecer sistemas que nenhuma empresa poderia proteger sozinha.

Como participar e o futuro da segurança em IA

Qualquer pesquisador interessado pode submeter uma vulnerabilidade pelo portal do Google VRP, desde que respeite as diretrizes definidas para falhas de IA. Para ter chance de receber recompensas, é importante que o relatório seja técnico, com prova de conceito, impacto claramente demonstrado e replicável.

Relatórios mais completos, bem documentados e com demonstrações convincentes tendem a alcançar recompensas maiores. O Google valoriza ética e responsabilidade, exigindo que os testes não comprometam sistemas reais ou dados de usuários.

Mais do que um estímulo financeiro, esse programa abre caminho para pesquisadores se especializarem em segurança de IA — uma área com enorme demanda futura. À medida que o Gemini e outros modelos se popularizam, surgem mais oportunidades para profissionais capazes de identificar e mitigar riscos emergentes.

Conclusão: um investimento necessário na era da inteligência artificial

O Programa de Recompensas de Vulnerabilidade de IA do Google representa mais do que um simples bug bounty — é um marco na evolução da segurança digital frente à era da IA. Ele reconhece que os riscos associados a modelos inteligentes são únicos e exigem estratégias novas e colaborativas.

Ao investir até US$ 30.000 (≈ R$ 160.800,00) por falha, o Google não só recompensa pesquisadores, mas fomenta uma cultura de cooperação global para tornar a IA mais confiável, ética e segura.

A segurança em IA é um campo fascinante e em plena expansão. O que você acha da iniciativa do Google com esses valores convertidos? Deixe seu comentário abaixo e compartilhe sua visão sobre como podemos tornar o universo da IA mais seguro e responsável.