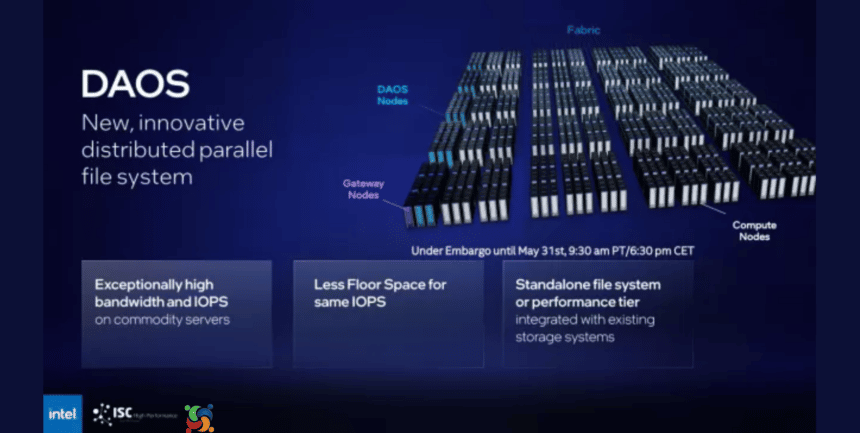

No início deste ano, a Intel anunciou formalmente o DAOS. Trata-se de um sistema de arquivos paralelo distribuído projetado para armazenamento NVMe e visa ser mais eficiente do que outros sistemas de arquivos paralelos. Agora, houve o lançamento do DAOS 2.2 como o mais novo passo para o Distributed Application Object Storage. Assim, a Intel lança sistema DAOS de armazenamento mais aprimorado voltado para supercomputadores.

O sistema de arquivos paralelo distribuído DAOS é projetado principalmente para atender às necessidades dos modernos sistemas de HPC/supercomputadores. O DAOS foi originalmente iniciado enquanto a Intel estava no negócio de armazenamento com o Optane, enquanto pelo menos por enquanto seus engenheiros de código aberto continuam trabalhando no DAOS.

Intel lança sistema de armazenamento para supercomputadores

Agra, eles lançaram o DAOS 2.2 como o mais novo lançamento estável. Os interessados no código-fonte ou nas compilações de pacotes podem encontrá-los no GitHub.

Então, o DAOS 2.2 adiciona suporte para Rocky Linux 8 e AlmaLinux 8, suporte UCX é adicionado como uma prévia de tecnologia, suporte para o provedor libfabric/tcp é adicionado, várias melhorias de usabilidade e muitas correções de bugs. Mais detalhes sobre as alterações do DAOS 2.2 ou informações sobre este projeto de sistema de arquivos distribuído de código aberto em geral podem ser encontrados em DAOS.io.

Intel lança driver GNA revisado para co-processador neural AI

A Intel e todo o resto da indústria de tecnologia continua investindo imensos recursos em áreas em torno da IA. Falando sobre isso, um dos esforços que demorou a se materializar em relação ao Linux foi habilitar seu Gaussian and Neural Accelerator (GNA) com o kernel Linux principal.

Esta semana, os últimos patches do driver Intel GNA foram publicados para este coprocessador neural.O co-processador Intel Gaussian and Neural Accelerator (GNA) existe desde o malfeito Cannon Lake e continua a ser encontrado nos mais recentes processadores Intel Core, além de ser encontrado em vários processadores Pentium (Gemini Lake/Elkhart Lake), além do Intel Speech Enabling Developer Kit e o Amazon Alexa Premium Far-Field Developer Kit.

O coprocessador GNA destina-se a atividades de inferência contínuas, como redução de ruído, reconhecimento de fala e tarefas semelhantes para liberar recursos da CPU.

Voltando a fevereiro de 2021, os engenheiros da Intel começaram a trabalhar no upstream de seu driver GNA. Na maior parte dos dois anos desde então, eles estão agora na quarta versão do driver enquanto trabalham para, eventualmente, colocá-lo no kernel principal.

O driver Linux Intel GNA v4 publicado na quinta-feira foi adaptado para fazer uso da estrutura Direct Rendering Manager (DRM) do kernel. A biblioteca GNA do espaço do usuário também foi adaptada a essa mudança para vincular o driver AI ao subsistema do kernel DRM.

Isso tem sido algo procurado pelos mantenedores de DRM com muitos aceleradores de IA que se encaixam perfeitamente no subsistema de GPU DRM e sua semântica.Além disso, os patches v4 agora foram testados no kernel Linux 6.0, várias correções e itens levantados durante a revisão anterior foram abordados e outras atualizações.

É tarde demais para chegar em 2022 com o kernel 6.1, mas veremos se o driver Intel GNA está finalmente pronto para a linha principal em 2023. Os patches intel_gna v4 estão para revisão agora na lista de discussão do kernel.

A biblioteca de espaço do usuário GNA é de código aberto para fazer uso desse coprocessador neural e o software do kit de ferramentas de aprendizado profundo OpenVINO da Intel é um exemplo de software de espaço do usuário pronto para usar o GNA quando ativado no Linux. Apenas na semana passada marcou o lançamento v3.0 da biblioteca de espaço de usuário Intel GNA.