A Inteligência Artificial (IA) continua a romper barreiras, e a mais recente inovação chega da Kuaishou (快手), gigante chinesa de vídeos curtos. O Kwai Keye-VL-8B é o mais novo Modelo de Linguagem Grande Multimodal (LLM) desenvolvido pela empresa, e já está disponível como código aberto no GitHub. Este modelo redefine a forma como a IA interage com o mundo, sendo capaz de integrar e processar texto, imagem e vídeo, oferecendo uma experiência multimodal sem precedentes.

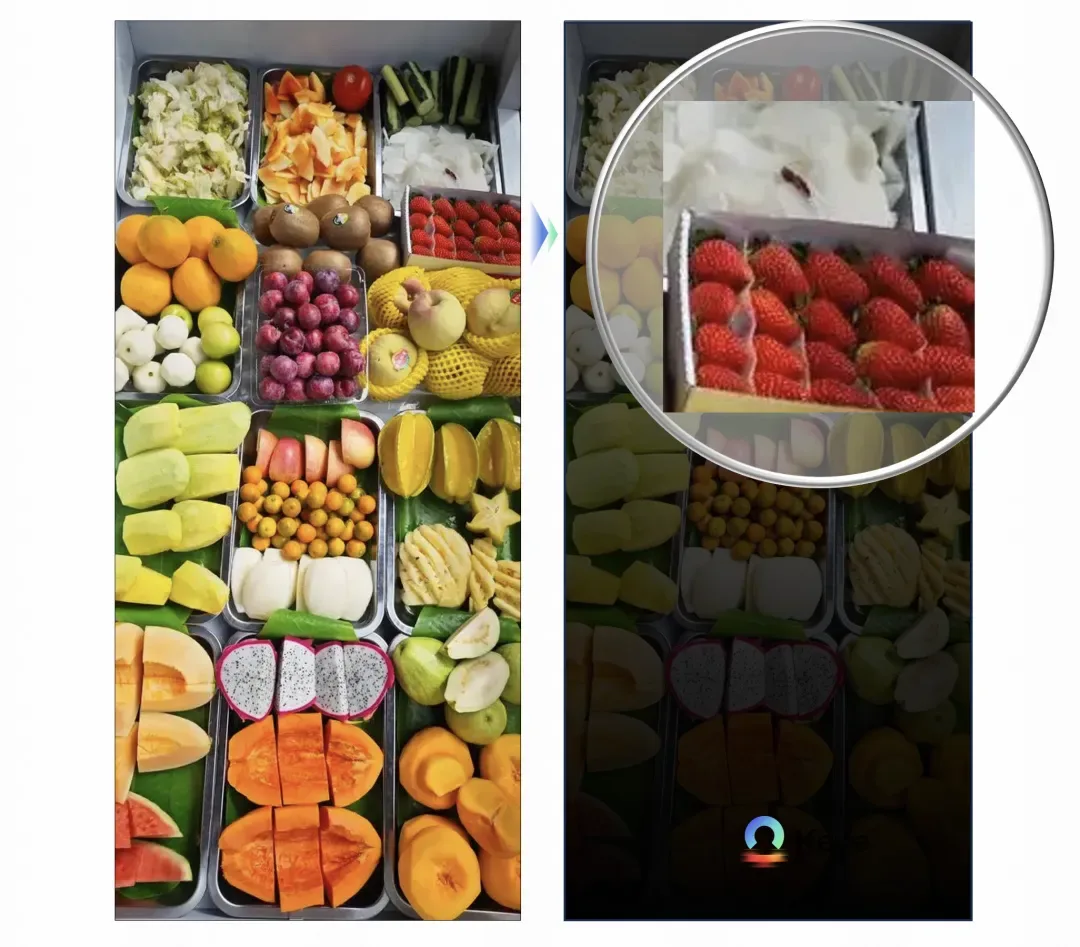

O Kwai Keye-VL se destaca não apenas por sua capacidade de análise visual detalhada – como contar o número exato de frutas em uma imagem complexa em segundos – mas também por sua notável capacidade de raciocínio lógico. Um exemplo impressionante de seu poder é a pontuação de 140 pontos no exame nacional de matemática do高考 de 2025, demonstrando habilidades de resolução de problemas complexos que rivalizam com os modelos de ponta de sua escala.

Baseado no LLM Qwen3-8B e incorporando um VisionEncoder com inicialização SigLIP, o Kwai Keye-VL utiliza uma arquitetura inovadora com 3D RoPE (Rotação de Posicionamento de Embedding) para unificar o tratamento de dados textuais, visuais e temporais. Este artigo fará um mergulho aprofundado nas tecnologias de ponta que impulsionam o Kwai Keye-VL, desde seu pré e pós-treinamento até suas otimizações de arquitetura e impressionantes resultados de avaliação.

Arquitetura técnica: a base multimodal do Kwai Keye-VL

O Kwai Keye-VL é construído sobre um alicerce técnico robusto e inovador, projetado para lidar com a complexidade dos dados multimodais e oferecer capacidades de raciocínio avançadas.

Qwen3-8B e VisionEncoder SigLIP: os pilares do modelo

O Kwai Keye-VL utiliza o Modelo de Linguagem Qwen3-8B como sua base textual. Para integrar as informações visuais, ele incorpora um VisionEncoder (codificador de visão) inicializado a partir do SigLIP, uma técnica que otimiza a representação visual para modelos de IA.

Essa combinação permite ao Kwai Keye-VL não apenas processar e fundir profundamente texto, imagem e vídeo, mas também se adaptar de forma inteligente. Ele possui um mecanismo de interação adaptativo e capacidade de inferência dinâmica, que são cruciais para oferecer uma experiência multimodal mais inteligente e abrangente.

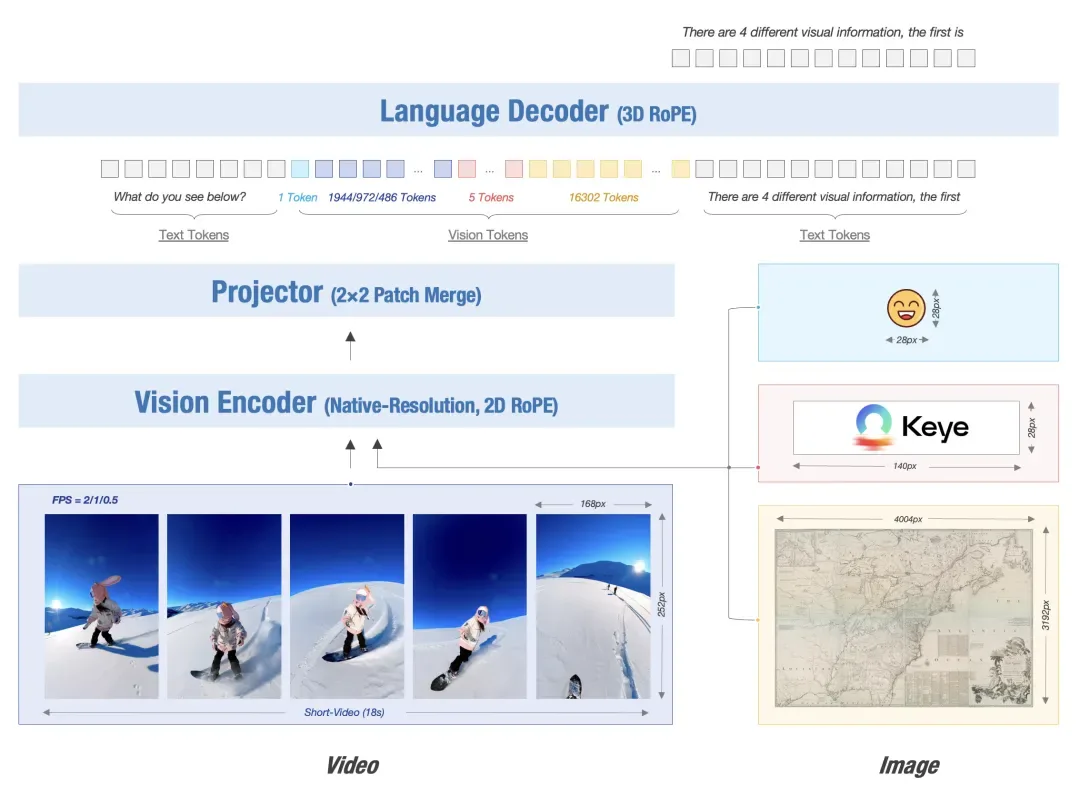

Processamento de entrada de resolução dinâmica e 3D RoPE

O Kwai Keye-VL suporta entrada de resolução dinâmica para imagens. Ele segmenta a imagem original em uma sequência de patches de 14×14 pixels, que são então mapeados e mesclados por uma camada MLP (Multilayer Perceptron) para formar visual tokens.

Para unificar o processamento de texto, imagem e vídeo, o modelo emprega o 3D RoPE (Rotary Position Embedding). O 3D RoPE é uma técnica avançada de codificação de posição que permite ao modelo capturar mudanças temporais precisas em vídeos, alinhando as posições dos tokens com os timestamps do vídeo.

Pre-Train: construindo as capacidades multimodais de base

A fase de pré-treinamento do Kwai Keye-VL é fundamental para estabelecer suas habilidades de compreensão visual e linguística.

Objetivo principal e dados de treinamento massivos

O objetivo central desta etapa é construir capacidades robustas de compreensão de imagem-texto e vídeo (o que se conhece como alinhamento visual-linguagem). Para isso, o modelo foi treinado com um enorme volume de dados multimodais: 600 bilhões de tokens, compreendendo dados de imagem-texto, vídeo e texto puro.

Superando limitações de dados abertos

Para resolver as limitações de dados de código aberto (como poluição de dados, cobertura linguística restrita e tarefas simplificadas), a Kuaishou desenvolveu seu próprio sistema OCR (Optical Character Recognition) chinês de alta qualidade e realizou uma descrição refinada dos dados. Esse esforço foi dedicado especificamente ao treinamento das capacidades de compreensão de imagem-texto e vídeo do modelo.

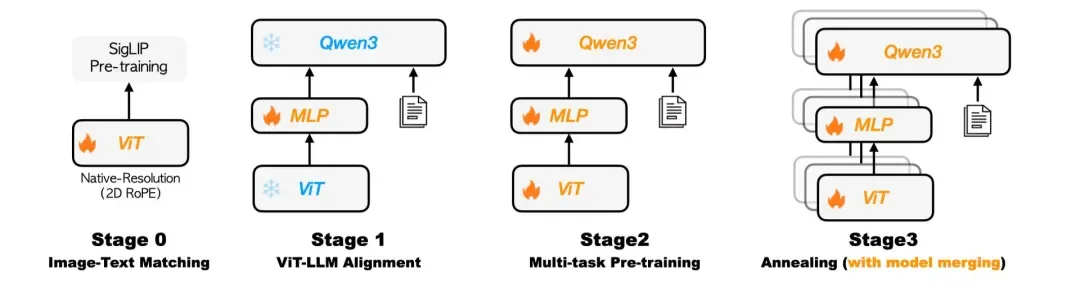

Estratégia de otimização em quatro fases

O processo de pré-treinamento do Kwai Keye-VL seguiu uma estratégia de otimização progressiva em quatro fases:

- Pré-treinamento visual: Continuação do pré-treinamento do codificador visual para adaptá-lo à distribuição interna de dados e habilitar a entrada de resolução dinâmica.

- Alinhamento intermodal: Nesta fase, o modelo principal é congelado, e apenas um adaptador MLP leve é treinado. Isso estabelece de forma eficiente e de baixíssimo custo uma relação robusta de alinhamento entre imagens/vídeos e textos.

- Pré-treinamento multi-tarefa: Todos os parâmetros do modelo são descongelados (

unlocked) e o treinamento conjunto em múltiplas tarefas é realizado para aprimorar holisticamente a capacidade de compreensão visual do modelo. - Treinamento por recozimento (annealing training): Utiliza um conjunto de dados de alta qualidade selecionados para fine-tuning, aprimorando ainda mais a capacidade de compreensão e discriminação fina do modelo.

Fusão homogênea heterogênea: robustez do modelo

Finalmente, o Kwai Keye-VL explorou a tecnologia de fusão homogênea heterogênea (同构异质融合技术). Esta técnica combina modelos de treinamento por recozimento com diferentes proporções de dados através de média de parâmetros. Isso ajuda a reduzir o viés do modelo e aumentar sua robustez, ao mesmo tempo em que preserva suas capacidades multidimensionais.

Post-Train: fortalecendo a capacidade de raciocínio lógico

A fase de pós-treinamento do Kwai Keye-VL foi meticulosamente projetada para maximizar o desempenho do modelo, com ênfase especial em sua capacidade de raciocínio em tarefas complexas. Essa etapa é o diferencial que permite ao modelo realizar funções cognitivas avançadas.

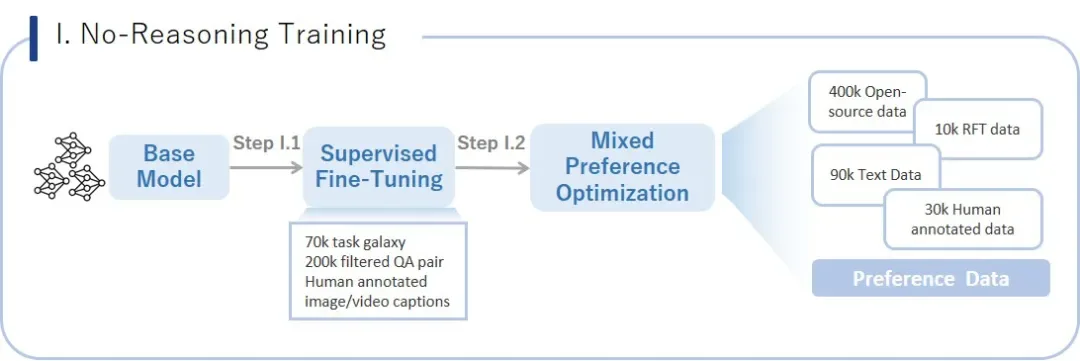

Estágio I. Treinamento sem raciocínio (No-Reasoning Training): consolidando a base

O Kwai Keye-VL primeiro passa por um ajuste fino supervisionado (SFT – Supervised Fine-tuning). Para isso, utiliza 5 milhões de dados VQA (Visual Question Answering) multimodais de alta qualidade. A diversidade desses dados é garantida por uma estrutura de tarefas auto-desenvolvida (TaskGalaxy) contendo 70.000 tipos de tarefas, e a qualidade dos dados é assegurada por filtragem de amostras difíceis por IA e anotação humana.

Em seguida, o modelo é submetido à Otimização de Preferência Mista (MPO – Mixed Preference Optimization). Esta etapa combina dados de código aberto com dados de preferência auto-construídos, que são gerados a partir de amostras de erros do SFT e classificados manualmente para otimizar as preferências do modelo.

Estágio II. Treinamento de raciocínio (Reasoning Training): aprimoramento cognitivo central

Este estágio é o ponto alto e a principal contribuição do processo de treinamento do Kwai Keye-VL. Ele integra Mecanismos de Raciocínio de Cadeia de Pensamento (CoT – Chain-of-Thought) em modo misto (Mix-mode) e Aprendizado por Reforço (RL – Reinforcement Learning) com múltiplos modos de pensamento, elevando drasticamente as capacidades de percepção multimodal, raciocínio e “pensar com imagem” (think with image). Isso permite ao modelo lidar com tarefas mais complexas que exigem múltiplos passos de raciocínio.

As etapas detalhadas são:

- Etapa 1: Fase de ‘cold-start’ da Cadeia de Pensamento (CoT Cold-Start): O modelo é ativado para a capacidade de CoT a partir do zero. Isso é feito usando uma combinação de quatro modos de dados de raciocínio: dados sem raciocínio, dados de raciocínio, dados de raciocínio automático e dados de raciocínio agêntico (agentic). O objetivo é fazer com que o modelo comece a dominar o paradigma de raciocínio passo a passo, como um humano.

- Etapa 2: Fase de Aprendizado por Reforço Misto (CoT-Mix RL): Com base no cold-start, o algoritmo GRPO é empregado para o aprendizado por reforço em modo misto. Isso envolve um inovador mecanismo de recompensa de pista dupla, que avalia simultaneamente a correção do resultado e a consistência do processo. Isso otimiza profundamente as capacidades de percepção multimodal, raciocínio matemático, compreensão de vídeos curtos e colaboração de agentes (

agentic collaboration), resultando em um aumento significativo na capacidade de raciocínio do modelo. - Etapa 3: Fase de Alinhamento Iterativo (Iterative Alignment): Utiliza o algoritmo MPO para realizar múltiplas rodadas de iteração de alinhamento com pares de dados “bons/ruins”. Isso serve para resolver problemas de repetição de conteúdo e falhas lógicas, e, em última análise, capacita o modelo com uma capacidade adaptativa de escolher inteligentemente o modo de raciocínio profundo com base na complexidade da pergunta, alcançando um avanço duplo em desempenho e estabilidade.

Através dessas estratégias de pré-treinamento e pós-treinamento em fases e refinadas, com um aprofundamento e inovação nas capacidades de raciocínio, o Kwai Keye-VL garante saídas de alta qualidade, logicamente rigorosas e estáveis em uma variedade de cenários complexos.

Otimização da arquitetura de treinamento: escalabilidade e estabilidade

Para treinar um modelo de bilhões de parâmetros de forma eficiente e estável, o Kwai Keye-VL implementou otimizações cruciais em sua arquitetura de treinamento.

Estratégias de paralelismo misto

O Kwai Keye-VL alcança uma melhora significativa no throughput de treinamento através de uma estratégia de paralelismo misto. Isso integra:

- Paralelismo de dados: dividir o lote de dados entre várias GPUs.

- Paralelismo de sequência: dividir sequências longas entre GPUs.

- Tecnologia ZeRO: otimização de memória que divide o estado do otimizador, gradientes e parâmetros do modelo entre os dispositivos.

Essa combinação não só reduz a pressão sobre a memória da GPU através do sharding, mas também oculta a latência através da sobreposição de computação e comunicação.

Estratégia global de balanceamento de carga para multimodais

Diferentemente do treinamento de modelos puramente textuais, os inputs multimodais (imagem, vídeo) têm resoluções muito variadas, resultando em cargas de computação desiguais nas diferentes GPUs e, consequentemente, em baixa utilização geral.

Para resolver isso, o Kwai Keye-VL implementou uma estratégia global de balanceamento de carga na estrutura de treinamento. Ela distribui dinamicamente as amostras com base nos FLOPS (Floating-point Operations Per Second). Isso ajuda a eliminar o tempo ocioso do hardware e melhora significativamente a MFU (Model FLOPs Utilization) para o treinamento multimodal.

Mecanismo de tolerância a falhas e aceleração de amostragem

O sistema construiu um mecanismo de tolerância a falhas automático em nível de amostra. Utilizando tecnologia de checkpoint conjunto, o treinamento pode ser retomado de forma precisa e automática após interrupções inesperadas, garantindo a estabilidade da iteração do modelo.

Na fase de pós-treinamento, o framework vLLM foi atualizado para acelerar a amostragem. Além disso, uma estratégia de distribuição aleatória de múltiplos modelos de recompensa foi implantada, o que reduz drasticamente o tempo de computação no aprendizado por reforço. Essas otimizações sistêmicas garantem a estabilidade e eficiência do treinamento em larga escala.

Avaliação do modelo: desempenho de ponta em compreensão e raciocínio

As avaliações do Kwai Keye-VL demonstram seu desempenho superior em diversas frentes, especialmente em tarefas de raciocínio.

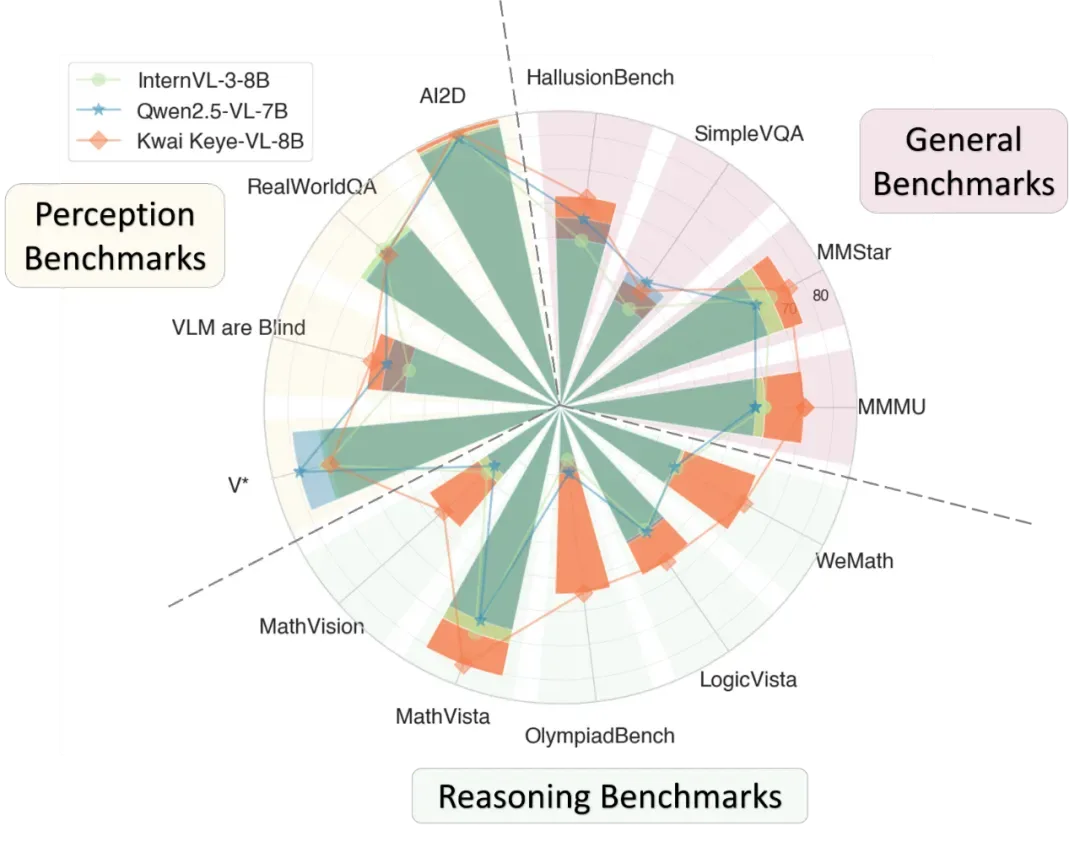

Benchmark de compreensão visual e raciocínio lógico

O Kwai Keye-VL alcança capacidades de percepção abrangentes que rivalizam com os modelos de ponta de sua escala, e demonstra uma vantagem líder significativa em tarefas de raciocínio complexo.

Dados de avaliação mostram:

- Percepção básica: nível de primeira classe na indústria.

- Benchmarks gerais (MMMU, MMStar): o modelo lidera significativamente as curvas de desempenho em comparação com o setor.

- Benchmarks de raciocínio (MathVista, OlympiadBench): o Kwai Keye-VL se destaca ainda mais, especialmente em tarefas desafiadoras que exigem raciocínio lógico de alto nível e resolução de problemas matemáticos. Isso ressalta sua capacidade excepcional de resolver problemas complexos.

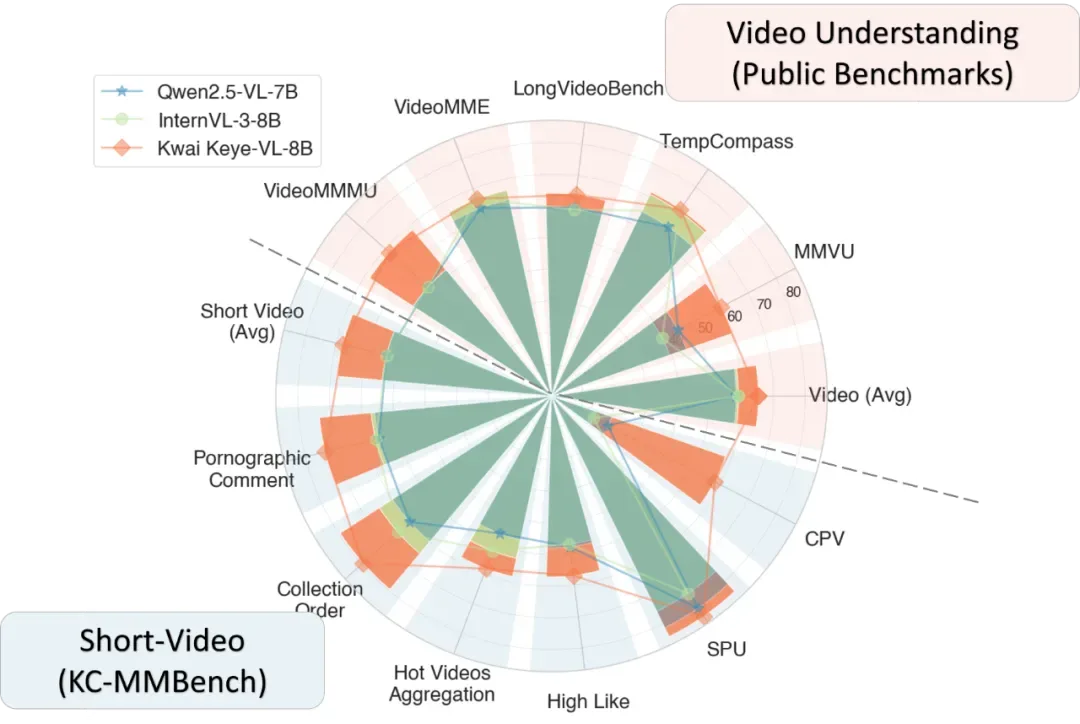

Benchmark de compreensão de vídeo

O Kwai Keye-VL demonstrou vantagens abrangentes e líderes em compreensão de vídeo, verificadas tanto por avaliações públicas quanto por conjuntos de dados internos.

Para superar problemas como contaminação de dados em conjuntos de dados públicos, limitações de cobertura linguística e tarefas de natureza singular, a Kuaishou desenvolveu seu próprio conjunto de avaliação interno: KC-MMBench.

Os resultados são impressionantes:

- Benchmarks públicos (VideoMME): o modelo alcançou 67.4 pontos, superando o Qwen2.5-VL-7B (62.7) e o InternVL-3-8B (65.5).

- Cenários internos de vídeo curto: a vantagem do modelo é ainda maior nas avaliações de cenários internos de vídeo curto, com uma pontuação abrangente mais de 10% superior aos modelos SOTA (State-Of-The-Art).

- Destaques em cenários chave: demonstrou desempenho excepcional em cenários centrais como agregação de hotspots (

热点聚合), coleções de conteúdo (内容合集) e valor de publicidade (广告价值). Isso prova sua competitividade tanto acadêmica quanto industrial.

Casos de aplicação: o Kwai Keye-VL na prática

Em testes reais, o Kwai Keye-VL mostrou capacidades impressionantes de compreensão de conteúdo e criação em várias modalidades.

Exemplos práticos

- Marketing e vendas: O modelo pode gerar um plano de marketing detalhado para um produto mostrado em um vídeo, transformando conteúdo visual em estratégias acionáveis.

- Criação de conteúdo e arte: A partir de uma imagem, o Kwai Keye-VL pode criar poesias, demonstrando sua capacidade de gerar conteúdo criativo e contextual.

- Visão computacional complexa: Como demonstrado no exemplo inicial de contar frutas em uma imagem complexa.

Futuro e perspectivas: o papel do Kwai Keye-VL na era do vídeo com IA

Com a profunda experiência tecnológica da Kuaishou no domínio de vídeos curtos, o Kwai Keye-VL possui uma vantagem única na compreensão de vídeo. O lançamento e a abertura do código deste modelo representam um passo sólido na exploração de uma nova era de compreensão de vídeo para modelos de linguagem grandes multimodais.

A equipe de modelos multimodais da Kuaishou busca talentos! Se você se identifica com a missão de impulsionar a evolução da plataforma através da tecnologia e quer usar a IA para entender usuários e conteúdo, explore as vagas de especialista em algoritmos, engenheiro de IA/AIGC e engenheiro de visão computacional. Acesse os links fornecidos para o projeto e contribua.