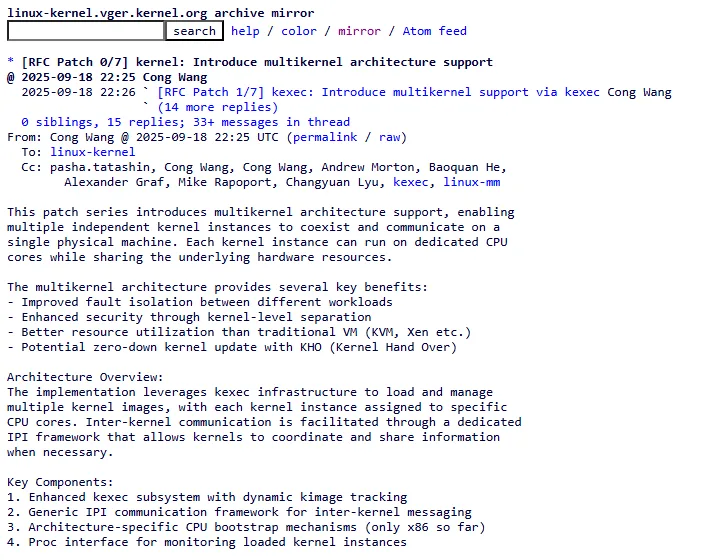

Uma nova e ambiciosa proposta está circulando entre os desenvolvedores do Kernel Linux, e ela pode mudar fundamentalmente como o sistema operacional utiliza hardware multi-core. Uma série de patches RFC (Request for Comments) introduz o suporte a uma arquitetura multikernel, que permitiria particionar um sistema para rodar um ou mais kernels secundários e isolados ao lado do kernel Linux principal.

Além da virtualização e dos contêineres: o modelo ‘multikernel’

Imagine um grande navio (o hardware) com um único capitão e tripulação (o kernel Linux) gerenciando tudo. A arquitetura multikernel é como dividir esse navio em seções estanques, cada uma com sua própria tripulação especializada e independente, compartilhando o mesmo casco. Uma seção pode ser dedicada a tarefas de tempo real ultrarrápidas, enquanto outra executa um sistema operacional de segurança crítica, e a seção principal continua rodando o Linux de propósito geral — tudo sem a necessidade de construir “botes salva-vidas” separados e pesados (as máquinas virtuais).

Em vez de camadas de hypervisor (como KVM ou Xen) ou de sobrecarga de isolamento de contêiner (namespaces e cgroups), o multikernel propõe uma fronteira intermediária: múltiplos kernels nativos, cada um controlando um conjunto dedicado de CPU cores.

Casos de uso e benefícios

O autor da proposta, Cong Wang, lista benefícios claros e pragmáticos:

- Isolamento de falhas aprimorado: se um kernel secundário travar, o principal segue funcionando sem interrupções.

- Segurança reforçada pela separação em nível de kernel, reduzindo a superfície de ataque.

- Desempenho de tempo real garantido: alocar um kernel especificamente para RTOS (Real-Time Operating System) elimina interferência de processos genéricos.

- Atualizações sem downtime por meio do mecanismo KHO (Kernel Hand Over), permitindo substituir o kernel principal ou secundário sem reiniciar o hardware.

- Melhor utilização de recursos em comparação à virtualização tradicional, evitando duplicação de pilhas de I/O e memória.

Esses ganhos colocam o multikernel como uma opção atraente para ambientes de telecomunicações, aeroespacial, automotivo e datacenters críticos, onde latência e disponibilidade são absolutas prioridades.

Como funciona: kexec e IPIs

Na base da implementação está o kexec, o mecanismo que carrega e inicia uma nova imagem de kernel diretamente sem passar pelo firmware. O fluxo de trabalho simplificado é:

- Particionamento de cores

No boot inicial, o kernel principal reserva grupos de CPU cores para kernels secundários. Por exemplo, cores 0–3 para o kernel principal e 4–7 para um kernel RTOS. - Carregamento com kexec

Cada imagem de kernel secundário é carregada em memória usando kexec. Isso evita o reboot completo e encapsula o kernel secundário na mesma sessão de hardware. - Comunicação via IPIs

Um framework de comunicação baseado em Inter-Processor Interrupts permite que os kernels troquem mensagens de controle, notificações de falha ou solicitações de serviço. Esse canal leve é essencial para coordenar recursos partilhados, como dispositivos de I/O ou páginas de memória mapeadas. - Kernel hand over (KHO)

Quando for necessária uma atualização de kernel, o KHO transfere o controle de um kernel antigo para a nova versão de forma transparente, evitando downtime. As threads ativas podem ser migradas entre instâncias conforme políticas definidas.

Apesar de engenhoso, o design ainda enfrenta desafios: como garantir consistência de cache entre diferentes kernels, como arbitrar acesso a barramentos de I/O e como compartilhar drivers sem comprometer o isolamento.

Desafios e complexidades

Embora pioneira, a proposta é apenas um ponto de partida. Entre os principais obstáculos estão:

- Gerenciamento de dispositivos compartilhados: sem um hypervisor, é preciso criar mecanismos nativos para multiplexar acesso a controladoras PCIe, redes e storage.

- Sincronização de memória: memórias mapeadas (memremap) e caches devem ser mantidas coerentes para evitar dados corrompidos entre kernels.

- Overhead de IPIs: apesar de leves, interrupções entre núcleos podem crescer demais em sistemas com dezenas de kernels.

- Ferramentas de debug e profiling: há necessidade de expandir perf e ftrace para suportar múltiplas instâncias de kernels isolados.

Por ora, a série de patches RFC de Cong Wang está em fase experimental no LKML, pedindo insights da comunidade sobre design, nomenclatura e roteiros de evolução. É fundamental reforçar: trata-se de um estágio de discussão, não de um recurso pronto para produção.

Impacto potencial e perspectivas

Se a comunidade abraçar o multikernel, poderemos ver:

- Ambientes de edge computing onde cada microserviço roda em seu próprio kernel otimizado.

- Sistemas automotivos com um kernel de infotainment paralelo a um kernel de controle veicular, isolando falhas.

- Data centers oferecendo SLAs de alta disponibilidade sem hypervisors robustos.

- Pesquisa em OS: o Linux se aproxima de sistemas acadêmicos como Barrelfish e Helios, mas mantendo compatibilidade com a vasta base de drivers e subsistemas já existentes.

O modelo pode se tornar um meio-termo elegante entre contêineres — leves, porém limitados no isolamento de kernel — e máquinas virtuais — seguras, mas mais pesadas. Em um mundo onde performance e segurança caminham juntas, esse passo pode ser revolucionário.