Se você ainda não sabe, o Big Data é um termo abrangente que se refere a conjuntos de dados tão grandes e complexos que precisam ser processados por ferramentas de hardware e software especialmente projetadas. Os conjuntos de dados são tipicamente da ordem de tera ou exabytes em tamanho. Se você precisa analisar dados tão grandes, vai gostar de conhecer 8 excelentes ferramentas gratuitas e de código aberto para análise de dados para Big Data.

Big Data

Esses conjuntos de dados são criados a partir de uma gama diversificada de fontes: sensores que reúnem informações climáticas, informações publicamente disponíveis, como revistas, jornais, artigos. Outros exemplos em que big data é gerado incluem registros de transações de compra, web logs, registros médicos, vigilância militar, arquivos de vídeo e imagem e comércio eletrônico em larga escala.

Há um interesse crescente em Big Data e na análise de Big Data e nas implicações que eles têm para as empresas. A análise de Big Data é o processo de examinar grandes quantidades de dados para encontrar padrões, correlações e outras informações úteis que podem ajudar as empresas a se tornarem mais receptivas às mudanças e a tomarem decisões mais bem informadas.

Análise dos dados

A análise de Big Data pode ser realizada com software de mineração de dados. No entanto, as fontes de dados não estruturadas usadas para análise de big data não são necessariamente adequadas para investigação por software de mineração de dados tradicional. Isso faz parte de nossa série que identifica o melhor software de código aberto para Big Data. Este recurso destaca as melhores ferramentas de análise de dados. Esperançosamente, haverá algo de interesse para quem precisa analisar grandes volumes de dados não estruturados.

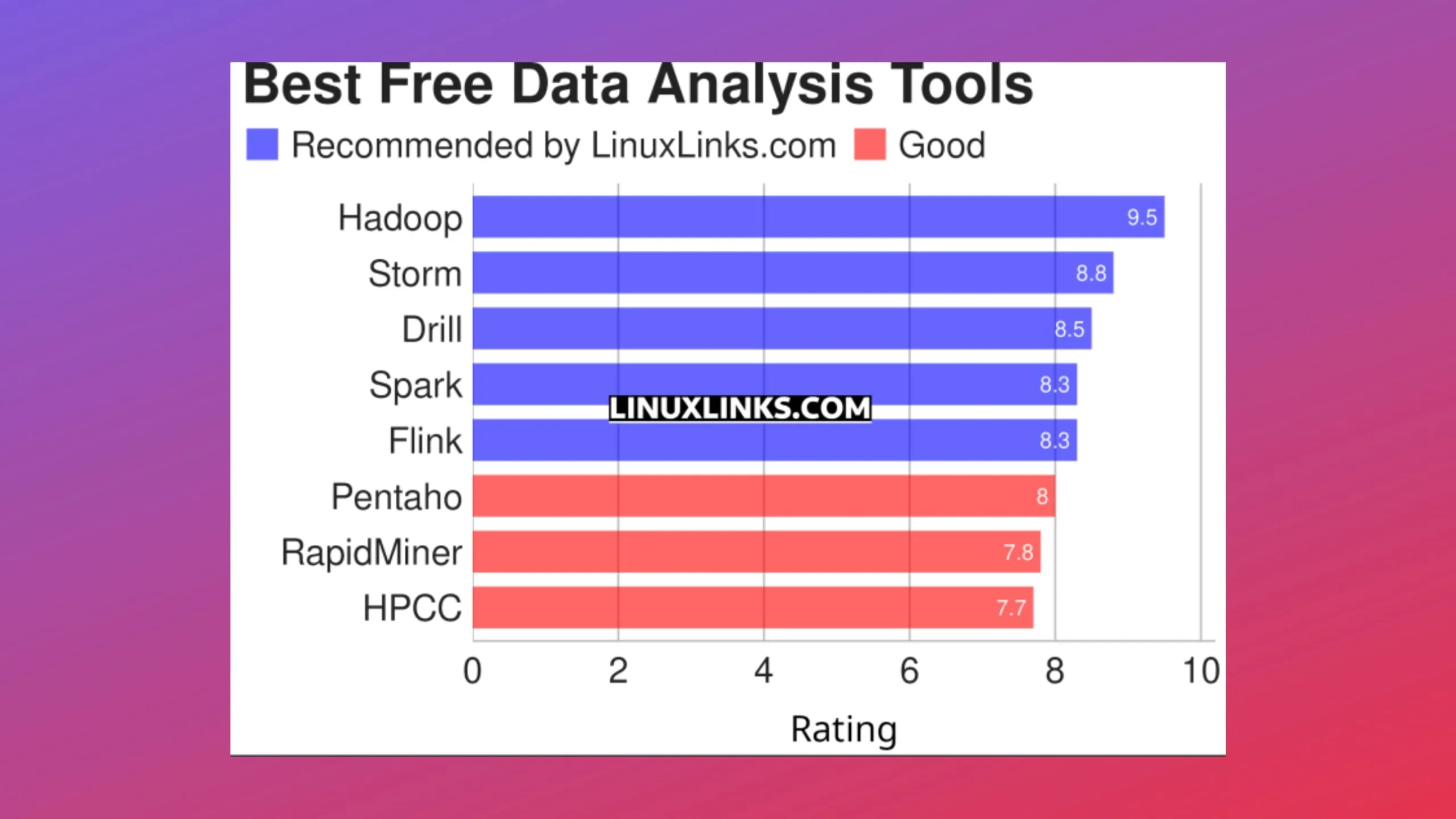

Abaixo, uma lista com 8 excelentes ferramentas gratuitas e de código aberto para análise de dados para Big Data, elaborada pelo pessoal do Linux Links.

Ferramentas de análise de dados Big Data

- Hadoop: Uma ferramenta para processamento distribuído de grandes conjuntos de dados em clusters de computadores;

- Storm: Computação em tempo real distribuída e tolerante a falhas;

- Drill: Sistema distribuído para análise interativa de conjuntos de dados em larga escala;

- Spark: Mecanismo de análise unificado para processamento de dados em larga escala;

- Flink: Estrutura e mecanismo de processamento distribuído;

- Pentaho: Relatórios empresariais, análises, painéis, mineração de dados, fluxo de trabalho e muito mais;

- RapidMiner: Descoberta de conhecimento em bancos de dados, aprendizado de máquina e mineração de dados;

- HPCC: Projetado para que a empresa resolva desafios de Big Data.