Uma nova fronteira na Inteligência Artificial (IA) para criação de conteúdo audiovisual acaba de ser desvendada! A Meituan, gigante chinesa de tecnologia, através de sua equipe de Inteligência Visual, lançou e abriu o código no GitHub do MeiGen-MultiTalk. Esta é uma estrutura inovadora para a geração de vídeo de diálogo com múltiplos personagens (Multi-Person Dialogue Video Generation), impulsionada por áudio e baseada em apenas uma única foto de referência.

O MeiGen-MultiTalk promete transformar a produção de vídeo ao resolver o complexo problema de fazer múltiplos personagens em uma imagem falarem e interagirem naturalmente com sincronia labial precisa e gestos corporais realistas, tudo a partir de áudios de diálogo e um texto de prompt. O segredo está em sua tecnologia pioneira L-RoPE (Label Rotary Position Embedding), que elimina a dessincronização entre áudio e personagem.

Este artigo fará um mergulho aprofundado no MeiGen-MultiTalk, explorando seus fundamentos técnicos, suas estratégias de treinamento avançadas e o impacto que essa ferramenta revolucionária terá em indústrias como produção de filmes, live commerce, desenvolvimento de jogos e criação de conteúdo educacional.

Introdução: além dos ‘talking heads’ – o próximo nível da IA em vídeo

A evolução da geração de vídeo com IA

Atualmente, a Inteligência Artificial alcançou progressos notáveis na geração de vídeo a partir de áudio. Tecnologias como “talking heads” (focadas apenas no rosto que fala) e “talking bodies” (que simulam o corpo inteiro) já permitem gerar vídeos de alta qualidade visual com sincronia de movimentos faciais e corporais a partir de áudio, com resultados impressionantes para avatares virtuais e influenciadores digitais.

Os três grandes desafios da geração de vídeo multi-personagens

No entanto, essas abordagens existentes enfrentam limitações significativas ao lidar com cenários mais complexos, como vídeos de diálogo com múltiplos personagens. Os desafios são:

- Adaptação de multi-streams de áudio: como diferenciar e vincular corretamente os sinais de áudio de diferentes pessoas?

- Posicionamento dinâmico de personagens: como rastrear e posicionar precisamente a área de movimento de cada personagem quando eles se movem na tela?

- Capacidade de seguir instruções: como garantir que o vídeo gerado siga estritamente descrições de texto para movimentos complexos (ex: grandes gestos corporais)?

Onde MultiTalk se posiciona: simulação de interações sociais complexas

O MultiTalk representa o próximo avanço. A evolução da IA em vídeo passou de detalhes faciais para movimentos corporais completos e, agora, para a geração de vídeo de diálogo multi-personagens, revelando uma tendência de simular interações sociais complexas do mundo real.

Isso reflete a demanda crescente por “realismo” e “complexidade” em conteúdo gerado por IA. Não basta mais que os personagens “se movam”; eles precisam “interagir naturalmente” e “entender e executar instruções complexas”.

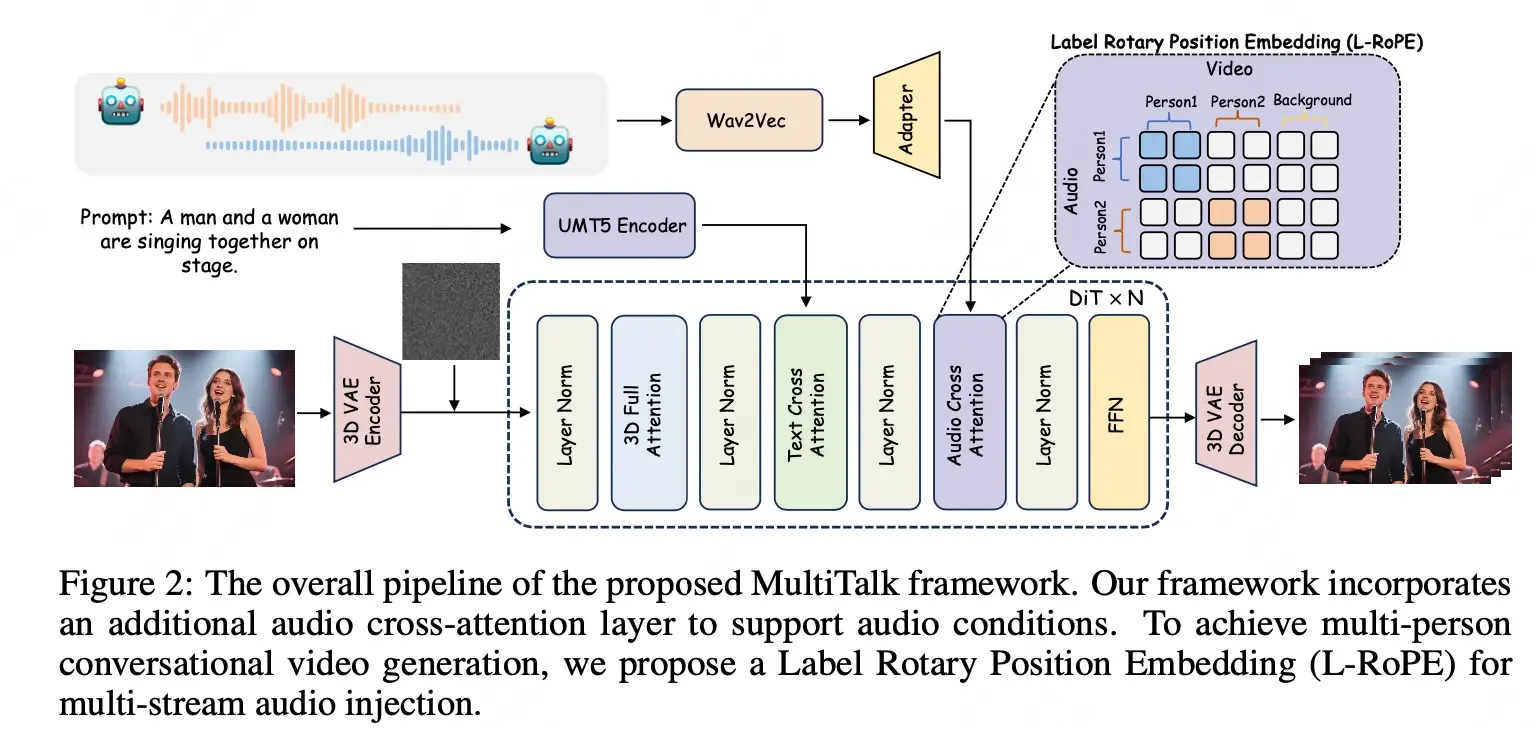

A arquitetura do MultiTalk: como a IA aprende a conversar

Estrutura básica: DiT e 3D VAE

O MultiTalk utiliza um modelo de difusão de vídeo baseado em DiT (Diffusion-in-Transformer) como seu esqueleto central. O DiT é conhecido por seu desempenho em geração de imagens e vídeos, usando a estrutura Transformer para capturar dependências de longo alcance.

Para processar dados de vídeo de forma eficiente, o MultiTalk integra um 3D VAE (Variational Autoencoder). O 3D VAE compacta dados de vídeo nas dimensões espacial e temporal em uma representação latente mais compacta, reduzindo a carga computacional do modelo de difusão.

O processo de geração é guiado por:

- Texto: um codificador de texto transforma o prompt de texto do usuário (ex: “Um homem e uma mulher estão cantando no palco”) em um embedding de condição textual.

- Contexto global de imagem: informações extraídas de um codificador de imagem CLIP são injetadas no modelo DiT. Esses contextos visuais e semânticos se combinam através de um mecanismo de atenção cruzada desacoplada.

Integração de áudio para um único personagem

Modelos básicos de imagem para vídeo (I2V) não suportam áudio nativamente. Para fazer o modelo “falar”, o MultiTalk adiciona novas camadas (com normalização de camada e mecanismo de atenção cruzada de áudio) após a camada de atenção cruzada de texto em cada bloco DiT.

Para extrair e integrar embeddings de áudio, o MultiTalk usa Wav2Vec, um extrator de características de áudio amplamente utilizado. Para capturar a dinâmica da fala, embeddings de áudio adjacentes à frame atual são concatenados (controlados por um parâmetro de comprimento de contexto k).

Um desafio significativo é a incompatibilidade de comprimento temporal entre as frames do espaço latente do vídeo (compactadas pelo 3D VAE) e os embeddings de áudio originais. Para resolver isso, o MultiTalk usa um adaptador de áudio que compacta e alinha os embeddings de áudio através de operações como divisão, subamostragem e codificação com múltiplas camadas MLP.

O desafio central: MultiTalk decifra a confusão de múltiplas vozes

Por que a IA se ‘confunde’ com multi-personagens?

Gerar vídeos de diálogo com múltiplos personagens é muito mais complexo do que com um único personagem, e os métodos existentes não conseguem lidar com isso. Os principais desafios são:

- Processamento de multi-streams de áudio: o modelo precisa processar simultaneamente e de forma independente os sinais de áudio de diferentes pessoas.

- Ligação precisa de áudio/personagem: é crucial garantir que cada personagem no vídeo seja animado apenas pelo seu fluxo de áudio correspondente, evitando o fenômeno não natural de “todos falando em uníssono”.

- Posicionamento dinâmico de personagens: os personagens se movem e mudam de postura, exigindo que o modelo rastreie suas áreas de movimento para mapear o áudio corretamente à visual.

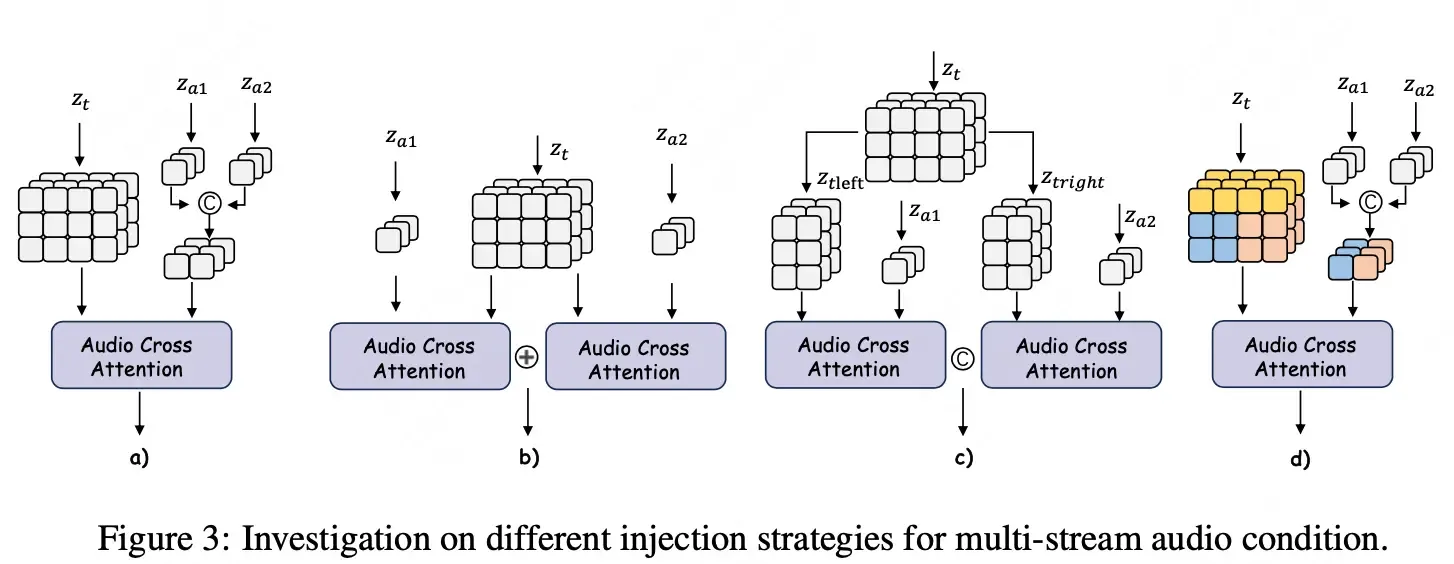

Tentativas iniciais que falharam

O MultiTalk testou várias abordagens intuitivas para injeção de áudio multi-streams, mas a maioria não conseguiu resolver o problema de ligação áudio/personagem. As tentativas incluíram:

- Concatenação direta de embeddings multi-stream de áudio: resultou em sincronização confusa, pois o modelo não conseguia vincular o áudio às regiões específicas dos personagens no vídeo.

- Cálculo separado e soma: calcular a atenção cruzada para cada fluxo de áudio separadamente e depois somar os resultados também falhou na ligação áudio/personagem.

- Divisão do espaço latente do vídeo (áreas esquerda/direita): essa abordagem, que dividia o vídeo em áreas fixas (esquerda/direita) e as vinculava a fluxos de áudio, tinha capacidade de generalização extremamente limitada. Funcionava apenas para movimentos pequenos, mas falhava se os personagens se movessem muito ou se cruzassem.

A razão fundamental para o fracasso desses métodos tradicionais é a falta de uma capacidade adaptativa de localizar sujeitos dinâmicos. Eles não conseguiam fazer o modelo entender qual fluxo de áudio deveria corresponder a qual personagem em movimento. A ausência de um mecanismo de “percepção de personagem” e “ligação semântica” profunda levava a “ligações incorretas”, onde todos os personagens falavam em sincronia, o que prejudicava a autenticidade do vídeo.

L-ROPE: a inovação que permite à IA ‘conversar’ naturalmente

Rastreamento dinâmico de personagens no vídeo

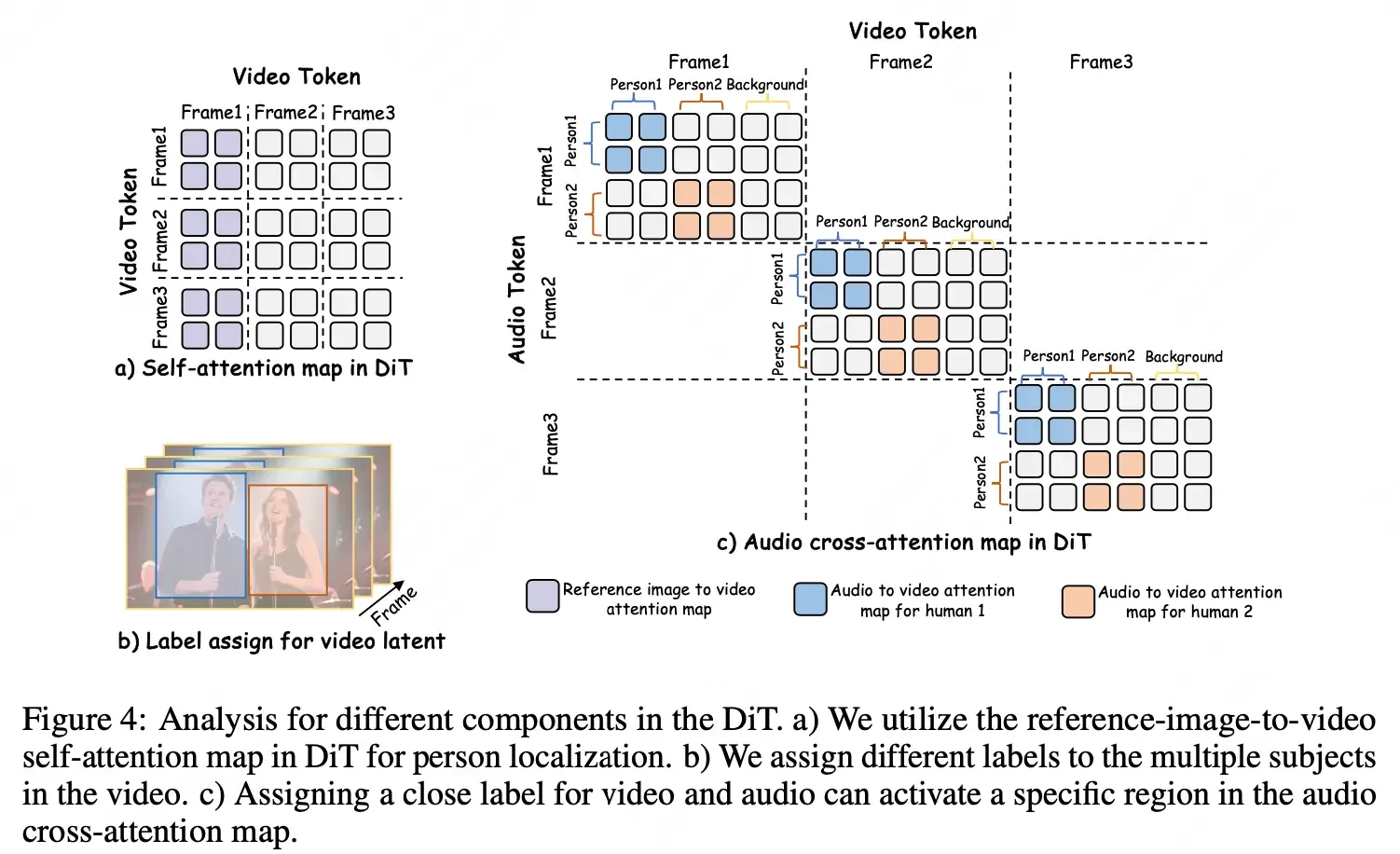

Antes de aplicar o L-RoPE para ligação de áudio, o MultiTalk primeiro rastreia dinamicamente a posição de cada personagem no vídeo. Dada uma imagem de referência com múltiplos personagens, o modelo identifica a área de máscara de cada personagem e da máscara de fundo. Usando um “mapa de autoatenção de imagem para vídeo” do modelo DiT, ele calcula a similaridade entre cada token no espaço latente do vídeo e a máscara de cada personagem na imagem de referência. Isso gera uma matriz de similaridade que permite ao modelo determinar dinamicamente a qual personagem (ou fundo) cada token latente de vídeo pertence, rastreando seus movimentos.

Label Rotary Position Embedding (L-ROPE): a inovação central

O L-ROPE é a inovação central do MultiTalk, baseada na ideia do ROPE (Rotary Position Embedding). Enquanto o ROPE tradicional lida com informações de posição espaço-temporal, o L-ROPE vai além, incorporando “rótulos de categoria” na codificação de posição. Isso permite a ligação precisa de multi-stream de áudio com multi-personagens na camada de atenção cruzada de áudio do bloco DiT.

Na estratégia de alocação de rótulos:

- O espaço latente do vídeo contém múltiplas categorias (personagens e fundo).

- Cada personagem recebe um intervalo de valores numéricos como rótulo (ex: Personagem 1: {0-4}, Personagem 2: {20-24}).

- O rótulo final de cada token latente de vídeo é calculado dentro desse intervalo, baseado na sua similaridade com a máscara do personagem correspondente.

- A área de fundo recebe um rótulo estático para não ser associada a nenhum áudio.

- Os embeddings de áudio multi-stream são concatenados, e cada fluxo de áudio recebe um rótulo estático e único, escolhido para “se aproximar” ou “corresponder” ao intervalo de rótulos visuais do personagem correspondente (ex: Áudio 1: 2, Áudio 2: 22).

A chave do L-ROPE é que ele integra informações de “categoria” (qual pixel pertence a qual personagem/fundo) na “codificação de posição”. Na atenção cruzada de áudio, quando o rótulo de uma área do vídeo (Personagem 1) “corresponde” ao rótulo de um fluxo de áudio (Áudio 1), a atenção entre eles é ativada, forçando o modelo a concentrar o efeito do Áudio 1 no Personagem 1. Isso resolve o problema de ligação incorreta (“todos falando em uníssono”).

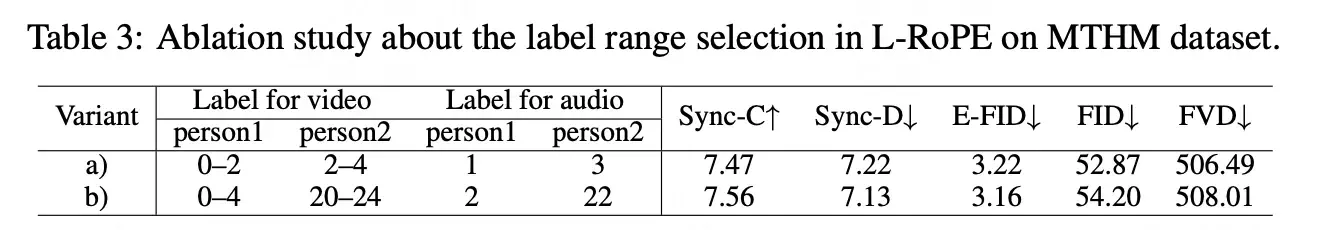

Experimentos de ablação mostraram que o L-ROPE é insensível a variações específicas nos intervalos de rótulos, mantendo o desempenho próximo, o que valida sua eficácia.

Estratégias de treinamento do MultiTalk: aprimorando habilidades gradualmente

O MultiTalk utiliza múltiplas estratégias de treinamento para garantir alto desempenho, sincronia labial precisa e capacidade de seguir instruções em cenários multi-personagens.

Treinamento em duas fases: aprimoramento sequencial

O processo de treinamento é dividido em dois estágios para aprimorar gradualmente o processamento de áudio e a sincronia labial:

- Primeira fase: foca em desenvolver capacidades robustas para vídeos de um único personagem, utilizando um conjunto de dados de vídeos de pessoas falando sozinhas.

- Segunda fase: após dominar a capacidade de um único personagem, o modelo é treinado com dados específicos de vídeos de diálogo com dois fluxos de áudio para aprender a interação e o controle de múltiplos personagens.

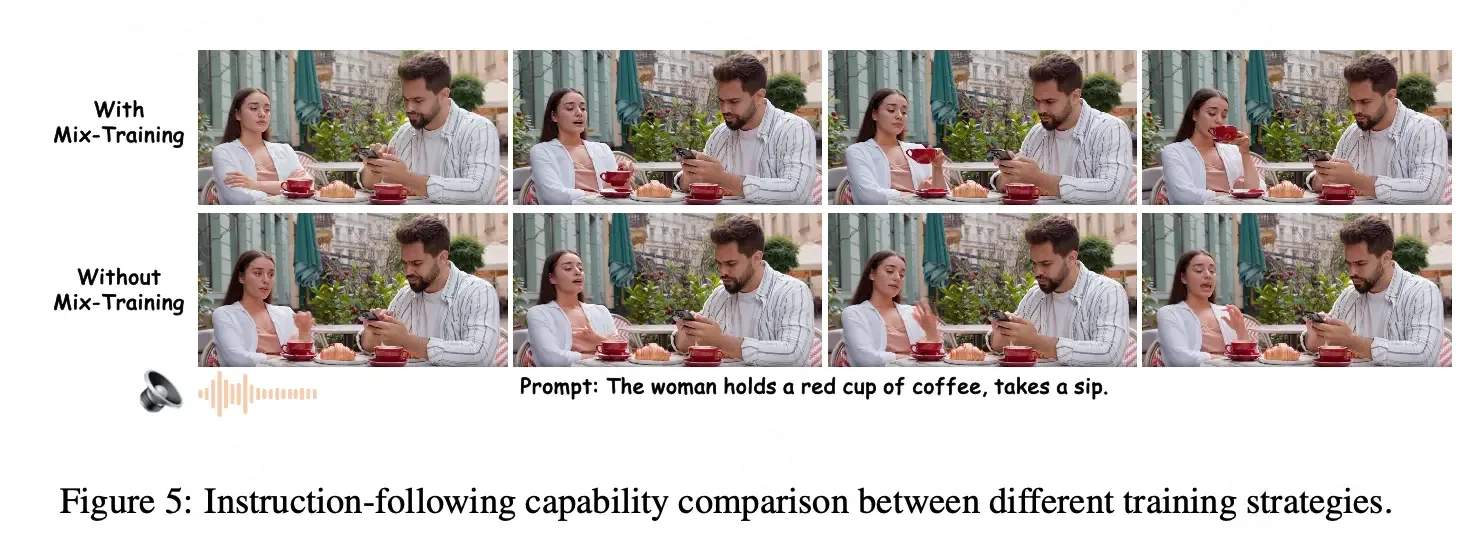

Treinamento de parâmetros parciais: foco e prevenção de degeneração

Esta é uma estratégia crucial no treinamento do MultiTalk. Durante todo o processo, apenas os parâmetros de rede das camadas de atenção cruzada de áudio e do adaptador de áudio são atualizados. Todos os outros parâmetros do modelo base são congelados.

Pesquisas mostraram que, com recursos computacionais e dados limitados, o treinamento de todos os parâmetros levaria a uma degeneração significativa na capacidade de seguir instruções (especialmente para movimentos complexos e interações) e poderia causar artefatos visuais como mãos ou objetos distorcidos em vídeos gerados. Ao treinar apenas camadas específicas diretamente relacionadas ao áudio, o MultiTalk preserva a forte capacidade original do modelo base de seguir instruções e evita esses problemas visuais.

Treinamento multi-tarefa: enriquecendo a compreensão do cenário

O MultiTalk adota um paradigma de treinamento multi-tarefa, dividindo as tarefas em treinamento Áudio + Imagem para Vídeo (AI2V) e treinamento Imagem para Vídeo (I2V). Ambas as tarefas compartilham os mesmos parâmetros de rede.

- AI2V: usa tanto a imagem de referência quanto o áudio como input condicional, focando em aprender a sincronia labial e a geração de movimento impulsionada por áudio.

- I2V: remove a condição de áudio (definindo embeddings de áudio como zero) e usa um conjunto de dados único de vídeos multi-evento com interações complexas (ex: pessoas pegando xícaras, interagindo com o ambiente). Esse conjunto de dados é vital para que o modelo entenda e execute ações complexas descritas em prompts de texto.

A inclusão do treinamento I2V garante que o modelo mantenha sua capacidade robusta de seguir instruções, gerando vídeos que correspondem melhor à intenção do usuário, mesmo em cenários complexos.

Geração de vídeos longos: estendendo a narrativa com o MultiTalk

Embora o MultiTalk gere vídeos curtos de alta qualidade (3-5 segundos), isso não é suficiente para aplicações reais como filmes ou livestreaming. Para superar essa limitação, o MultiTalk introduz um método auto-regressivo para gerar vídeos longos.

Em vez de depender apenas da primeira frame do vídeo para gerar frames subsequentes (como em modelos I2V tradicionais), o MultiTalk aprimora essa abordagem. Ao gerar um novo segmento de vídeo, ele usa as últimas 5 frames do vídeo gerado anteriormente como input condicional adicional para a etapa de inferência atual. Isso permite que o modelo “lembre” e continue movimentos e estados de cena anteriores, garantindo continuidade e extensão temporal.

Essas 5 frames condicionais são compactadas em 2 frames de representação latente de ruído via 3D VAE. As novas frames de vídeo são então preenchidas com zeros (exceto as 2 frames do histórico) e concatenadas com um vídeo mask para formar o input completo para o modelo DiT, gerando o novo segmento de vídeo com fluidez. Veja uma demonstração do vídeo neste link.

MultiTalk em ação: performance e resultados impressionantes

A performance do MultiTalk foi validada por extensos experimentos e comparações com métodos de ponta.

Conjuntos de dados e métricas de avaliação

- Treinamento:

- Primeira fase: aproximadamente 2.000 horas de vídeos de uma pessoa falando.

- Segunda fase: 100 horas de vídeos de diálogo com dois personagens (com dois fluxos de áudio).

- Avaliação:

- Testes: em três tipos de conjuntos de dados: “falando de cabeça” (HDTF e CelebV-HQ), “falando de corpo” (EMTDT) e “falando de corpo com dois personagens” (MTHM).

- Métricas:

- FID (Frechet Inception Distance) e FVD (Fréchet Video Distance): qualidade do vídeo gerado.

- E-FID (Expression-FID): expressividade facial.

- Sync-C e Sync-D: sincronia labial com o áudio.

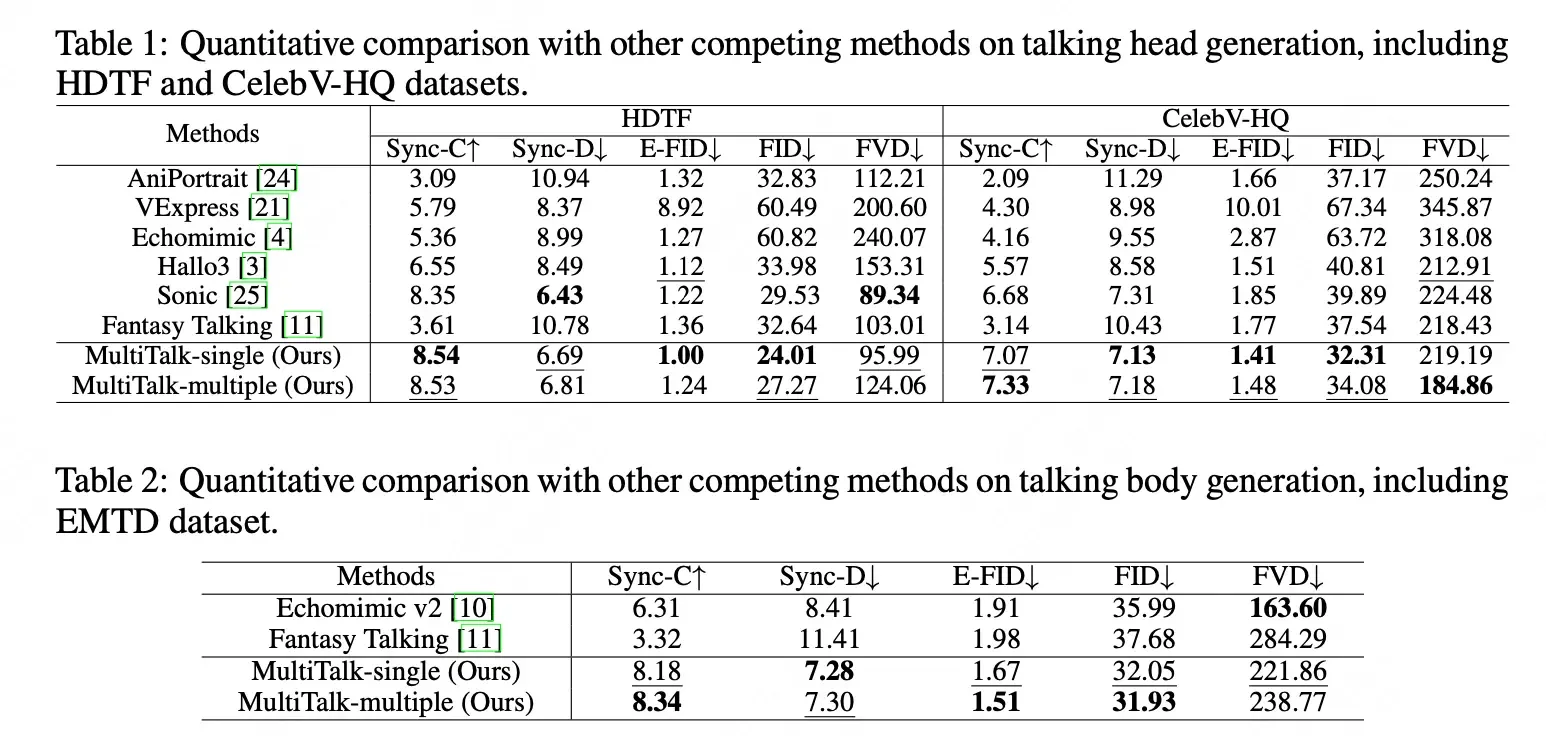

Resultados quantitativos: superando os métodos de ponta

Em comparação com métodos de ponta como AniPortrait, VExpress, EchoMimic, Hallo3, Sonic e Fantasy Talking, o MultiTalk superou a maioria das métricas. Destacou-se especialmente na sincronia labial (Sync-C, Sync-D) e na qualidade geral do vídeo (FID, FVD).

Uma análise aprofundada confirmou que o treinamento com áudio multi-stream não degrada o desempenho do MultiTalk em vídeos de um único personagem. O modelo multi-personagem manteve uma performance comparável aos modelos de um único personagem.

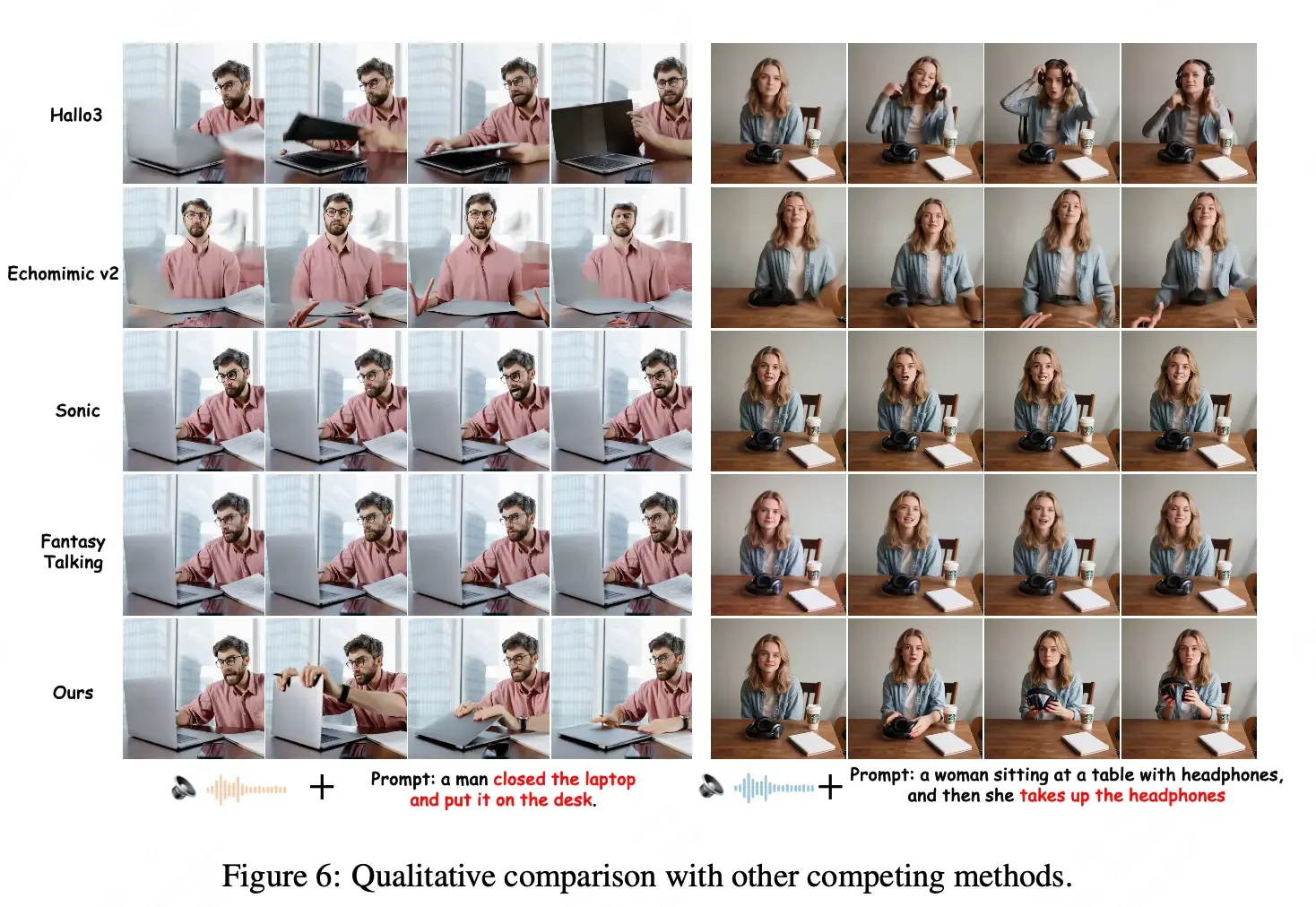

Avaliação qualitativa: fidelidade à instrução e realismo

O MultiTalk demonstrou alta qualidade qualitativa, com vantagens notáveis:

- Capacidade de seguir instruções: consegue gerar vídeos que respondem precisamente a prompts de texto complexos (ex: “Um homem fecha o laptop e o coloca na mesa”, “Uma mulher senta-se à mesa com fones de ouvido e depois pega os fones de ouvido”), algo que outros métodos têm dificuldade em fazer.

- Redução de artefatos visuais: redução significativa de artefatos visuais como mãos ou objetos distorcidos, resultando em maior qualidade visual e naturalidade.

- Interações complexas: como o primeiro método projetado especificamente para geração multi-personagens, o MultiTalk se destaca no manuseio de interações complexas entre indivíduos.

- Coerência: em comparação com métodos de “colagem de vídeo” (gerar personagens separadamente e depois combiná-los), o MultiTalk lida eficazmente com interações, evitando inconsistências e tornando o diálogo e a interação multi-personagens mais fluidos e naturais.

- Compreensão da localização: a visualização dos mapas de autoatenção demonstrou que o MultiTalk consegue identificar e rastrear a localização específica de cada personagem no vídeo, confirmando a eficácia do L-ROPE.

MeiGen-MultiTalk e a paisagem competitiva: um olhar sobre o Veo 3 do Google

No cenário em rápida evolução da geração de vídeo por IA, o MeiGen-MultiTalk surge como uma ferramenta poderosa, especialmente em sua capacidade de lidar com interações multi-personagens a partir de uma única imagem. Essa especialização o diferencia de modelos mais gerais, como o recém-lançado Veo 3 do Google. Enquanto o Veo 3 se destaca pela sua versatilidade em gerar vídeos de alta qualidade a partir de texto, imagens ou prompts de estilo, com um foco abrangente em fotorrealismo e controle de movimentos de câmera complexos, o MultiTalk foca em um gargalo específico: a interação de diálogo natural entre múltiplos indivíduos em uma cena. Onde o Veo 3 oferece um palco vasto e detalhado, o MultiTalk domina a dinâmica da conversação, garantindo sincronia labial precisa e movimentos corporais contextuais para cada participante, mesmo quando múltiplos áudios se sobrepõem. Essa especialização faz do MeiGen-MultiTalk uma ferramenta particularmente valiosa para cenários que exigem diálogo e interação realistas entre personagens, preenchendo um nicho crucial que modelos de propósito mais geral podem não abordar com a mesma profundidade.

Conclusão e perspectivas futuras: o MultiTalk e a próxima era do conteúdo em vídeo

O MeiGen-MultiTalk da Meituan representa um avanço significativo na geração de vídeo de diálogo multi-personagens impulsionada por áudio. Sua inovadora abordagem L-ROPE resolveu o complexo problema de injetar múltiplos fluxos de áudio e vinculá-los com precisão a personagens específicos no vídeo, combinando posicionamento adaptativo de personagens com codificação de rótulos de categoria. Além disso, as estratégias de treinamento em duas fases, com parâmetros parciais e multi-tarefa, garantem alta capacidade de seguir instruções e qualidade visual, mesmo com recursos limitados.

O MultiTalk abre caminho para vastas aplicações em produção de filmes e séries, livestreaming (especialmente em e-commerce), desenvolvimento de jogos e criação de conteúdo educacional. Acreditamos que essa ferramenta reduzirá drasticamente a barreira de produção para vídeos multi-personagens, tornando a criação de conteúdo personalizado e interativo mais eficiente e acessível. Embora desafios como a lacuna de desempenho entre áudio real e áudio sintético ainda existam, o MultiTalk indica o caminho para futuras pesquisas.

Chamada à ação: O MeiGen-MultiTalk já está disponível como código aberto no GitHub. Convidamos desenvolvedores e pesquisadores a se juntarem à Meituan para contribuir e construir o futuro da geração de vídeo com IA.

Sobre o Departamento de Inteligência Visual da Meituan

O Departamento de Inteligência Visual da Meituan foca em construir capacidades de visão computacional do básico ao especializado, aplicadas a diversos cenários de e-commerce local. Isso inclui grandes modelos de geração visual, humanos virtuais interativos multimodais (para marketing e livestreaming de baixo custo), grandes modelos multimodais para documentos/produtos/segurança (para operação de lojas, gerenciamento de produtos e contas), e reconhecimento facial, OCR, análise fina de imagem, detecção/segmentação de alto desempenho, e compreensão de cenas de rua como infraestrutura.

A equipe já abriu o código do Food2K (maior dataset de imagens de alimentos da indústria), YOLOV6 (estrutura de detecção de objetos que liderou o ranking de contribuições open source em 2023), e ganhou mais de 10 prêmios em competições internacionais, centenas de patentes e mais de 60 artigos em conferências e periódicos de topo. Colaboraram com instituições de pesquisa na China e receberam prêmios de progresso científico e tecnológico.