Se você usa o modo de voz do ChatGPT, sabe que a experiência é imersiva, mas limitada: é você e uma tela de animação. Você ouve, mas não vê. Isso está prestes a mudar completamente — e o motivo tem nome: Gemini Live.

Uma análise recente do código do aplicativo do ChatGPT, em um APK teardown, revelou que a OpenAI está preparando uma grande atualização para transformar a forma como o modo de voz funciona. Em vez de ocupar a tela inteira, o recurso passará a operar dentro da própria janela de chat, abrindo caminho para algo muito maior: a exibição de conteúdo avançado como mapas, links, resultados de pesquisa e previsões do tempo.

Essa mudança representa mais do que uma simples reformulação visual. Ela posiciona o ChatGPT para competir diretamente com o Gemini Live, o assistente de voz multimodal do Google, que já combina perfeitamente fala, texto e informação visual.

O que muda no modo de voz do ChatGPT

Adeus, tela cheia imersiva

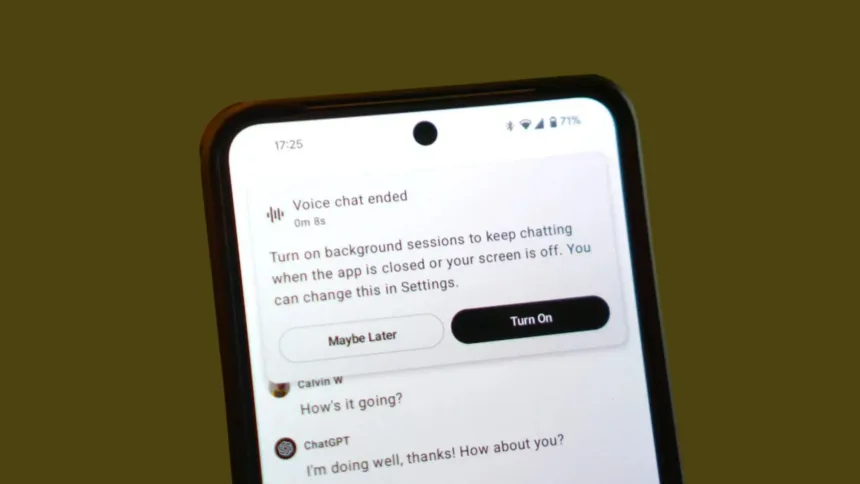

Atualmente, o modo de voz do ChatGPT funciona de forma bastante isolada. Quando o usuário toca no ícone de fone de ouvido, o aplicativo entra em modo de tela cheia, exibindo apenas a animação de ondas sonoras e, opcionalmente, a transcrição do que é dito.

Essa abordagem, embora elegante e focada na conversa, tem uma limitação clara: se você pede uma previsão do tempo, um mapa ou um link, o assistente precisa encerrar a conversa por voz para exibir os resultados na interface textual. Isso quebra a imersão e torna o uso contínuo menos prático.

Olá, integração direta no chat

De acordo com a descoberta feita pelo site Android Authority, na versão ChatGPT v1.2025.294, a OpenAI está testando uma nova abordagem: a conversa por voz ocorrerá diretamente dentro da janela de chat.

O usuário continuará vendo o histórico de mensagens e, enquanto fala, verá botões flutuantes para encerrar ou mutar o diálogo de voz. A interação será contínua, fluida e, pela primeira vez, multimodal — permitindo que a IA mostre resultados visuais sem interromper a conversa.

Por que esta é uma atualização crucial (e não apenas visual)

A limitação do áudio puro

O modo de voz atual é, de certa forma, “cego”. Ele consegue descrever, mas não mostrar. Pode te contar o clima, mas não exibir uma previsão semanal detalhada. Pode recomendar um restaurante, mas não mostrar um mapa interativo ou avaliar opções próximas.

Essa limitação é natural em interfaces de áudio puro, mas no contexto atual, em que a IA multimodal está se tornando o novo padrão, ela já parece ultrapassada.

O poder do conteúdo avançado

A integração do modo de voz do ChatGPT dentro do chat muda completamente esse cenário. Agora, enquanto conversa, o usuário poderá visualizar conteúdo avançado, incluindo:

- Mapas e rotas com base em solicitações geográficas;

- Links clicáveis para páginas externas;

- Gráficos e tabelas de dados;

- Cards interativos de previsão do tempo ou notícias.

Isso significa que o ChatGPT se tornará verdadeiramente multimodal, combinando voz, texto e imagem em tempo real — uma evolução natural após a introdução da visão e do upload de arquivos nas versões mais recentes do modelo.

A verdadeira batalha: nivelando o campo contra o Gemini Live

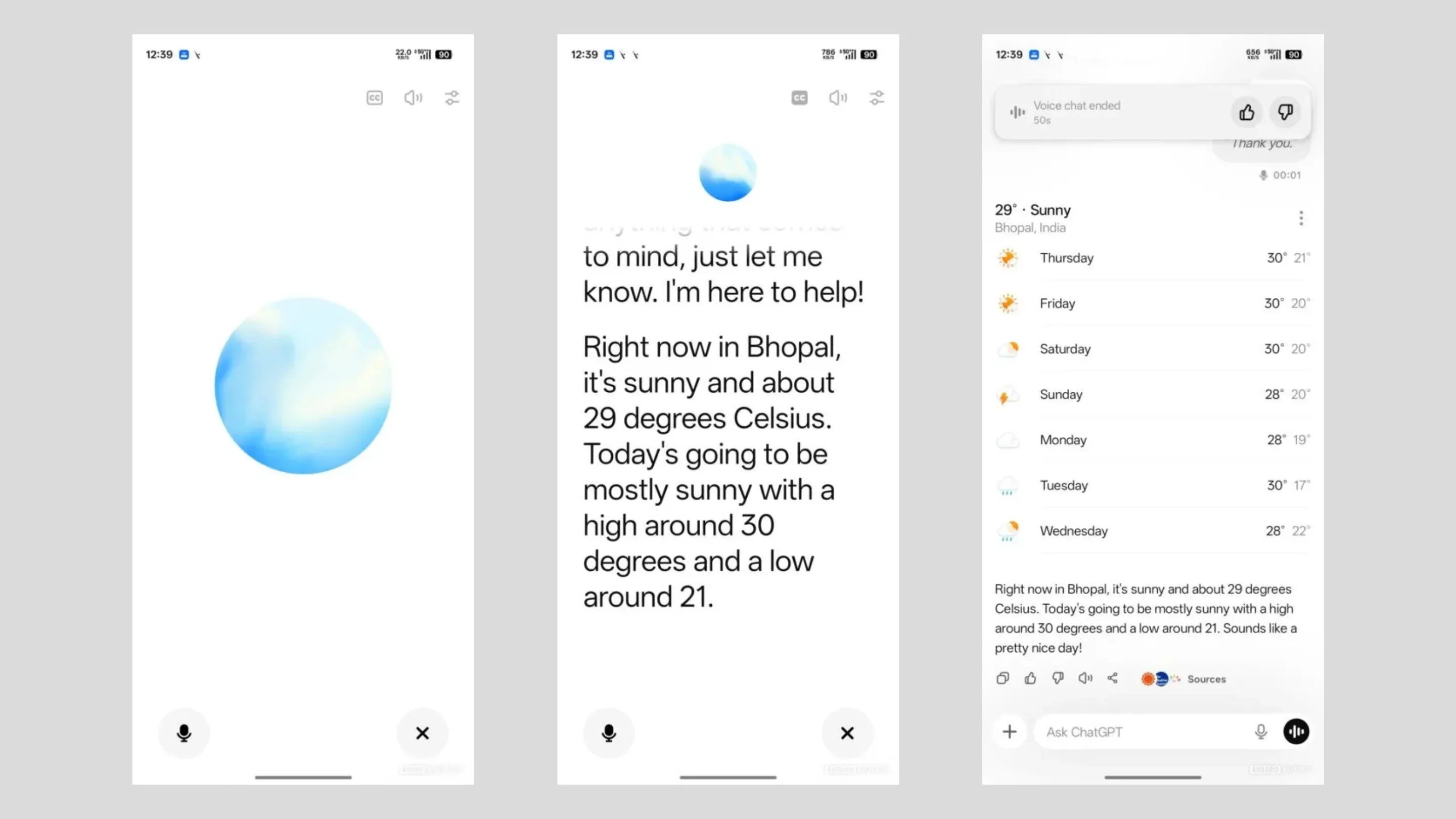

O Google já faz isso (e muito bem)

O Gemini Live, recurso do Google Gemini, foi projetado desde o início para integrar voz e visual de maneira nativa. Enquanto o usuário conversa com o assistente, ele pode mostrar resultados da Busca Google, mapas, imagens e até vídeos curtos diretamente na tela.

Essa experiência é naturalmente mais rica e informativa — e coloca o Google em vantagem no ecossistema Android, onde o Gemini já está profundamente integrado ao sistema.

A resposta da OpenAI

A mudança que a OpenAI prepara para o modo de voz do ChatGPT é claramente estratégica. Com o Gemini Live ganhando força e o Google controlando os principais canais de distribuição (Android, Busca e YouTube), a OpenAI precisa garantir que sua solução de voz não fique para trás.

Embora o ChatGPT já se destaque por suas vozes realistas e pela naturalidade da conversação, faltava-lhe a capacidade de mostrar informações. Ao integrar o modo de voz ao chat, a empresa não apenas corrige essa falha, mas também cria paridade de experiência com o concorrente — e, potencialmente, abre espaço para inovações próprias, como respostas interativas, cards dinâmicos e integrações com o ChatGPT Plus ou GPTs personalizados.

Conclusão: O futuro da IA é conversacional e visual

A mudança no modo de voz do ChatGPT, saindo da tela cheia e migrando para o chat, representa muito mais do que uma simples reformulação de interface. É uma evolução estrutural na maneira como a OpenAI enxerga a interação humano-IA.

Ao permitir que o assistente exiba conteúdo avançado em tempo real — enquanto conversa com o usuário —, a OpenAI transforma o ChatGPT de um assistente falante em um assistente completo, capaz de unir voz, visão e contexto.

Essa atualização marca o início de uma nova fase: a dos assistentes multimodais, onde ver é tão importante quanto ouvir. E, nesse campo, a disputa entre ChatGPT e Gemini Live promete redefinir o que entendemos como inteligência artificial conversacional.

Você usa o modo de voz do ChatGPT ou prefere o Gemini? O que acha dessa mudança? Deixe sua opinião nos comentários — a conversa, agora, é para ser vista e ouvida.