A corrida pelo domínio da inteligência artificial está cada vez mais centrada no hardware, e poucas movimentações recentes ilustram isso tão bem quanto o acordo Samsung e Google acerca da TPU Ironwood. A decisão do Google de escolher a Samsung como fornecedora da próxima geração de memória HBM4 para sua TPU Ironwood (7ª geração) sinaliza uma mudança estratégica profunda no ecossistema de semicondutores para IA, onde largura de banda, eficiência energética e integração avançada se tornam os elementos decisivos da disputa. Este artigo analisa o significado técnico, competitivo e estratégico desse acordo e o que ele representa para o futuro da infraestrutura de IA.

Nos bastidores da explosão de modelos generativos e da demanda crescente por capacidade de treinamento, a escolha da memória que alimenta aceleradores de última geração tornou-se tão importante quanto os próprios chips. Por isso, entender por que o HBM4 é tão essencial para a nova TPU e como essa parceria reposiciona Samsung, Google e Broadcom na geopolítica do silício é fundamental para qualquer profissional de TI, pesquisador ou entusiasta de hardware que queira acompanhar a próxima fase da IA.

A nova era do hardware de IA: A TPU Ironwood (7ª geração)

A TPU Ironwood marca uma evolução significativa na estratégia do Google para acelerar modelos cada vez maiores, mais multimodais e voltados para inferência em escala massiva. Com arquitetura desenvolvida em parceria com a Broadcom, a nova geração se apoia fortemente em avanços na integração entre computação e memória, campo em que o HBM4 desempenha papel central graças à sua largura de banda superior.

A Ironwood foi projetada para entregar maior eficiência por watt, throughput ampliado e comunicação interconectada altamente otimizada para clusters. Com modelos como Gemini exigindo volumes colossais de dados por ciclo de processamento, a Google não poderia avançar sem solucionar o gargalo que define todo o hardware de IA: a largura de banda da memória.

O que são as TPUs do Google?

As Tensor Processing Units (TPUs) são aceleradores especializados criados para treinar e executar modelos de aprendizado de máquina em larga escala. Ao contrário das GPUs, que equilibram múltiplos tipos de processamento, as TPUs são otimizadas para operações matriciais massivamente paralelas, com foco em deep learning. Desde sua primeira geração, elas se tornaram a base da infraestrutura do Google Cloud, suportando aplicações como tradução automática, buscas inteligentes e mais recentemente modelos generativos e multimodais.

A evolução das TPUs segue um ritmo particularmente agressivo, com cada geração trazendo avanços significativos em interconexão, eficiência energética e, sobretudo, capacidade de memória. No caso da Ironwood, esses ganhos dependem diretamente da adoção do HBM4, cujo salto generacional redefine os limites de throughput e desempenho sustentado.

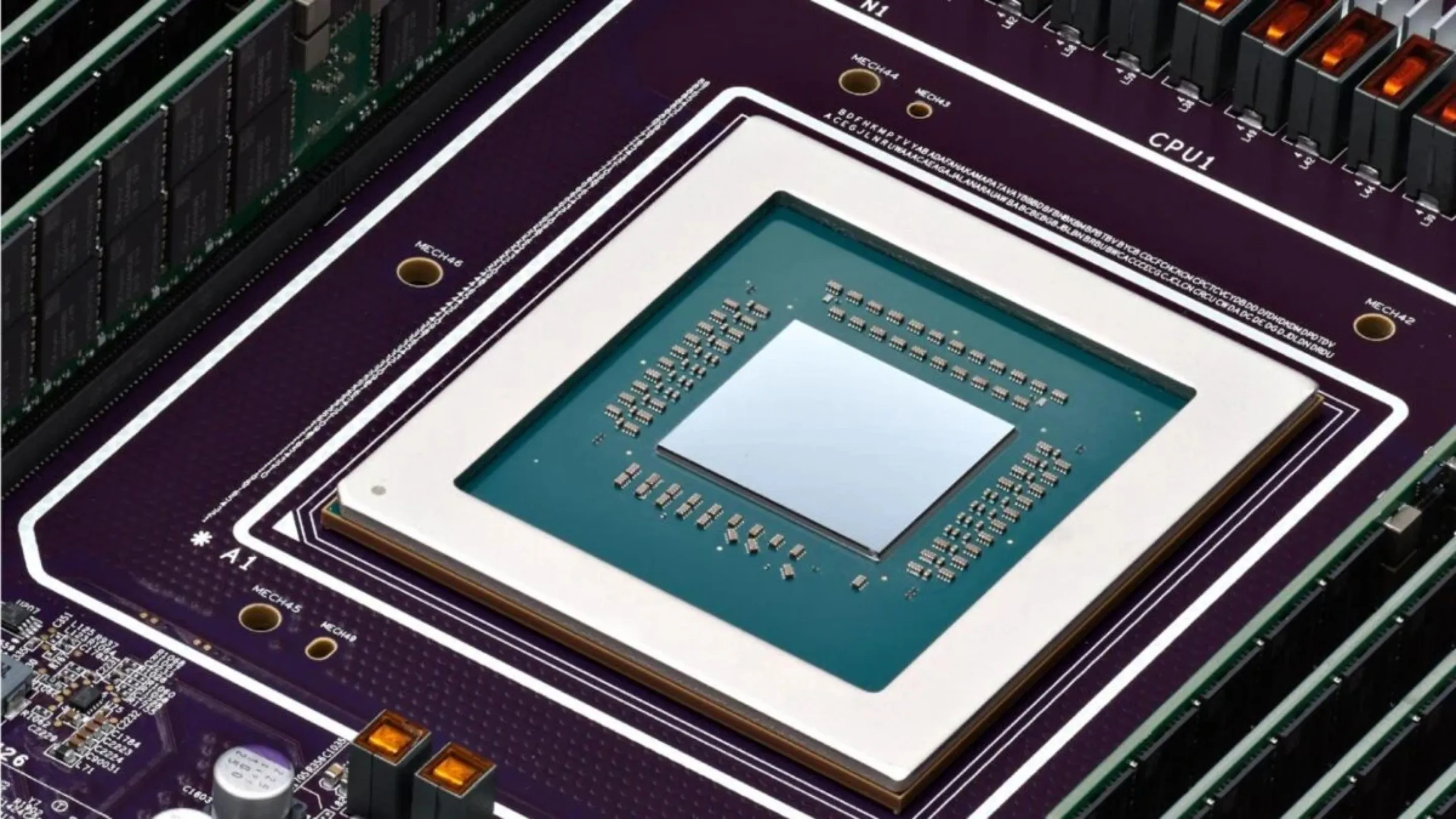

A colaboração Broadcom e o design do acelerador

A Broadcom desempenha um papel crítico na arquitetura das TPUs, atuando como parceira de longa data na produção e coengenharia dos chips customizados usados pelo Google. Essa colaboração não se limita à fabricação física, mas também à integração do chip com sistemas de rede, interconexão e empilhamento de memória.

A chegada do HBM4 aumenta ainda mais a importância dessa parceria, já que sua adoção requer novas tecnologias de empacotamento avançado, controle térmico e sinalização de alta velocidade. A transição para HBM4 representa um marco não apenas na evolução das TPUs, mas também na capacidade conjunta Google–Broadcom de competir com Nvidia e AMD no mercado de aceleradores de IA.

HBM4: O padrão ouro da memória para IA

O HBM4 (High Bandwidth Memory 4) é a próxima fase na evolução da memória empilhada de alta largura de banda, superando amplamente o HBM3E utilizado atualmente nos chips de IA mais poderosos do mercado. Ele entrega ganhos expressivos em três dimensões críticas: largura de banda, densidade e eficiência.

Com taxas que podem ultrapassar 1,6 TB/s por stack, o HBM4 resolve diretamente o principal gargalo dos aceleradores modernos, permitindo que mais dados cheguem mais rápido aos processadores matriciais. O salto é tão grande que habilita arquiteturas antes inviáveis, como clusters mais densos ou treinamento distribuído com latência drasticamente reduzida.

Além da largura de banda, o HBM4 traz avanços em empilhamento, permitindo alturas maiores e capacidades ampliadas sem comprometer a integridade térmica. Isso é especialmente importante para chips como a TPU Ironwood, que precisam balancear escalabilidade e eficiência energética ao rodar modelos gigantescos.

Para o Google, o HBM4 não é apenas uma melhoria incremental, mas uma peça estratégica que determina seu posicionamento frente ao domínio atual da Nvidia no mercado de datacenters para IA. A nova TPU só é competitiva graças à combinação entre o design Google-Broadcom e a memória avançada da Samsung.

Implicações estratégicas para a Samsung e o mercado

O fornecimento de chips HBM4 Samsung para a TPU Ironwood coloca a empresa sul-coreana no centro de uma das disputas mais importantes do setor de semicondutores. Após anos atrás de SK Hynix no mercado de HBM, a Samsung recupera relevância e finalmente volta a conquistar contratos estratégicos.

Esse acordo segue outra vitória: o fornecimento de memória HBM para a linha Nvidia Rubin, sucessora da Blackwell, que deve dominar o mercado de treinamento de IA a partir de 2026. Com dois dos maiores consumidores de HBM apostando em sua tecnologia, a Samsung consolida uma retomada significativa de credibilidade e competitividade.

O impacto não se limita à disputa entre fabricantes de DRAM, mas se estende ao ecossistema de aceleradores. Nvidia, Google, AMD e startups de IA competem por capacidade produtiva de HBM, que se tornou o recurso mais escasso do setor. Uma fabricante capaz de entregar volume, qualidade e integração avançada passa a definir quem consegue lançar produtos no prazo e com desempenho competitivo.

Para a Google, o acordo evita dependência excessiva de um único fornecedor e reduz riscos de gargalos produtivos que poderiam comprometer sua estratégia de nuvem. Já para a Broadcom, a parceria reafirma sua posição como fabricante-chave de chips de IA customizados, que dependem diretamente da capacidade de integração com HBM topo de linha.

Micron e SK Hynix, por sua vez, enfrentarão pressão ainda maior para acelerar suas linhas de HBM4 e garantir contratos estratégicos em um mercado que agora se tornou altamente volátil e competitivo.

Conclusão: O futuro da infraestrutura de IA

O acordo entre Samsung e Google para a adoção do HBM4 na TPU Ironwood não é apenas mais um anúncio corporativo, mas um marco na evolução da infraestrutura de IA global. Em uma era onde os modelos são cada vez maiores e mais exigentes, a memória se tornou tão decisiva quanto o próprio chip, e a Samsung mostra que está disposta a liderar essa nova etapa.

Para o mercado, significa uma redistribuição de forças entre fabricantes de memória e um avanço importante na capacidade de atender à demanda explosiva por hardware especializado. Para o Google, é a oportunidade de competir com Nvidia em patamares mais equilibrados, oferecendo mais desempenho e eficiência para empresas e desenvolvedores que dependem do Google Cloud.

A próxima geração de aceleradores será definida por largura de banda, eficiência energética e inovação em empacotamento, e o HBM4 está no centro dessa transformação. Acompanhar a evolução da TPU Ironwood, da cadeia de suprimentos e da disputa entre empresas será essencial para entender para onde a IA está indo e quem comandará a infraestrutura que sustentará os modelos do futuro.