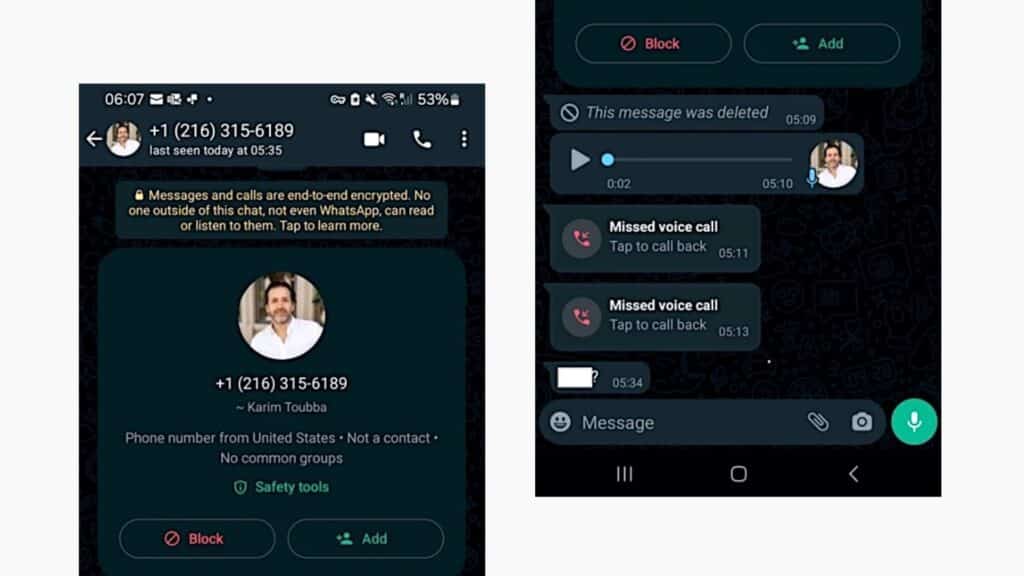

A empresa LastPass revelou esta semana que os agentes de ameaças visaram um de seus funcionários em um ataque de phishing de voz. Os cibercriminosos usaram áudio deepfake para se passar por Karim Toubba, o CEO da empresa.

Funcionário da LastPass atingido por phishing de voz

Embora 25% das pessoas tenham sido vítimas de um golpe de imitação de voz de IA ou conheçam alguém que o tenha feito, de acordo com um estudo global recente, o funcionário do LastPass não caiu nessa porque o invasor usou o WhatsApp, que é um canal de negócios muito incomum.

Ataque de áudio deepfake (LastPass)

Imagem: Reprodução | Bleeping Computer

“No nosso caso, um funcionário recebeu uma série de ligações, mensagens de texto e pelo menos uma mensagem de voz apresentando um áudio falso de um agente de ameaça se passando por nosso CEO via WhatsApp”, disse Mike Kosak, analista de inteligência do LastPass.

Como a tentativa de comunicação estava fora dos canais normais de comunicação empresarial e devido à suspeita do funcionário quanto à presença de muitas das características de uma tentativa de engenharia social (como urgência forçada), nosso funcionário ignorou corretamente as mensagens e relatou o incidente ao nosso equipe de segurança interna para que possamos tomar medidas para mitigar a ameaça e aumentar a conscientização sobre a tática, tanto interna quanto externamente.

Kosak acrescentou que o ataque falhou e não teve impacto no LastPass. No entanto, a empresa ainda optou por compartilhar detalhes do incidente para alertar outras empresas de que deepfakes gerados por IA já estão sendo usados ??em campanhas de fraude de identidade executiva.

O áudio deepfake

O áudio deepfake usado neste ataque provavelmente foi gerado usando modelos de áudio deepfake treinados em gravações de áudio disponíveis publicamente do CEO do LastPass, provavelmente esta disponível no YouTube. O alerta do LastPass segue um alerta do Departamento de Saúde e Serviços Humanos (HHS) dos EUA emitido na semana passada sobre cibercriminosos que atacam os help desks de TI usando táticas de engenharia social e ferramentas de clonagem de voz de IA para enganar seus alvos.

O uso de deepfakes de áudio também permite que os agentes de ameaças tornem muito mais difícil a verificação remota da identidade do chamador, tornando muito difícil detectar ataques em que eles se fazem passar por executivos e funcionários da empresa. Embora o HHS tenha partilhado conselhos específicos para ataques direcionados a centrais de atendimento de TI de organizações do setor da saúde, o seguinte também se aplica a tentativas de fraude de representação de CEO:

- Exija retornos de chamada para verificar funcionários que solicitam redefinições de senha e novos dispositivos MFA.

- Monitore alterações suspeitas de ACH.

- Revalidar todos os usuários com acesso aos sites pagadores.

- Considere solicitações pessoais para assuntos delicados.

- Exija que os supervisores verifiquem as solicitações.

- Treine a equipe de suporte técnico para identificar e relatar técnicas de engenharia social e verificar as identidades dos chamadores.

Em março de 2021, o FBI também emitiu uma Notificação da Indústria Privada (PIN) alertando que deepfakes estavam se tornando cada vez mais sofisticados e provavelmente seriam amplamente empregados por hackers em “operações cibernéticas e de influência estrangeira”. Além disso, a Europol alertou em abril de 2022 que os deepfakes poderão em breve tornar-se uma ferramenta que os grupos cibercriminosos utilizam rotineiramente em fraudes de CEO, adulteração de provas e criação de pornografia não consensual.