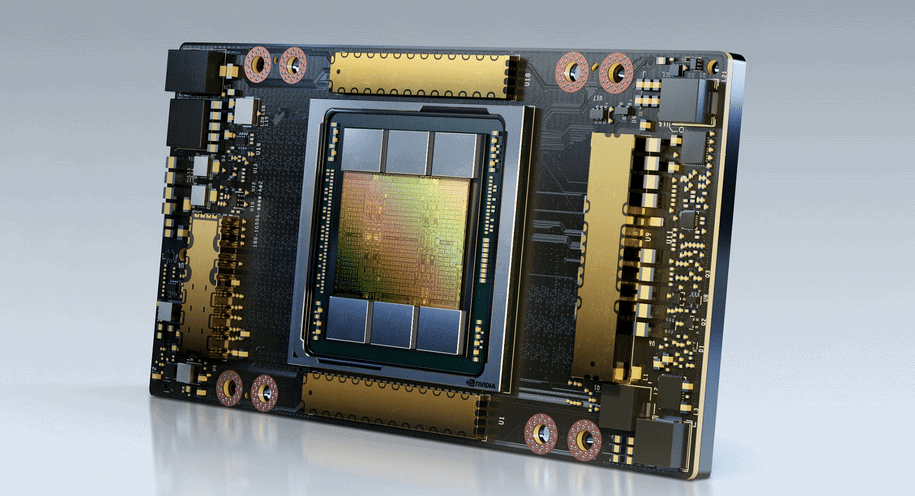

A NVIDIA Enterprise lança a GPU NVIDIA A100 80 GB. Esta é a mais recente inovação para alimentar a plataforma de supercomputação de Inteligência Artificial NVIDIA HG, com o dobro da memória da antecessora, fornecendo a pesquisadores e engenheiros velocidade e desempenho sem precedentes para tornar possível a próxima geração de IA e inovações científicas.

A nova A100 com tecnologia HBM2E duplica a memória de alta largura de banda da GPU A100 40 GB para 80 GB, e fornece mais de 2 terabytes por segundo de largura de banda de memória. Isso permite que os dados sejam alimentados rapidamente para A100, a GPU de data center mais rápida do mundo, permitindo que pesquisadores acelerem seus softwares ainda mais e trabalhem com modelos e conjuntos de dados ainda maiores.

“Atingir resultados avançados em HPC e pesquisa de IA requer a construção de modelos maiores. No entanto, isso demanda mais capacidade de memória e largura de banda do que nunca”, explica Bryan Catanzaro, vice-presidente de pesquisa de deep learning aplicado na NVIDIA. “A GPU A100 de 80 GB oferece o dobro da memória da sua antecessora, lançada há apenas seis meses, e quebra a barreira dos 2 TB por segundo, permitindo que os pesquisadores enfrentem os mais importantes desafios científicos e de big data do mundo.”

A GPU NVIDIA A100 80 GB está disponível nos sistemas NVIDIA DGX A100 e também no mais novo NVIDIA DGX Station A100, anunciado recentemente e previsto para serem disponibilizados neste trimestre.

Os principais fornecedores de sistemas Atos, Dell Technologies, Fujitsu, GIGABYTE, Hewlett Packard Enterprise, Inspur, Lenovo, Quanta e Supermicro começarão a oferecer sistemas com placas integradas HGX A100 com opções de 4 e 8 GPUs A100 80 GB no primeiro semestre de 2021.

“Quanto maior a capacidade, maior o potencial de inovações de IA. A GPU A100 de 80GB quebrou a barreira dos 2 TB por segundo, dando aos pesquisadores e cientistas a capacidade de criar ainda mais e de forma mais rápida”, comenta Marcio Aguiar, diretor da NVIDIA Enterprise para América Latina.

NVIDIA Enterprise dobra a potência e lança a GPU A100 de 80 GB

Ampliando os diversos recursos da A100 de 40 GB, a versão de 80 GB é ideal para uma ampla variedade de softwares que exigem memória de dados de alta capacidade.

Para treinamento de IA, os modelos de sistema de recomendação, como o de recomendação de deep learning (DLRM – Deep Learning Recommendation Model), têm enormes tabelas que representam bilhões de usuários e bilhões de produtos. A A100 de 80 GB oferece uma velocidade até três vezes maior, permitindo às empresas refazerem rapidamente o treinamento desses modelos para fornecerem recomendações altamente precisas.

A A100 de 80 GB permite o treinamento de modelos maiores com mais parâmetros em um único servidor HGX, como o GPT-2, um modelo de processamento de linguagem natural com recursos generativos de texto sobre-humanos. Ela elimina a necessidade de arquiteturas paralelas de modelos ou dados, que podem ter implementação demorada e execução lenta em vários nós.

Com sua tecnologia de GPU multi-instância (MIG), a A100 pode ser particionada em até sete instâncias de GPU, cada uma com 10 GB de memória. Isso fornece um isolamento seguro do hardware e maximiza a utilização de GPU em diversas cargas de trabalho menores. Para inferência de IA em modelos de reconhecimento de fala automáticos como o RNN-T, uma única instância MIG da A100 de 80 GB pode atender a lotes muito maiores, proporcionando uma taxa de transferência de inferência 1,25 vezes maior em produção.

Principais recursos da A100 de 80 GB

A A100 de 80 GB inclui os muitos recursos inovadores da arquitetura NVIDIA Ampere:

- Tensor Cores de terceira geração: oferece até 20 vezes o rendimento na taxa de transferência de IA da geração anterior Volta, com um novo formato de TF32 e 2,5 x FP64 para HPC, 20 vezes a INT8 para inferência de IA e suporte para formato de dados BF16.

- Memória de GPU HBM2e maior e mais rápida: duplica a capacidade de memória e é a primeira do setor a oferecer mais de 2 TB por segundo de largura de banda de memória.

- Tecnologia MIG: duplica a memória por instância isolada, fornecendo até sete MIGs com 10 GB cada.

- Dispersão estrutural: oferece até o dobro da velocidade na inferência de modelos de dispersão.

- NVLink e NVSwitch de terceira geração: fornecem o dobro da largura de banda de GPU para GPU em comparação à geração anterior da tecnologia de interconexão, acelerando as transferências de dados para a GPU em cargas de trabalho que fazem uso intenso de dados a 600 gigabytes por segundo.

Plataforma de Supercomputação de IA NVIDIA HGX

A GPU A100 de 80 GB é um elemento-chave da plataforma de supercomputação de IA NVIDIA HGX, que reúne todo o poder das GPUs NVIDIA, NVIDIA NVLink®, rede NVIDIA InfiniBand e um pacote de software NVIDIA de IA e HPC totalmente otimizado para oferecer o mais alto desempenho de software. Ela permite que pesquisadores e cientistas combinem HPC, análise de dados e métodos de computação de deep learning para impulsionar o progresso científico.

Saiba mais sobre a NVIDIA A100 80 GB na live Apresentação Especial sobre NVIDIA SC20 às 22h (horário de Brasília), hoje (16/11).