Pesquisadores da Universidade de Columbia desenvolveram um novo algoritmo que pode bloquear escutas de áudio não autorizadas por meio de microfones em smartphones, assistentes de voz e dispositivos conectados em geral. O algoritmo pode funcionar de forma preditiva. Ele infere o que o usuário dirá em seguida e gera ruído de fundo audível obstrutivo (sussurros) em tempo real para cobrir o som.

Por enquanto, o sistema funciona apenas com o inglês e tem uma taxa de sucesso de aproximadamente 80%. O volume do ruído é relativamente baixo, minimizando a perturbação do usuário e permitindo conversas confortáveis.

Como os testes do mundo real mostraram, o sistema pode tornar a fala impossível de discernir pela tecnologia de reconhecimento automático de fala, independentemente do software usado e da posição do microfone. O anúncio da universidade também promete desenvolvimento futuro para focar em mais idiomas, onde a linguística permite desempenho semelhante e torna o som do sussurro completamente imperceptível.

Um problema no bloqueio de escutas de áudio atual

Atualmente, os microfones estão incorporados em quase todos os dispositivos eletrônicos e o alto nível de escuta automatizada que os usuários experimentam quando recebem anúncios de produtos mencionados em conversas privadas.

Muitos pesquisadores já tentaram mitigar esse risco usando ruído branco que poderia enganar os sistemas de reconhecimento automático de fala até certo ponto. No entanto, usar qualquer um dos métodos de ocultação de voz em tempo real existentes em situações práticas é impossível, pois o áudio requer computação quase instantânea, o que não é viável com o hardware atual, dizem os pesquisadores.

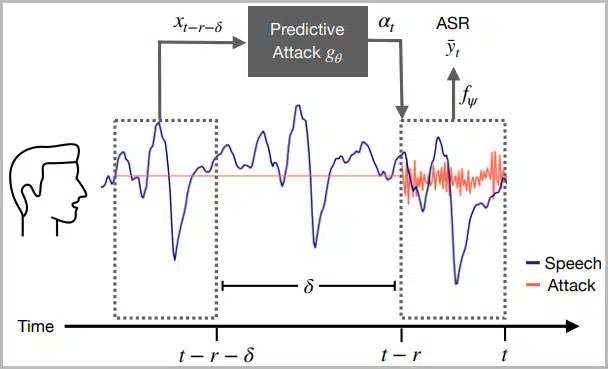

A única maneira de resolver esse problema é desenvolver um modelo preditivo que acompanhe a fala humana, identifique suas características e gere sussurros perturbadores com base em quais palavras são esperadas em seguida.

Camuflagem de voz neural

Com base em modelos de previsão de redes neurais profundas aplicados à ocultação de perda de pacotes, os pesquisadores da Columbia desenvolveram um novo algoritmo baseado no que eles chamam de modelo de “ataques preditivos”. Isso é levar em conta cada palavra falada que os modelos de reconhecimento de fala são treinados para transcrever, prever quando o usuário vai dizer essas palavras e gerar o sussurro no momento certo.

Este estudo e o desenvolvimento de um sistema de interrupção de escuta de fala são a prova de uma falha regulatória sistêmica contra a coleta de dados irrestrita para marketing direcionado. Mesmo que esses sistemas anti-espionagem sejam amplamente empregados no futuro, os desenvolvedores de IA quase certamente tentarão ajustar seus métodos de reconhecimento para superar sussurros perturbadores ou reverter seu efeito.

À medida que a complexidade da situação aumenta, mais difícil se tornará para as pessoas protegerem sua privacidade.

Via: BleepingComputer