O Google diz que tornou possível que um smartphone interprete e “leia em voz alta” a linguagem de sinais. A empresa de tecnologia não criou um aplicativo próprio, mas publicou algoritmos que espera que os desenvolvedores usem para criar seus próprios aplicativos.

Até agora, esse tipo de software só funcionava em PCs. Ativistas da comunidade com deficiência auditiva receberam bem a medida, mas dizem que a tecnologia pode ter dificuldades para entender completamente algumas conversas.

Em um blog da AI, os engenheiros de pesquisa do Google, Valentin Bazarevsky e Fan Zhang, disseram que a intenção da tecnologia de livre publicação era servir de “base para o entendimento da linguagem de sinais”. Foi criado em parceria com a empresa de software de imagem MediaPipe.

Estamos empolgados para ver o que as pessoas estão fazendo. De nossa parte, continuaremos nossa pesquisa para tornar a tecnologia mais robusta e estabilizar o rastreamento, aumentando o número de gestos que podemos detectar com segurança, disse uma porta-voz do Google à BBC.

O Google reconhece que este é um primeiro passo. Os ativistas dizem que um aplicativo que produzia áudio apenas a partir de sinais de mão perderia qualquer expressão facial ou velocidade de assinatura, e isso pode mudar o significado do que está sendo discutido.

Além disso, quaisquer regionalismos que existam em uma área local não serão incluídos. Jesal Vishnuram, gerente de tecnologia da Action on Hearing Loss, diz que a iniciativa é um primeiro passo para ouvir pessoas, mas que precisa ser combinada com outras capacidades.

Do ponto de vista de uma pessoa surda, seria mais benéfico desenvolver software que pudesse fornecer traduções automáticas de texto ou áudio para a língua britânica de sinais (BSL) para ajudar nas conversas do dia a dia e reduzir o isolamento no mundo da audição, disse ele.

Dedos escondidos

Até agora, ao tentar rastrear as mãos no vídeo, a flexão do dedo e os movimentos do pulso escondiam outras partes da mão. Isto confundiu versões anteriores deste tipo de software.

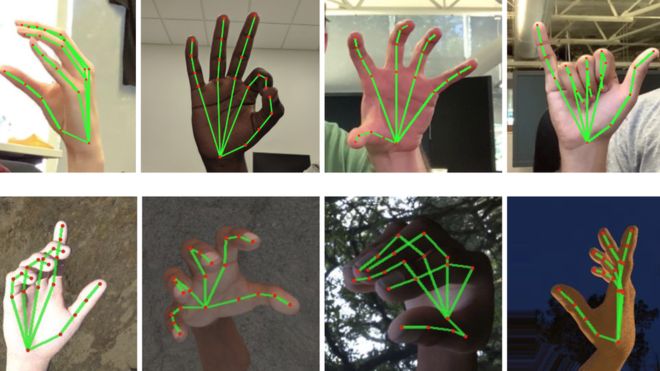

O Google impõe um gráfico em 21 pontos nos dedos, na palma da mão e no verso da mão, facilitando a compreensão de um sinal manual se a mão e o braço se torcerem ou dois dedos se tocarem.

Outros grandes desenvolvedores de software dos EUA desenvolveram tecnologias que tentaram ler em voz alta a linguagem de sinais nos PCs.

No ano passado, a Microsoft uniu-se ao Instituto Técnico Nacional para Surdos para usar computadores de mesa em salas de aula que ajudavam alunos com deficiências auditivas através de um tradutor de apresentações .

Em um blog, os alunos descreveram ter perdido um pouco do que seus professores haviam dito, porque tinham que continuar trocando a atenção dos intérpretes humanos em linguagem de sinais para o que estava sendo escrito no quadro.

Mas, tendo todas as informações de visualização apresentadas por meio de um desktop, o problema foi resolvido. Em outros lugares do mundo, os inovadores criaram sua própria tecnologia doméstica.

Um desenvolvedor de 25 anos de idade no Quênia construiu um par de luvas hápticas que traduzem a linguagem de sinais para um aplicativo Android que lê o texto em voz alta. Roy Allela fez as luvas para sua sobrinha com deficiência auditiva e sua inovação ganhou recentemente um prêmio da Sociedade Americana de Engenheiros Mecânicos. Por ora, não há menção se a linguagem de sinais brasileira terá suporte, ou se haverá planos para o futuro.

Torcemos para que tudo funcione, a proposta é bastante inclusiva, mas precisa de muito polimento e ajuste. No entanto, se mais pessoas começarem a ter interesse pelo assunto, ou até mesmo empresa, teremos por fim um grande avanço no quesito acessibilidade.