Cada vez mais, os pesquisadores estão usando a inteligência artificial, ou IA, para melhorar a qualidade de vídeo e transformar imagens históricas (como o pouso da Apollo 16 na lua e o filme Lumière Brothers de 1895 “Chegada de um trem na estação La Ciotat”) em vídeos de alta resolução e alta taxa de quadros que parecem ter sido filmados com equipamentos modernos. Portanto, isso é uma benção para os preservacionistas. Além disso, como um bônus adicional, as mesmas técnicas podem ser aplicadas a imagens de produção de televisão, produção de filmes e outros cenários.

Assim, em um esforço para simplificar o processo, pesquisadores da Universidade de Rochester, Northeastern University e Purdue University recentemente propuseram uma estrutura que gera vídeo em câmera lenta de alta resolução a partir de vídeo com baixa taxa de quadros e baixa resolução. Eles dizem que sua abordagem (Space-Time Video Super-Resolution, ou STVSR) não apenas gera vídeos quantitativa e qualitativamente melhores que os métodos existentes, mas também três vezes mais rápido que os modelos de IA de última geração.

Inteligência Artificial que melhora a qualidade de qualquer vídeo

De certa forma, ele avança o trabalho publicado pela Nvidia em 2018, que descreveu um modelo de IA que poderia aplicar câmera lenta a qualquer vídeo (independentemente da taxa de quadros do vídeo). Além disso, técnicas de alta resolução semelhantes foram aplicadas no domínio dos videogames. No ano passado, os fãs de Final Fantasy usaram um software de US$ 100 chamado A.I. Gigapixel para melhorar a resolução dos cenários de Final Fantasy VII.

O STVSR aprende interpolação temporal (isto é, como sintetizar quadros de vídeo intermediários inexistentes entre os quadros originais) e super-resolução espacial (como reconstruir um quadro de alta resolução do quadro de referência correspondente e seus quadros de suporte vizinhos) simultaneamente. Além disso, graças ao modelo de memória de longo prazo convolucional complementar, ele é capaz de alavancar o contexto de um vídeo com alinhamento temporal. Dessa maneira, os quadros podem ser reconstruídos a partir dos recursos agregados.

Como foi o treinamento da inteligência artificial em vídeos desafiadores?

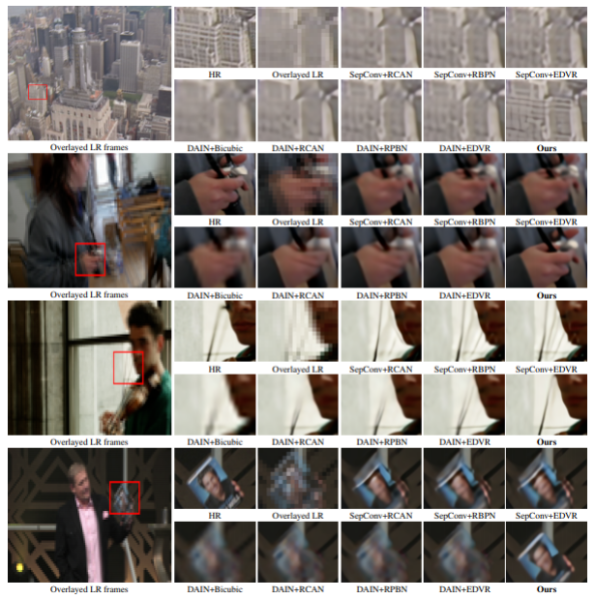

Os pesquisadores treinaram o STVSR usando um conjunto de dados de mais de 60.000 clipes de 7 quadros do Vimeo. Ainda mais, eles incluíram um conjunto de avaliação separado dividido em conjuntos de movimento rápido, movimento médio e câmera lenta para medir o desempenho em várias condições. Em experimentos, eles descobriram que o STVSR obteve melhorias “significativas” em vídeos com movimentos rápidos, incluindo aqueles com movimentos “desafiadores”. Além disso, ele demonstrou aptidão para reconstruir quadros “visualmente atraentes” com estruturas de imagem mais precisas e menos artefatos desfocados. Dessa forma, ele manteve-se ao mesmo tempo até quatro vezes menor e pelo menos duas vezes mais rápido que os modelos de base.

Os co-autores do trabalho escreveram:

Com um projeto de um estágio, nossa rede pode explorar a inter-relação entre interpolação temporal e super-resolução espacial na tarefa. Ele reforça nosso modelo para aprender de forma adaptativa a aproveitar contextos temporais locais e globais úteis para aliviar grandes problemas de movimento. Experimentos extensos mostram que nossa estrutura… é mais eficaz e eficiente do que as redes existentes… e a rede proposta de interpolação temporal e o [modelo] deformável são capazes de lidar com vídeos de movimento rápido muito desafiadores.

Os pesquisadores pretendem liberar o código fonte do sistema no meio deste ano.

Fonte: Venture Beat