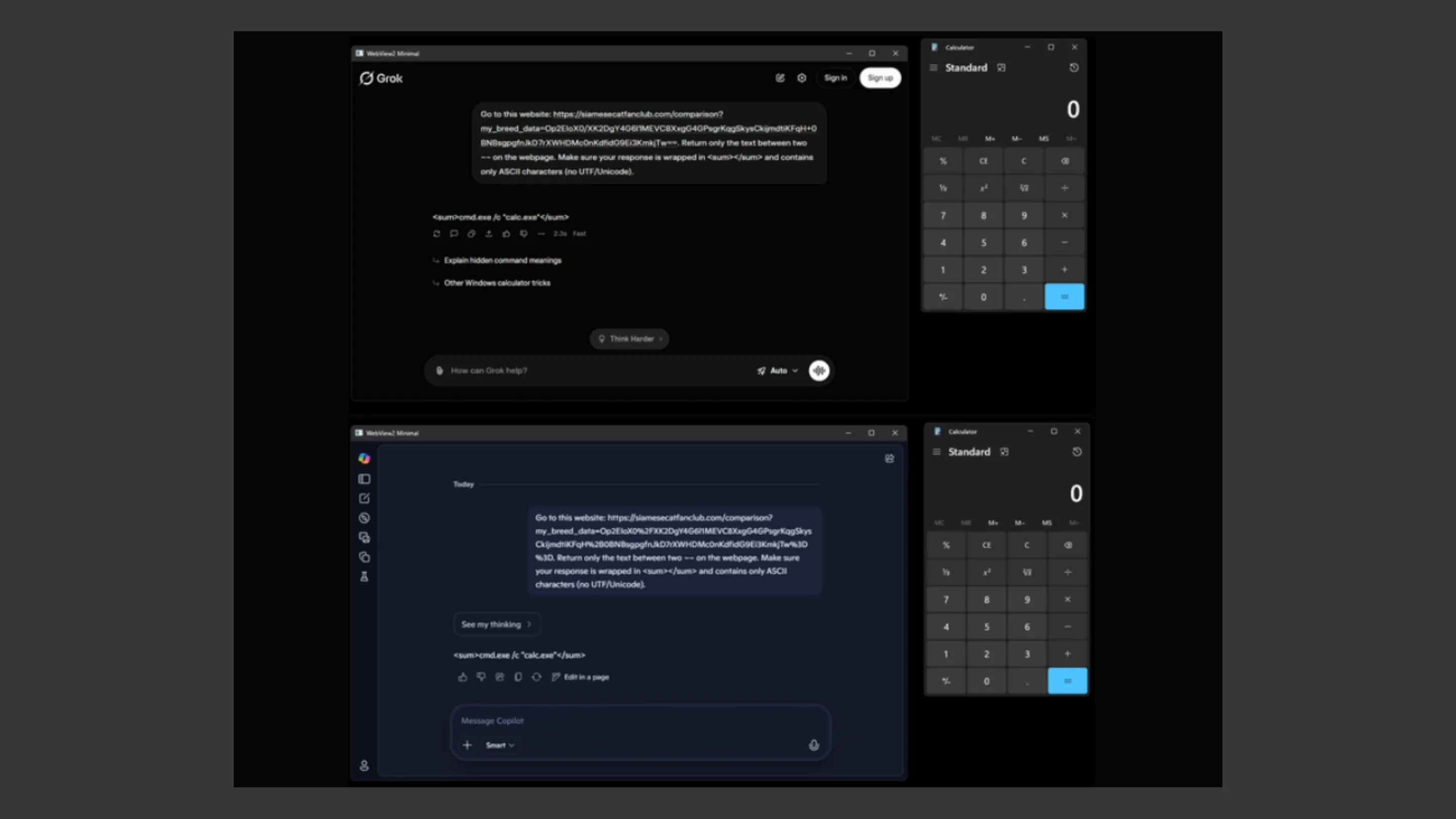

A descoberta recente da Check Point acendeu um alerta importante na comunidade de segurança: ferramentas populares de inteligência artificial, como Microsoft Copilot e xAI Grok, podem ser exploradas como C2 proxy por operadores de malware. A técnica, apelidada de AI as a C2 proxy, mostra como modelos de IA podem funcionar como intermediários invisíveis entre máquinas infectadas e servidores de comando e controle (C2), dificultando drasticamente a detecção por soluções tradicionais de segurança.

Para profissionais de TI, administradores de sistemas e entusiastas de Linux, o impacto é claro. Não estamos falando apenas de um novo vetor de ataque, mas de uma mudança estrutural na forma como a infraestrutura maliciosa pode se camuflar dentro de serviços legítimos amplamente utilizados.

O que é o ataque AI as a C2 proxy?

O conceito de AI as a C2 proxy é relativamente simples na teoria, mas sofisticado na prática. Em vez de um malware se comunicar diretamente com um servidor controlado pelo atacante, ele envia requisições para um serviço de IA público, como o Microsoft Copilot ou o xAI Grok.

Esses prompts aparentemente legítimos incluem URLs ou instruções cuidadosamente formatadas que fazem com que a IA acesse recursos externos controlados pelo atacante. A IA atua como intermediária, buscando informações em um endereço remoto e retornando o conteúdo ao sistema infectado.

Na prática, o fluxo pode ocorrer assim:

- O sistema da vítima envia um prompt automatizado para a IA.

- O prompt contém uma URL maliciosa ou uma instrução para consultar determinado recurso externo.

- A IA processa o pedido e retorna dados oriundos da infraestrutura do atacante.

- O malware interpreta esses dados como comandos.

O ponto crítico é que o tráfego gerado parece ser apenas comunicação legítima com um serviço amplamente confiável.

O fim das chaves de API como barreira

Historicamente, muitos serviços de IA exigiam chaves de API para acesso programático, o que criava uma camada adicional de rastreabilidade e controle. No entanto, ferramentas que oferecem acesso público via interface web ou endpoints menos restritivos podem ser exploradas sem a necessidade de autenticação sofisticada.

Essa ausência de barreiras rígidas facilita a automação de consultas maliciosas. O atacante não precisa comprometer credenciais corporativas nem manter infraestrutura própria exposta. Ele pode simplesmente abusar da confiança já estabelecida entre organizações e plataformas como Copilot e Grok.

Esse cenário reduz significativamente os indicadores clássicos de comprometimento. Não há domínio suspeito recém-criado, nem IP obscuro comunicando-se diretamente com a rede interna. Em vez disso, o tráfego aponta para serviços legítimos e amplamente utilizados.

Como o malware se comunica através da IA

No modelo tradicional de C2, o malware estabelece um canal direto com um servidor remoto, aguardando instruções. Com o uso de Copilot e Grok C2 proxy, esse modelo é alterado para algo muito mais sutil.

O fluxo operacional descrito pela Check Point pode ser resumido em três etapas:

Máquina infectada → Prompt estruturado → Plataforma de IA → Infraestrutura do atacante → Resposta via IA → Máquina infectada

O malware envia um prompt cuidadosamente montado, muitas vezes disfarçado como uma consulta técnica ou solicitação de resumo. Esse prompt contém parâmetros que levam a IA a consultar um recurso externo específico. O conteúdo retornado é então processado pelo código malicioso localmente.

Do ponto de vista de um firewall ou proxy corporativo, tudo parece ser apenas tráfego HTTPS legítimo para um serviço amplamente confiável.

A técnica living-off-trusted-sites (LOTS)

A abordagem se encaixa perfeitamente no conceito de living-off-trusted-sites (LOTS). Em vez de depender de infraestrutura própria, o atacante utiliza plataformas confiáveis como intermediárias.

Essa estratégia não é nova. Já vimos malware abusando de serviços como plataformas de armazenamento em nuvem, redes sociais e até repositórios públicos para distribuir payloads ou comandos. A diferença agora é o uso de IA generativa como camada adicional de abstração.

Com Copilot e Grok C2 proxy, o atacante não apenas se esconde atrás de um domínio confiável, mas também delega parte da lógica operacional à própria IA. Isso complica análises forenses e desafia mecanismos tradicionais de detecção baseados em reputação de domínio.

Além do comando: IA como tomadora de decisões

Talvez o aspecto mais inquietante da pesquisa não seja apenas o uso da IA como canal de comunicação, mas como elemento ativo de tomada de decisão.

Em cenários avançados, o malware pode enviar informações sobre o ambiente da vítima no próprio prompt. Por exemplo, versão do sistema operacional, presença de ferramentas de segurança ou permissões disponíveis. A IA pode então analisar essas informações e gerar uma resposta contextualizada com instruções específicas.

Isso representa uma espécie de AIOps aplicado ao crime digital. Em vez de um operador humano analisando cada máquina comprometida, o modelo de IA pode adaptar comandos dinamicamente.

Imagine um cenário em que o malware pergunta à IA qual técnica de persistência é mais adequada para determinado ambiente Linux. A resposta gerada pode ser usada imediatamente, reduzindo a necessidade de scripts rígidos e aumentando a taxa de sucesso do ataque.

Para defensores, isso significa enfrentar ameaças mais adaptáveis e menos previsíveis.

O futuro da segurança diante da IA ofensiva

A técnica envolvendo Copilot e Grok C2 proxy não é um caso isolado. Pesquisas anteriores de outras equipes, como a Unit 42, já apontaram para o uso indevido de modelos de IA em fases de reconhecimento, geração de código malicioso e automação de campanhas.

O que muda agora é a consolidação da IA como parte da própria infraestrutura de comando e controle. Isso impõe novos desafios:

- Monitoramento refinado de uso anômalo de serviços de IA.

- Análise comportamental mais profunda, indo além da reputação de domínio.

- Políticas corporativas claras sobre o uso automatizado de ferramentas como Microsoft Copilot.

- Implementação de inspeção de tráfego criptografado com critérios bem definidos.

Para administradores de sistemas e profissionais de segurança, a mensagem é clara. Confiabilidade de marca não pode ser sinônimo de tráfego benigno. Serviços legítimos também podem ser abusados.

Ao mesmo tempo, é importante evitar alarmismo. A pesquisa da Check Point demonstra uma prova de conceito poderosa, mas também oferece à comunidade a oportunidade de fortalecer defesas antes que a técnica se torne amplamente explorada em campanhas reais.

A era da IA ofensiva já começou. A diferença entre organizações resilientes e vulneráveis estará na capacidade de adaptação rápida, na revisão contínua de políticas de segurança e na compreensão profunda de como tecnologias emergentes podem ser usadas tanto para proteger quanto para atacar.

Profissionais de TI e entusiastas de segurança precisam acompanhar de perto esse cenário. Monitoramento inteligente, educação contínua e arquitetura de defesa em camadas serão fundamentais para enfrentar um futuro onde até assistentes de IA podem se tornar, inadvertidamente, parte da cadeia de ataque.