Você confia no Google Gemini para se manter informado? Talvez seja melhor pensar duas vezes. A corrida pela supremacia em Inteligência Artificial está cada vez mais acirrada, mas um novo estudo coloca a ferramenta do Google em uma posição embaraçosa.

Um relatório divulgado pela União Europeia de Radiodifusão (EBU) em parceria com a BBC avaliou o desempenho das principais IAs na tarefa de resumir notícias, e o resultado não foi nada favorável ao Gemini. Segundo o estudo, a tecnologia apresentou o pior desempenho entre todos os modelos testados, com “problemas significativos” que afetam diretamente a precisão e a confiabilidade das informações geradas.

Em um momento em que 15% dos jovens com menos de 25 anos já dependem de sistemas de IA para consumir notícias, a precisão deixou de ser um detalhe — é uma necessidade. Vamos entender o que o estudo revelou e por que o Gemini ficou tão atrás de concorrentes como o ChatGPT, o Copilot e o Perplexity.

O estudo que colocou o Gemini na lanterna

O relatório da EBU e da BBC foi conduzido ao longo de seis meses, com o objetivo de avaliar a qualidade dos resumos de notícias gerados por diferentes modelos de IA. A metodologia envolveu a análise de centenas de resumos criados a partir de matérias reais publicadas por veículos de imprensa europeus e britânicos.

Cada resumo foi avaliado em critérios como fidelidade factual, clareza, contextualização, citações corretas e relevância jornalística. O foco era medir o quanto as respostas das IAs ajudavam — ou atrapalhavam — o entendimento da notícia original.

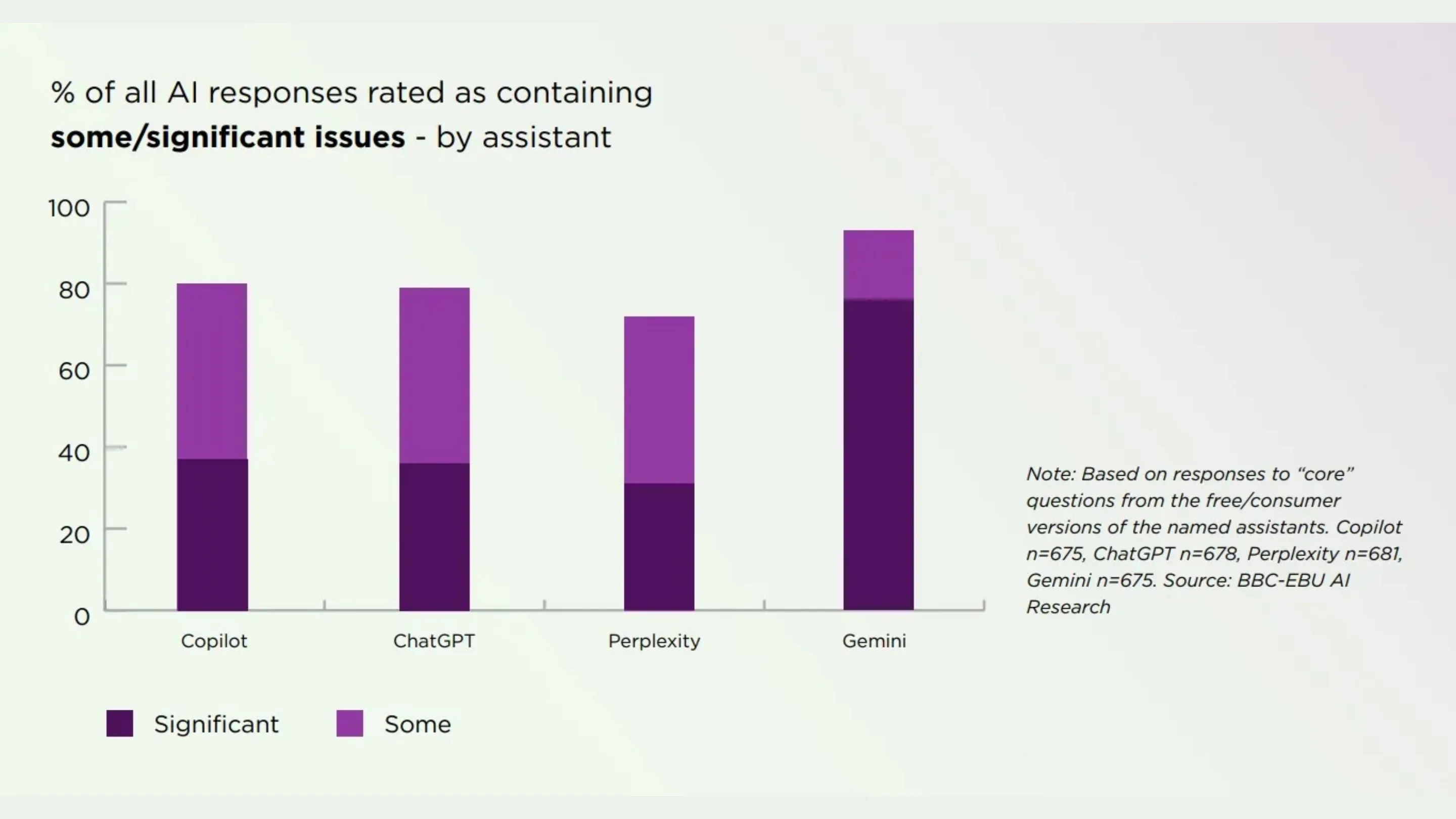

Os resultados mostraram que o Google Gemini foi o “outlier negativo” do estudo. Entre todos os modelos testados, foi o que apresentou maior quantidade de erros factuais e distorções de contexto, sendo o único a entrar na categoria de problemas com “consequências significativas”, segundo o relatório.

Os problemas específicos: por que o Gemini falha nas notícias?

Os pesquisadores destacaram uma série de falhas recorrentes no Gemini, que explicam por que ele ficou tão mal avaliado. Entre os principais problemas, estão:

- Falta de citações: o Gemini tem dificuldade em fornecer links ou referências claras para o material original, o que deixa o leitor sem saber de onde veio a informação.

- Confusão de fontes: em diversos testes, o modelo misturou conteúdo de sites de notícias reais com material satírico, como o The Onion, sem fazer distinção — um erro grave em termos de credibilidade.

- Dependência excessiva: o estudo apontou uma confiança exagerada na Wikipédia como fonte principal, o que reduz a profundidade e a precisão dos resumos.

- Problemas com contexto: o Gemini frequentemente omitindo detalhes cruciais ou alterando o foco da notícia, o que gera interpretações distorcidas.

- Destruição de citações: em alguns casos, as falas originais foram truncadas ou reescritas de forma incorreta, comprometendo o sentido das declarações.

Os analistas classificaram esses erros como estruturais, indicando que não se tratam de simples falhas pontuais, mas de problemas no próprio modelo de linguagem que alimenta o Gemini.

Comparação: como o ChatGPT, Copilot e Perplexity se saíram?

Embora nenhum modelo tenha atingido perfeição, os concorrentes diretos do Gemini — ChatGPT (da OpenAI), Copilot (da Microsoft) e Perplexity — mantiveram desempenhos consistentes e muito superiores.

Segundo o relatório, esses sistemas apresentaram menor taxa de erros factuais e melhor habilidade para preservar o contexto e a estrutura original das matérias. O ChatGPT, em especial, foi elogiado por sua clareza na redação e pela forma como explica a origem das informações.

O Perplexity, por outro lado, se destacou por seu sistema integrado de fontes citadas, que facilita a verificação de fatos — algo que o Gemini ainda não faz de maneira confiável. O Copilot teve desempenho intermediário, mas ainda significativamente melhor que o do modelo do Google.

Mesmo assim, os pesquisadores alertam que todas as IAs ainda cometem erros, e que a verificação humana continua essencial quando se trata de notícias.

A confiança do usuário está em jogo

O estudo também analisou a percepção pública sobre a confiabilidade das IAs. Segundo os dados, 42% dos adultos afirmam confiar na precisão dos resumos gerados por sistemas de inteligência artificial. No entanto, 84% dizem que a descoberta de erros factuais ou distorções afetaria seriamente essa confiança.

Esse cenário é particularmente preocupante para o Google, que vem enfrentando críticas recorrentes sobre a qualidade das respostas do Gemini e de outros produtos de IA. As chamadas Visões Gerais de IA (AI Overviews) — recurso experimental integrado ao buscador — também sofreram críticas após apresentarem respostas alucinadas ou incorretas, incluindo recomendações perigosas e desinformação.

Juntos, esses episódios formam um padrão preocupante: a marca Google, historicamente associada à precisão e confiança, corre o risco de perder credibilidade em um dos campos mais estratégicos da era digital.

Conclusão: o Google precisa correr atrás do prejuízo

O estudo da EBU/BBC serve como um alerta contundente para o Google. Embora o relatório reconheça que o Gemini apresentou algumas melhorias ao longo do período de observação, ele ainda termina a corrida muito atrás dos rivais em termos de confiabilidade e precisão informativa.

Na era em que as pessoas estão cada vez mais dependentes da IA para se informar, a confiabilidade é a nova moeda de valor. Se o Google não conseguir resolver esses problemas, o Gemini pode acabar se tornando um exemplo do que não fazer no campo da inteligência artificial aplicada ao jornalismo.

E você? Diante desses resultados, ainda confia no Google Gemini para se manter informado? Deixe sua opinião nos comentários e participe da discussão sobre o futuro da IA nas notícias.