A discussão sobre IA no open source costuma girar em torno de licença, autoria e qualidade. Só que, enquanto parte do ecossistema debate “pode ou não pode”, a Canonical já deu um passo prático: está usando GitHub Copilot para ajudar a modernizar a infraestrutura do Ubuntu Error Tracker. O detalhe mais importante é também o que mais preocupa usuários: a IA está mexendo no código, não lendo seus crash dumps.

A reforma do código legado com IA

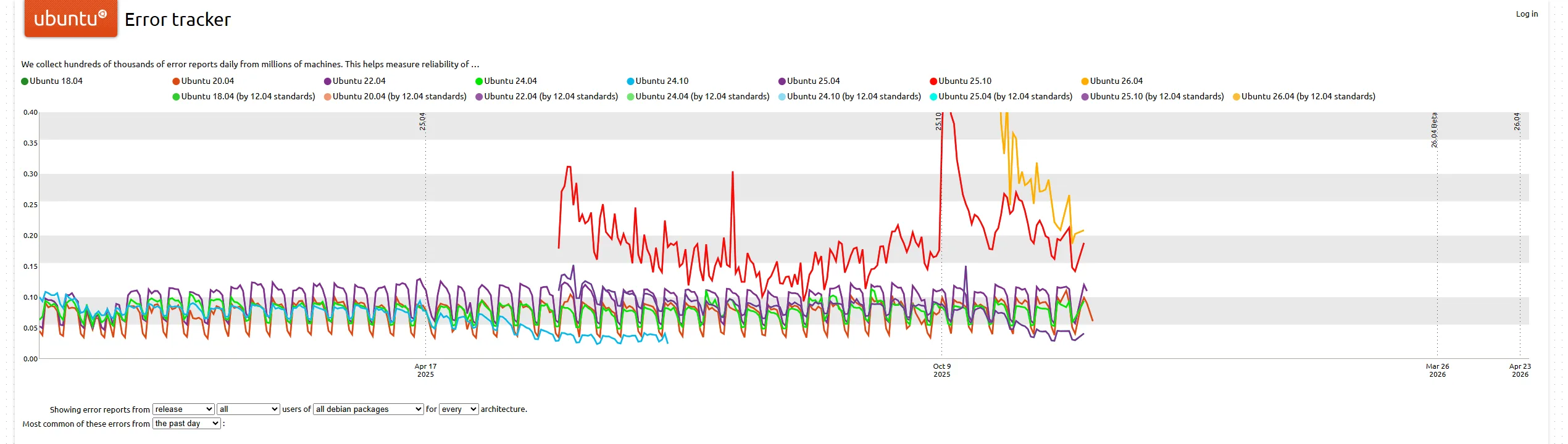

O Ubuntu Error Tracker é, na prática, um sistema de observabilidade de falhas em escala de distribuição. Ele agrega sinais de travamentos e erros severos, organiza esses eventos e ajuda a apontar, no macro, onde a confiabilidade de uma versão do Ubuntu está piorando ou melhorando. Para isso, ele depende de uma base de dados de alto volume, historicamente em Apache Cassandra, e de um backend que ficou preso em decisões antigas.

É aí que entra o “pagar dívida técnica”. Em engenharia de software, technical debt é como deixar um conserto provisório virar parte estrutural da casa. No começo você economiza tempo, depois começa a pagar juros em forma de bugs estranhos, bibliotecas abandonadas e medo de tocar no código. Em maio de 2025, um engenheiro da equipe Foundations descreveu trabalhar nesse sistema como “doloroso”, citando explicitamente a combinação de banco “altamente inconsistente” com Python 2.7 e Django 1.11.

Agora, no fim de novembro e começo de dezembro de 2025, esse débito está sendo atacado com uma ferramenta que, até pouco tempo, muitos projetos tratavam como “tabu”: um agente do Copilot. O exemplo concreto é a migração do uso do Cassandra no backend, saindo de uma biblioteca depreciada (pyCassa) para o driver moderno (cassandra-driver) com uma abordagem mais “ORM-like”. Em um pull request público do repositório do error-tracker, o Copilot aparece como autor do trabalho, com uma sequência de commits e uma lista detalhada do que foi migrado e ajustado.

O sinal de fundo é ainda mais DevOps do que “IA escrevendo código”. No update semanal de 27 de novembro de 2025, o mesmo desenvolvedor comenta ter colocado no ar uma versão de staging do serviço “daisy” e destaca que a parte pesada de infraestrutura, como Terraform, DNS, roteamento e firewalling, já estava encaminhada. Ou seja, não é um “experimento de laboratório”: é modernização operacional, com automação e pipeline de infra, e a IA aparecendo como uma chave de fenda extra para acelerar refactoring.

Pense na analogia do prédio antigo e vital: o Error Tracker é o edifício que precisa ficar em pé o tempo todo. O Ubuntu “contratou um robô” para ajudar a trocar a fiação velha. O robô pode sugerir como reorganizar os fios e trocar disjuntores, mas ainda cabe ao eletricista, o maintainer humano, aprovar o serviço, testar e garantir que nada pegou fogo.

Calma: seus dados estão seguros

A parte mais sensível desse assunto não é “IA em infraestrutura”, é privacidade. E aqui vale ser cristalino: o que foi relatado até agora é o uso de IA para refatoração e migração de código, não para processar dados de usuários.

O ecossistema do Error Tracker existe justamente porque o Ubuntu separa duas coisas: coleta de sinais e análise pública em nível agregado. Na arquitetura clássica descrita pela comunidade, o fluxo envolve componentes como o Apport (interface de desktop), o Whoopsie (daemon que envia relatórios) e serviços do lado do servidor que processam e “bucketizam” falhas para apresentar estatísticas e tendências. Esse desenho também tenta minimizar exposição: o próprio documento de arquitetura do servidor descreve uma lógica em que um core dump completo só é solicitado quando necessário, para evitar que a maioria dos usuários tenha que enviar um arquivo enorme.

Do lado do usuário, há controles e transparência operacional. A documentação da comunidade descreve onde ver relatórios enviados (“mostrar relatórios anteriores”) e como o sistema foi pensado para não prometer um retorno individual para cada envio, reforçando que o objetivo é reduzir o tempo de descoberta e correção dos problemas mais comuns.

Onde a IA entra nisso? Entra na oficina, não na caixa de correio. Até aqui, não há indicação pública de que crash dumps, relatórios enviados ou dados sensíveis estejam sendo alimentados em modelos. O ponto que merece destaque editorial é justamente este: “Copilot ajudando a migrar módulo Cassandra” é uma fala sobre código-fonte e manutenção, não sobre ingestão de telemetria por IA.

Pragmatismo (Ubuntu) vs. proibição (Gentoo)

O contraste fica mais nítido quando colocamos Ubuntu ao lado do Gentoo Linux. Em abril de 2024, o Gentoo aprovou uma política que proíbe explicitamente contribuições que tenham sido criadas com assistência de ferramentas de IA baseadas em NLP, citando preocupações de copyright, ética e qualidade, e deixando a porta aberta para revisitar o tema caso surja uma ferramenta que não carregue esses riscos.

O Ubuntu, por sua vez, não fez (até o que está visível externamente) um grande anúncio de política geral. O que aparece é uma decisão pragmática e localizada: usar o assistente para destravar um gargalo real, em um sistema legado, com um escopo claro e verificável. Isso muda o debate em um ponto crucial: a discussão não é só “aceitar ou banir IA”, mas “em que superfície do projeto isso acontece”.

Infraestrutura interna é uma superfície diferente de aceitar patches de terceiros para a árvore oficial de uma distro. No primeiro caso, o projeto pode tratar IA como ferramenta de produtividade sob supervisão direta, com revisão e testes. No segundo, como o Gentoo argumenta, o risco jurídico e o custo de revisão podem explodir, e a política vira um mecanismo de proteção do processo comunitário.

Se existe um “tabu quebrado” aqui, ele é menos filosófico e mais operacional: o Ubuntu está normalizando o uso de IA como ferramenta de modernização de sistemas críticos, sem transformar isso em marketing e sem misturar o tema com dados dos usuários. Para o mundo open source, isso sugere uma tendência: projetos podem acabar adotando políticas mais granulares, permitindo IA em refactoring de infraestrutura e restringindo IA em contribuições externas, ou exigindo declarações explícitas, dependendo do perfil de risco.