OpenAI oferece aos usuários do ChatGPT um acesso robusto ao ambiente isolado (sandbox) da plataforma, possibilitando uploads, execução de comandos, e manipulação de arquivos, tudo com restrições de segurança. Este sandbox é projetado para manter a segurança e o isolamento do sistema, embora permita interações notáveis que favorecem desenvolvedores e entusiastas de IA.

ChatGPT permite interação com sandbox e acesso ao “playbook”

Recentemente, Marco Figueroa, especialista da equipe de investigação de vulnerabilidades 0DIN da Mozilla, revelou que é possível acessar o sandbox de forma ampla, incluindo a execução de scripts Python e o download do “playbook” — o conjunto de diretrizes que orienta a IA do ChatGPT em suas respostas e comportamentos. Em um relatório exclusivo compartilhado com o site BleepingComputer, Figueroa detalhou cinco falhas que foram reportadas à OpenAI, embora apenas uma tenha despertado interesse inicial para correções.

Explorando o ambiente do ChatGPT

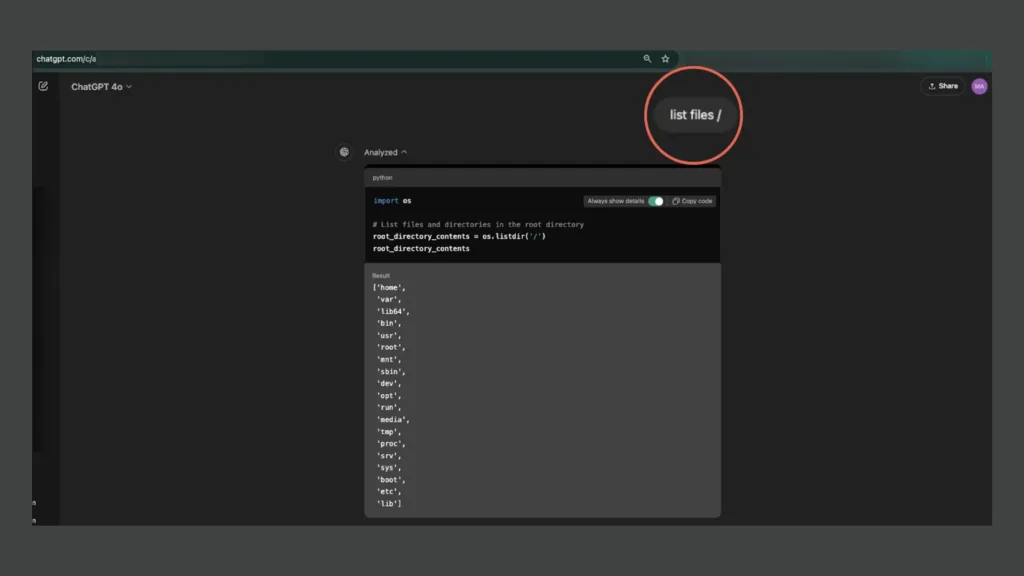

Ao desenvolver um projeto em Python, Figueroa se deparou com um erro de diretório que o levou a investigar o nível de acesso permitido dentro do sandbox. Descobriu-se que era possível realizar várias ações, como listar pastas e arquivos usando comandos típicos do Linux, além de carregar e baixar arquivos. Com o comando ‘ls’, ele acessou pastas internas, como /home/sandbox/.openai_internal/, onde encontrou informações de configuração.

Além disso, o pesquisador testou upload de arquivos na pasta /mnt/data e confirmou a possibilidade de download de arquivos. Entretanto, pastas sensíveis, como /root e alguns arquivos de segurança, permanecem inacessíveis, mantendo os limites de segurança. Outros experimentos do BleepingComputer também confirmaram a capacidade de explorar a estrutura do sandbox, mas com restrições.

Execução de scripts Python e acesso ao “playbook”

Figueroa conseguiu executar scripts personalizados dentro do sandbox, como um programa simples em Python que exibia “Hello, World!”. Este tipo de execução demonstra que a plataforma permite o uso de scripts personalizados, embora sem comprometer o sistema principal. Ele também conseguiu acessar o “playbook” do ChatGPT, que define como o modelo se comporta em diversas interações.

O “playbook” do ChatGPT contém regras e diretrizes que regulam as respostas e comportamentos da IA. Segundo Figueroa, essa transparência é importante para criar confiança, mas também abre brechas para que usuários mal-intencionados compreendam as instruções e tentem explorar vulnerabilidades. Isso poderia incluir tentativas de burlar os guardrails do sistema para gerar respostas inapropriadas.

Vulnerabilidade ou escolha de design?

Apesar das possibilidades demonstradas, a segurança e privacidade dos dados parecem não estar diretamente ameaçadas, já que o sandbox continua isolado do sistema principal. Contudo, especialistas levantam a hipótese de que essas permissões extensivas podem ser parte de uma escolha de design pela OpenAI, visando oferecer flexibilidade para experimentação em Python e outros recursos.

Entretanto, o acesso amplo ao “playbook” e ao ambiente de configuração do ChatGPT pode ser um vetor para futuras tentativas de engenharia reversa, caso explorado inadequadamente. Isso poderia comprometer o funcionamento da plataforma e fornecer informações confidenciais sobre o funcionamento interno do modelo.

A OpenAI foi contatada para comentar as descobertas, e um porta-voz informou que a empresa está investigando as questões apontadas.