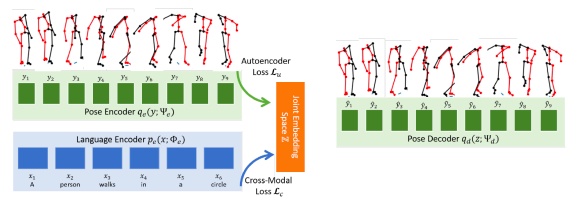

Pesquisadores de Inteligência Artificial (IA) da Universidade Carnegie Mellon criaram um agente com IA que é capaz de traduzir linguagem, ou palavras, em movimento físico. Dessa forma, chamada de Joint Language-to-Pose, ou JL2P, a abordagem combina linguagem natural com modelos de pose em 3D.

Como o JL2P traduz linguagem em movimento físico

Hoje, as animações do JL2P estão limitadas a bonecos de palitos. Porém, a habilidade de traduzir palavras em movimentos humanos pode algum dia ajudar robôs humanoides a fazer tarefas físicas no mundo real. Igualmente, ele poderá ajudar pessoas criativas na animação de personagens virtuais para coisas como videogames e filmes.

O JL2P está em conformidade com trabalhos anteriores que transformam palavras em imagens — como o ObjGAN da Microsoft, que desenha imagens e storyboards a partir de legendas, e do GauGAN da Nvidia, que permite que usuários pintem paisagens usando pincéis marcados com palavras como “árvores”, “montanhas” ou “céu”.

Além disso, o JL2P é capaz de fazer coisas como caminhar e correr, tocar instrumentos musicais (como uma guitarra ou violino), seguir instruções de direção (esquerda ou direita), ou controlar velocidade (rápido ou devagar). Posteriormente, o trabalho originalmente detalhado em um artigo de 2 de julho no site arXiv.org, será apresentado pelo coautor e pesquisador do Instituto de Tecnologia de Linguagem CMU, Chaitanya Ahuja, em 19 de setembro na Conferência Internacional de Visão 3D em Quebec.

O artigo diz:

Nós primeiro otimizamos o modelo para predizer passos de tempo condicionados à sentença completa. Assim, essa tarefa fácil ajuda o modelo a aprender sequências de pose muito curtas. Por exemplo, os movimentos das pernas para caminhar, movimentos das mãos para acenar e movimentos do tronco para se curvar.

Algumas demonstrações da IA do JL2P

O JL2P alega 9% de melhora sobre o modelo de movimento humano comparado com a IA de última geração proposta por pesquisadores da SRI International em 2018.

O JL2P é treinado usando o conjunto de dados KIT Motion-Language.

O conjunto de dados foi introduzido em 2016 pela High Performance Humanoid Technologies na Alemanha. Dessa forma, ele combina movimento humano com descrições de linguagem natural que mapeiam 11 horas de movimento humano gravado para mais de 6.200 frases em inglês com aproximadamente 8 palavras cada.

Afinal, você gostou de conhecer essa nova IA com uma abordagem diferente, que traduz linguagem em movimento físico?

Não deixe de compartilhar!

Fonte: Venture Beat

Leia também: Inteligência Artificial traduz arte visual em melodias