Pesquisadores da Universidade de Massachusetts Amherst e Stanford afirmam que desenvolveram uma nova estrutura algorítmica que garante que a Inteligência Artificial (IA) não se comportará mal.

A estrutura usa algoritmos Seldonian, nomeados em homenagem ao protagonista da série Foundation de Isaac Asimov, uma continuação do universo fictício em que as “Laws of Robotics” (Leis da Robótica) do autor apareceram pela primeira vez.

Nova estrutura de IA para controlar as máquinas

De acordo com a pesquisa da equipe, a arquitetura Seldonian permite que os desenvolvedores definam suas próprias condições operacionais, a fim de impedir que os sistemas ultrapassem certos limites durante o treinamento ou a otimização. Em essência, isso deve permitir que os desenvolvedores impeçam os sistemas de IA de prejudicar ou discriminar seres humanos.

Os sistemas de deep learning oferecem tudo, desde reconhecimento facial a previsões do mercado de ações. Na maioria dos casos, como reconhecimento de imagem, não importa realmente como as máquinas tiram suas conclusões desde que estejam corretas. Se uma IA puder identificar gatos com 90% de precisão, provavelmente consideraremos isso um sucesso. Mas quando se trata de assuntos de maior importância, como algoritmos de IA que automatizam a dosagem de medicamentos, há pouca ou nenhuma margem para erro.

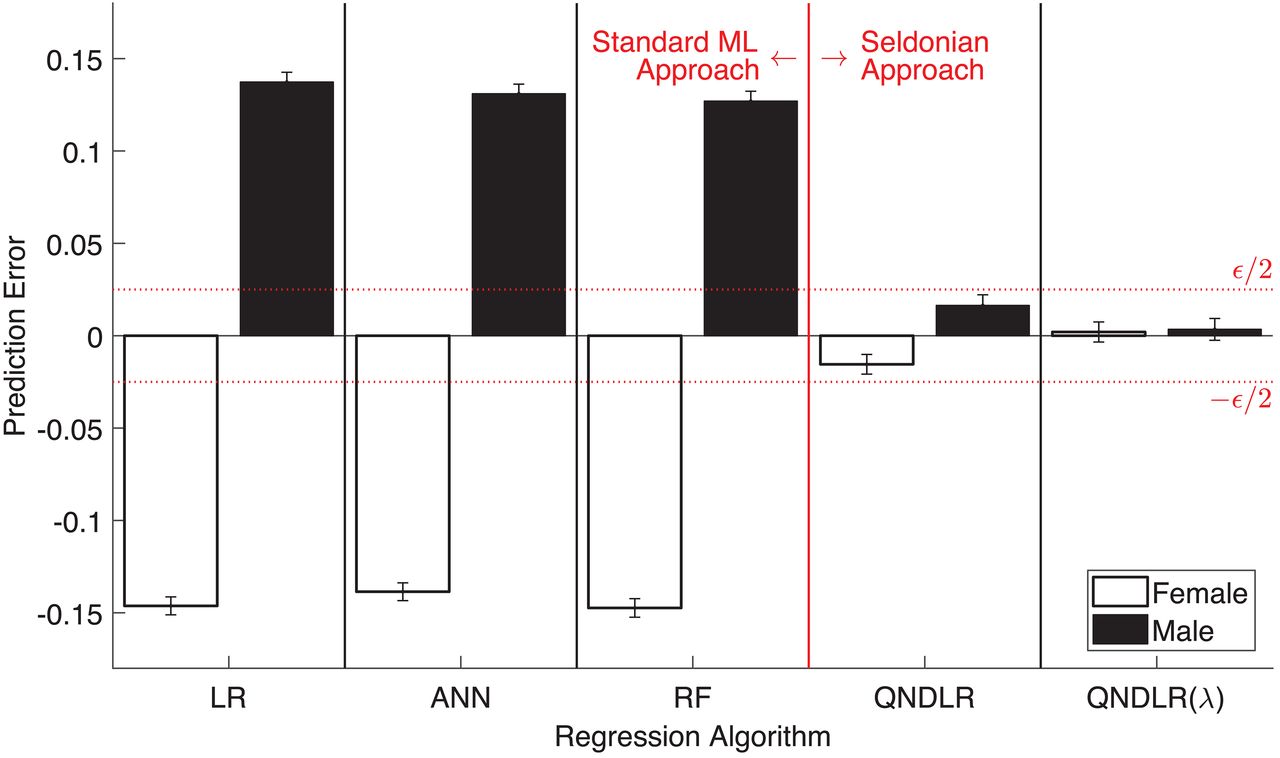

Para esse fim, os pesquisadores usaram sua estrutura de algoritmo Seldonian para criar um sistema de IA que monitora e distribui insulina em diabéticos e outro que prevê as notas de alunos. No primeiro, os pesquisadores instituíram a estrutura seldoniana para garantir que o sistema não enviasse pacientes a um acidente enquanto aprendia a otimizar a dosagem. E no último, eles procuraram evitar o viés de gênero.

O uso do algoritmo em casos reais

Ambos os experimentos se mostraram eficazes e, de acordo com os pesquisadores, demonstraram com sucesso que os algoritmos seldonianos podem inibir comportamentos indesejados.

O atual paradigma de desenvolvimento de IA coloca o ônus de combater o viés no usuário final. Por exemplo, o software Rekognition da Amazon, uma tecnologia de reconhecimento facial usada pela polícia, funciona melhor se o limite de precisão for diminuído, mas demonstra um viés racial claro em tais níveis. Os policiais que usam o software precisam escolher se desejam usar a tecnologia de forma ética ou bem-sucedida.

A estrutura Seldonian deve tirar esse fardo do usuário final e colocá-lo onde ele pertence: aos desenvolvedores. Assim, ao incluir os algoritmos de mitigação adequados (por exemplo, algo que diz à máquina: “encontre rostos sem viés racial”) seria eliminado o potencial de viés prejudicial e, ao mesmo tempo, permitiria que o software funcionasse.

Isso é feito matematicamente. Os pesquisadores demonstram vários algoritmos simples que expressam comportamentos indesejados em termos que a máquina pode entender. Portanto, em vez de dizer a uma máquina “não permita que o viés de gênero afete suas previsões de [notas de alunos]”, os algoritmos seldonianos expressam o problema mais como “preveja com precisão [as notas de todos os alunos], mas não deixe que as diferenças entre [as notas previstas dos alunos] e [as notas reais dos alunos] excedam um certo limiar quando o sexo é levado em consideração”.

Nova estrutura de IA e as suas implicações imediatas

Os pesquisadores esperam que, com um maior desenvolvimento, a estrutura possa fazer mais do que apenas revisar a atual tecnologia de IA. Assim, de acordo com o artigo da equipe:

Os algoritmos projetados usando nossa estrutura não substituem apenas os algoritmos de machine learning em aplicativos existentes; é nossa esperança que eles preparem o caminho para novas aplicações para as quais o uso de machine learning era anteriormente considerado muito arriscado.

As implicações para a tecnologia de curto prazo, como carros sem motorista e robôs trabalhadores autônomos, são enormes; este é essencialmente o fundamento das “Leis da Robótica” de Asimov. Se os desenvolvedores puderem garantir que as máquinas que usam machine learning não captem comportamentos perigosos ou, de repente, decidam otimizar sua programação de maneiras que envolvem machucar ou aprisionar humanos, poderíamos estar à beira de uma era de ouro da IA.

Neste artigo, você viu que os cientistas desenvolveram uma nova estrutura de IA para impedir que as máquinas se comportem mal.

Fonte: The Next Web

Leia também:

O Google usará Inteligência Artificial para otimizar a frequência com que os usuários veem anúncios